A Survey of Techniques for Maximizing LLM Performance

Summary

TLDR本视频讨论了如何优化大型语言模型(LLMs)的微调过程,强调了数据收集、训练方法和评估的重要性。讲者分享了在Spider 1.0基准上的应用实例,通过基础的提示工程和先进的检索增强生成技术(RAG),显著提高了模型的表现。最终,强调了微调和RAG的结合可以有效提升模型性能,指出了该过程的迭代性和灵活性,鼓励使用者在优化中不断探索。

Takeaways

- 😀 数据集的质量至关重要,收集高质量的数据集是成功的基础。

- 😀 在训练过程中,要注意超参数的选择,以防过拟合或欠拟合。

- 😀 评估模型时,可以通过人类专家评分或其他模型的排名来进行。

- 😀 使用反馈循环,可以不断优化模型,通过新数据进行进一步调优。

- 😀 开始时应优先进行提示工程和少样本学习,以降低成本和风险。

- 😀 确立基线模型是进入细调的第一步,有助于了解模型的优缺点。

- 😀 细调与RAG技术相结合,可以显著提高模型的效率和性能。

- 😀 实验过程中要保持灵活性,可能需要多次迭代以达到理想效果。

- 😀 在处理复杂问题时,简单的方法往往能带来意想不到的改进。

- 😀 在进行细调时,应关注高质量的少量样本,而非大规模的低质量数据。

Q & A

什么是模型微调的主要目的?

-模型微调的主要目的是使语言模型的输出行为更符合特定需求,通过使用相关数据来调整模型的表现。

在微调过程中,数据集的选择有多重要?

-数据集的选择至关重要,因为高质量的数据能够显著提升模型的性能,而低质量的数据可能导致错误的结果。

什么是超参数,为什么它们在训练过程中重要?

-超参数是控制训练过程的设置,如学习率和批量大小。它们的重要性在于适当的调整可以防止过拟合和灾难性遗忘。

如何评估微调后的模型性能?

-可以通过专家评估、模型输出排名和使用更强大的模型进行输出评估来评估微调后的模型性能。

什么是反馈循环,如何在模型微调中应用?

-反馈循环是指训练、评估和部署之间的连续过程,通过在生产环境中收集数据并进行再训练,从而不断优化模型。

什么是 RAG,它在模型微调中如何发挥作用?

-RAG(检索增强生成)是一种结合检索和生成的技术,通过从外部知识库检索相关信息来增强模型的上下文理解。

在开始微调之前,为什么要先进行提示工程?

-提示工程可以帮助快速迭代,了解模型的基本表现,并为后续的微调奠定基础。

Spider 1.0 基准测试中使用了哪些技术?

-在Spider 1.0基准测试中,使用了简单的提示工程、RAG和自我一致性检查等技术,显著提高了模型的性能。

微调和 RAG 的结合如何优化模型性能?

-结合微调和 RAG 可以减少对复杂提示的需求,同时提高模型的上下文使用效率,从而提升整体性能。

微调过程是否是线性的?

-微调过程不是线性的,通常需要在不同技术之间来回切换,以找到最佳解决方案。

Outlines

此内容仅限付费用户访问。 请升级后访问。

立即升级Mindmap

此内容仅限付费用户访问。 请升级后访问。

立即升级Keywords

此内容仅限付费用户访问。 请升级后访问。

立即升级Highlights

此内容仅限付费用户访问。 请升级后访问。

立即升级Transcripts

此内容仅限付费用户访问。 请升级后访问。

立即升级浏览更多相关视频

A little guide to building Large Language Models in 2024

大语言模型微调之道1——介绍

Stream of Search (SoS): Learning to Search in Language

How Did Dario & Ilya Know LLMs Could Lead to AGI?

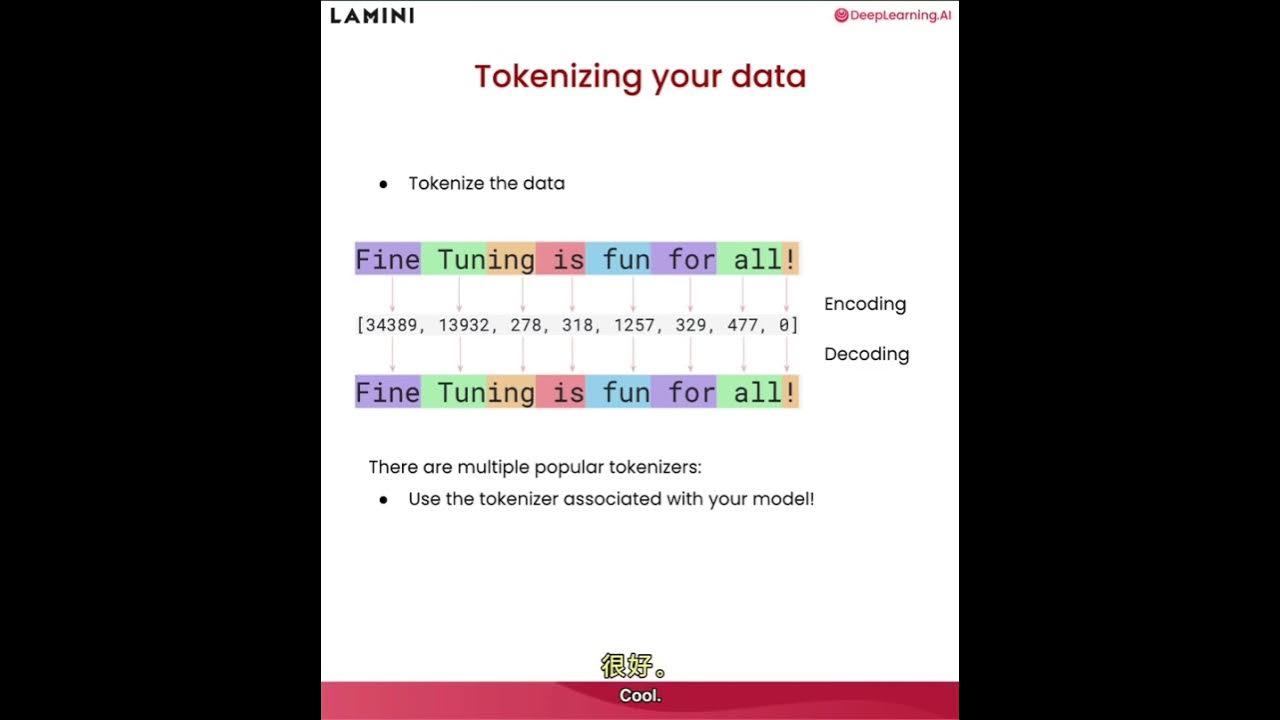

大语言模型微调之道5——准备数据

What are Transformer Models and how do they work?

Networking for GenAI Training and Inference Clusters | Jongsoo Park & Petr Lapukhov

5.0 / 5 (0 votes)