What are Transformer Models and how do they work?

Summary

TLDR本视频详细介绍了Transformer模型的工作原理,包括自注意力机制、位置编码和词嵌入等关键概念。它深入探讨了Transformer如何通过大量数据和复杂架构进行训练,以生成准确的输出。此外,视频还强调了微调(fine-tuning)的重要性,解释了如何通过定制数据集优化模型,使其在特定任务中表现更佳。最后,视频提到了一些Transformer应用中的挑战,如回答问题和执行命令等,并提供了进一步学习的资源。

Takeaways

- 😀 变换器(Transformer)模型是一种强大的神经网络架构,广泛应用于自然语言处理任务。

- 😀 词嵌入(Embedding)将单词转换为向量表示,使计算机能够理解和处理文字的语义。

- 😀 位置编码(Positional Encoding)解决了序列数据中单词顺序丧失的问题,帮助模型理解词语的相对位置。

- 😀 注意力机制(Attention Mechanism)使得模型能够关注输入序列中最重要的部分,提升预测准确性。

- 😀 多头注意力(Multi-head Attention)通过并行计算多个注意力层来捕捉数据中的不同关系。

- 😀 软最大化(Softmax)将神经网络输出的原始分数转换为概率,使模型可以选择最可能的下一个单词。

- 😀 Transformer架构通过多个注意力层和前馈层的堆叠来理解和生成序列数据。

- 😀 预训练和微调(Fine-tuning)是训练Transformer模型的核心流程,前者利用大量数据进行预训练,后者则针对特定任务进行调整。

- 😀 微调可以帮助模型更好地执行特定任务,例如问答、对话生成或命令执行。

- 😀 互联网数据可能杂乱无章,微调过程中需要使用定制的数据集来帮助模型适应特定应用场景。

- 😀 Transformer的训练成本较高,特别是微调过程中需要人工创建和处理大量定制数据集。

Q & A

什么是Transformer模型的核心原理?

-Transformer模型的核心原理是基于自注意力机制(Attention Mechanism),通过权衡不同输入元素的相对重要性来生成预测结果。它利用位置编码(Positional Encoding)来保持序列的顺序,并通过多层堆叠的自注意力和前馈网络来处理复杂的语言任务。

为什么Transformer模型要使用位置编码?

-因为Transformer模型本身不具备处理序列顺序的能力,位置编码用于提供序列中每个元素的位置信息,使得模型能够理解词语在句子中的顺序。这样,即使是相同的词语,出现在不同位置时也能有不同的语义含义。

Transformer中的自注意力机制是如何工作的?

-自注意力机制通过计算输入序列中每个词的'权重',让模型在生成预测时能够专注于句子中最相关的词。每个词与其他词之间的关系决定了它在生成下一个词时的影响力,从而生成更具上下文相关性的输出。

什么是Softmax函数在Transformer模型中的作用?

-Softmax函数将Transformer模型的输出转换为一个概率分布,确保模型能够选择最可能的下一个词。它通过对输出进行规范化,使得所有可能的词的概率之和为1,从而使模型能够做出合理的预测。

Transformer架构中有多少层?每层的作用是什么?

-Transformer模型通常由多个'Transformer块'组成,每个块包含两个主要部分:自注意力机制和前馈神经网络。每一层的作用是通过不同的注意力机制和神经网络处理输入数据,逐步提取出上下文信息,并最终生成高质量的输出。

Transformer模型的训练过程中为什么需要精细调整(fine-tuning)?

-因为Transformer模型通常是基于大量的通用数据(如互联网数据)训练的,这些数据可能不适合特定任务。通过精细调整,可以使用特定领域的数据(如问答数据集或对话数据集)来优化模型,使其在某个特定任务上表现更好。

在进行精细调整时,模型应该如何处理问题和答案的关系?

-在精细调整模型时,特别是在问答任务中,需要使用专门的问答数据集,确保模型学会在遇到问题时生成正确的答案,而不仅仅是根据问题的上下文预测下一个词。这需要通过人工创建和整理精确的问答数据来实现。

为什么训练Transformer模型时,使用互联网数据可能会带来问题?

-互联网数据包含大量不结构化的信息,这些信息多样且缺乏针对性。在训练过程中,模型可能无法有效学习如何回答特定问题或执行特定任务,因为互联网内容的多样性使得模型难以判断最合适的下一个词或回答。

Transformer模型如何通过聊天数据进行精细调整以增强对话能力?

-为了增强Transformer在对话中的表现,必须在大量对话数据上进行精细调整,使模型学会在对话过程中生成连贯、合理的回应。这样,当用户与模型进行互动时,模型能够理解上下文并做出合适的回复。

除了问答和对话任务,Transformer模型还有哪些其他应用?

-除了问答和对话任务,Transformer模型还可以应用于命令执行、代码生成、文本生成、情感分析等任务。例如,通过精细调整,模型可以学会根据用户命令生成诗歌、编写代码或生成特定主题的文章。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

Let's build GPT: from scratch, in code, spelled out.

Visual Guide to Transformer Neural Networks - (Episode 1) Position Embeddings

CS480/680 Lecture 19: Attention and Transformer Networks

Lecture 6: Noisy Channel Coding (I): Inference and Information Measures for Noisy Channels

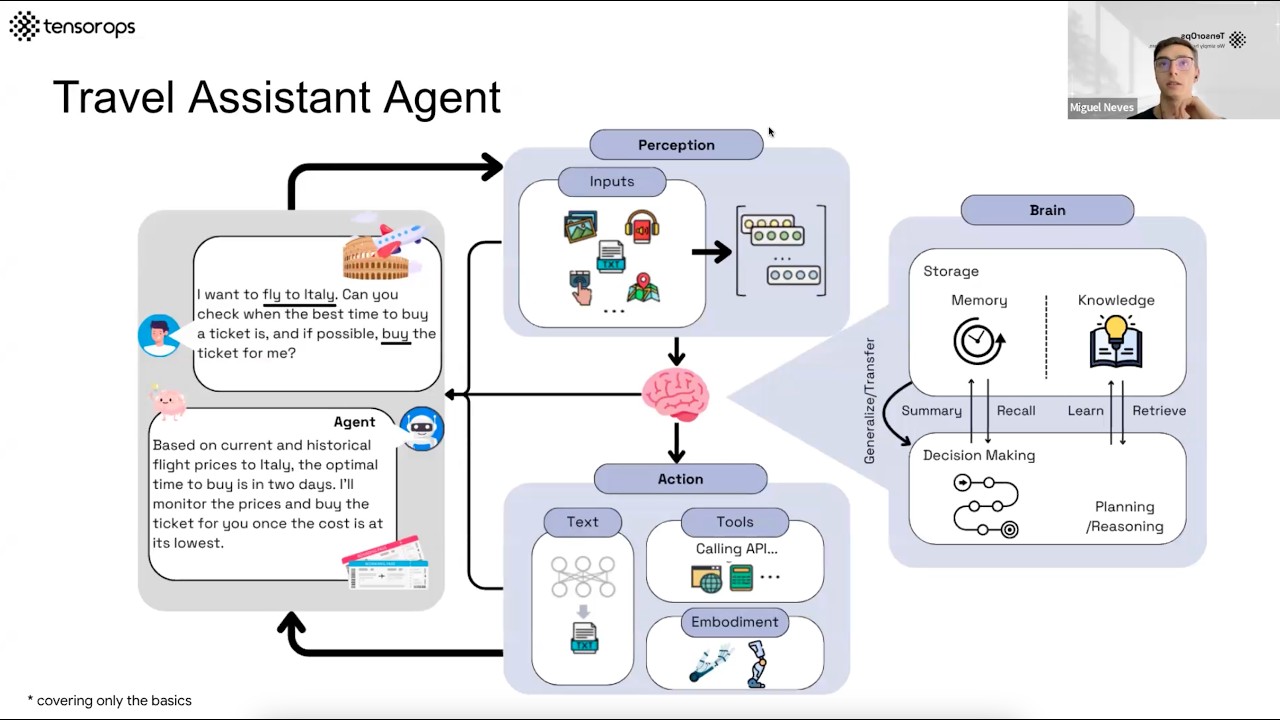

AI Agents– Simple Overview of Brain, Tools, Reasoning and Planning

Hibridación del carbono

5.0 / 5 (0 votes)