大语言模型微调之道1——介绍

Summary

TLDR本视频课程由Sharon Joe主讲,介绍了如何对大型语言模型进行微调,以便在特定任务和数据上使用。微调可以使模型更一致地执行任务,如关键词提取和情感分类,并且可以调整模型的语气和风格。课程内容包括微调的基础知识、与提示工程的区别、如何与微调结合使用,以及如何通过指令微调来训练模型遵循指令。最后,观众将学习如何准备数据、训练模型并评估微调结果。

Takeaways

- 📚 课程介绍:本课程由Sharon Joe主讲,旨在教授如何对大型语言模型(LLM)进行微调。

- 🤖 微调目的:通过微调,可以将开源的大型语言模型进一步训练在自己的数据上,以更好地适应特定任务。

- 📝 微调与提示工程:与仅编写提示(prompt engineering)或检索增强生成(retrieval augmented generation)相比,微调是另一种提升模型性能的方法。

- 🎯 微调应用:微调可以帮助模型更一致地执行任务,如关键词提取、文本情感分类等。

- 🗣️ 风格调整:微调还可以调整模型的语气,使其更符合特定风格,如更有帮助、更礼貌或更简洁。

- 💡 私有数据接口:个人和公司希望将同样的接口应用于自己的私有和专有数据,微调是实现这一目标的方法之一。

- 🚀 基础模型训练:训练一个基础的LLM需要大量的数据和计算资源,但微调可以在现有模型上进行,节省资源。

- 🛠️ 微调步骤:课程将涵盖微调的具体步骤,包括数据准备、模型训练和评估。

- 👨💻 技术要求:本课程适合熟悉Python的人,若要完全理解代码,最好具备深度学习的基础知识。

- 💼 课程贡献者:感谢整个Lamani团队,特别是Nina Wei在设计方面的贡献,以及Deeplearning.ai的Tommy Nelson和Jeff Lardwick。

- 📈 学习成果:通过本课程,你将深入了解如何通过微调现有LM来构建自己的OM,并在你自己的数据上进行实践。

Q & A

这个课程的主题是什么?

-这个课程的主题是关于如何对大型语言模型进行微调,以适应个人或特定任务的数据。

微调大型语言模型的目的是什么?

-微调大型语言模型的目的是让模型在特定数据集上进行进一步训练,以便更一致地执行特定任务,如提取关键词、文本分类,以及调整模型的语气和风格。

与提示工程相比,微调有什么不同?

-提示工程侧重于如何通过编写提示来指导语言模型执行任务,而微调则涉及到使用自己的数据对模型进行额外的训练,以改善其性能。

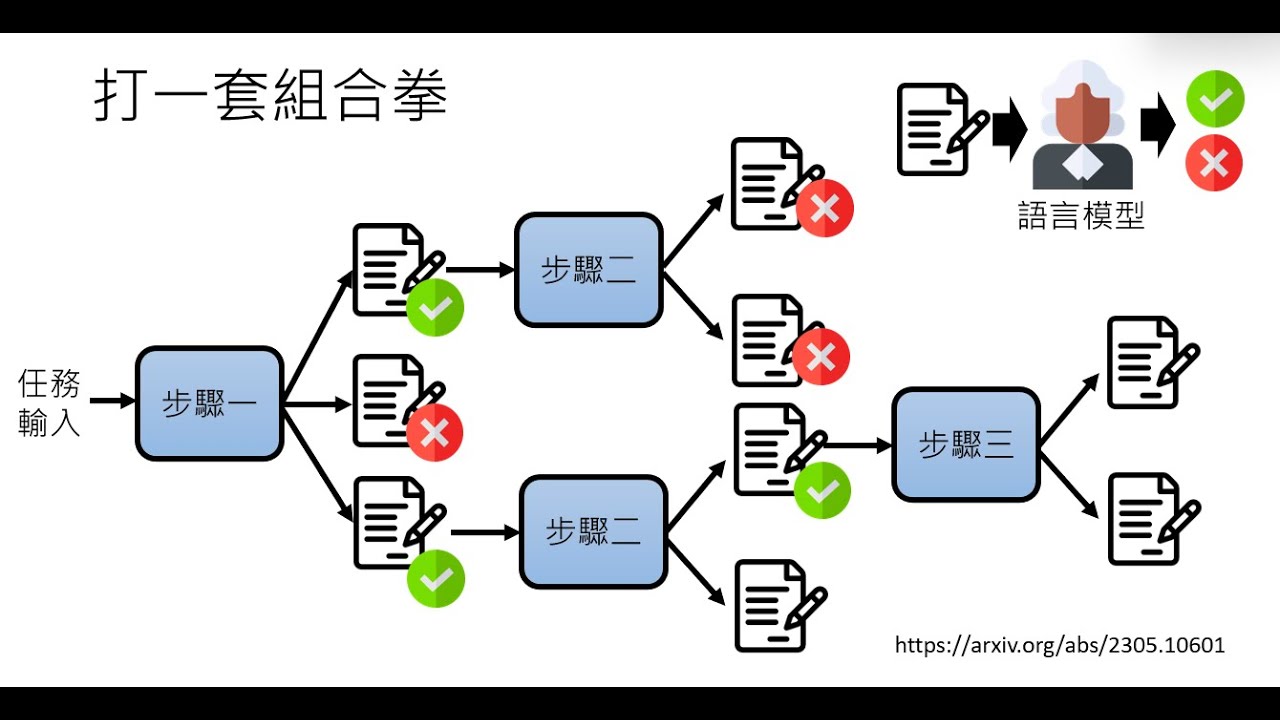

什么是指令微调?

-指令微调是一种特定的微调方式,它教导大型语言模型遵循指令,使得模型能够更好地理解和执行用户的特定要求。

微调大型语言模型需要哪些资源?

-微调大型语言模型需要一定的数据集以及相应的计算资源,如GPU,来进行模型的训练。

为什么个人和公司希望对大型语言模型进行微调?

-个人和公司希望通过微调大型语言模型,使其能够处理和回答关于他们自己私有和专有数据的问题,从而获得与ChatGPT等流行模型相似的交互界面。

在这个课程中,学习者将会学到哪些内容?

-学习者将会学习微调的定义、它在何时对应用程序有帮助、微调如何融入训练过程、它与单纯的提示工程或检索增强生成的区别,以及如何结合使用这些技术。

学习这个课程需要哪些预备知识?

-学习这个课程需要熟悉Python编程语言,并且有助于具备深度学习的基础知识,例如神经网络训练的过程。

这个课程的最终目标是什么?

-这个课程的最终目标是让学习者通过微调现有的大型语言模型,在自己的数据上构建自己的模型,并在代码中实践整个微调过程。

微调大型语言模型有哪些潜在的挑战?

-微调大型语言模型的挑战包括如何确保模型在特定数据集上的训练效果,以及如何调整模型的语气和风格以满足特定的要求。

课程中提到的GPT-3和ChatGPT是什么关系?

-GPT-3是一种大型语言模型,而ChatGPT是基于GPT-3模型构建的一个聊天机器人应用,它利用了GPT-3的语言理解和生成能力来回答各种问题。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

5.0 / 5 (0 votes)