【ソニー社内講演】拡散モデルと基盤モデル(2023年研究動向)

Summary

TLDR本次演讲主要介绍了扩散模型(Diffusion Models)和基础模型(Foundation Models)的最新研究进展。扩散模型作为生成模型的一种,常用于文本到图像的生成,如Stable Diffusion和DALL-E 3。基础模型则是一种多任务学习模型,如GPT。演讲者探讨了如何利用基础模型提升扩散模型性能,包括理解人类指令和无需微调即可执行多种任务的能力。同时,还讨论了2023年的趋势,包括将扩散模型集成到AI代理中,以及提高模型效率和多模态数据生成的方法。

Takeaways

- 😀 石井先生介绍了扩散模型(Diffusion Models)和基础模型(Foundation Models)的结合使用,以及它们在2023年的发展趋势。

- 🖼️ 扩散模型是生成模型的一种,特别在文本到图像的生成领域中非常流行,如Stable Diffusion和DALL-E 3。

- 🎵 扩散模型不仅限于图像生成,还可用于声音生成、机器人运动规划等领域。

- 🌟 基础模型是学习了大量数据的模型,可以用于多种任务,例如GPT等。

- 🔍 扩散模型通过逆向扩散过程生成数据,从纯噪声开始,逐步去除噪声,最终生成清晰的图像。

- 📝 通过结合基础模型,可以提升扩散模型的性能,例如通过理解人类指令来提升图像生成的质量和准确性。

- 🎨 DALL-E 3是一个专门生成详细描述文本的图像的系统,它使用大型语言模型来提升文本到图像的转换质量。

- 🤖 介绍了Visual Chat GPT系统,这是一个结合了扩散模型和基础模型的AI代理,能够通过自然语言指令进行图像编辑和生成。

- 🔧 扩散模型作为基础模型使用时,可以通过不同的策略进行微调,如ControlNet、LoRA和AnimateDiffusion等。

- 🎭 多模态数据生成是扩散模型的另一个应用领域,可以同时生成图像、声音和文本等多种类型的数据。

- 🎉 最后,介绍了Composer方法,这是一种多模态扩散模型的合作机制,允许不同模态的数据生成模型协同工作,生成一致性的数据。

Q & A

什么是扩散模型(Diffusion Models)?

-扩散模型是一种生成模型,它基于扩散过程来生成数据。在图像生成方面,扩散过程是指逐渐向图像添加噪声,直至图像完全变成噪声,然后模型逆向这个过程,从纯噪声开始逐步去除噪声,最终生成清晰的图像。

扩散模型在哪些领域有应用?

-扩散模型不仅在图像生成领域有应用,如文本到图像的生成,还在声音生成、机器人学中的动作规划等多个领域有所应用。

什么是基盘模型(Foundation Models)?

-基盘模型是指那些不仅用于生成模型,而且能够通过多样的数据进行学习,并在多种任务中使用的模型,如GPT等大型语言模型。

扩散模型和基盘模型的结合有哪些优势?

-结合基盘模型可以提升扩散模型的性能,例如通过基盘模型理解人类的指令来提升图像生成的质量和准确性。

扩散模型是如何实现从文本生成图像的?

-扩散模型通过结合文本编码器来实现从文本生成图像。文本编码器提取文本的含义信息,并将其传递给扩散模型,指导噪声的去除过程,从而生成与文本描述相符的图像。

什么是DALL-E 3系统,它有什么特点?

-DALL-E 3是一个专门用于根据详细文本描述生成图像的系统。它使用大型语言模型来将用户输入的文本转换成更详细的描述,并结合文本编码器和扩散模型来生成图像。

AI引擎如何结合扩散模型来提供生成工具?

-AI引擎如Visual Chat GPT可以结合扩散模型和其他视觉基盘模型,通过自然语言指令来实现图像的生成、编辑和相关问题的解答。

扩散模型在AI引擎中的应用有哪些限制?

-扩散模型在AI引擎中的应用受限于能够调用的视觉基盘模型的数量,以及这些模型是否针对跨模态生成进行了优化。

什么是ControlNet,它在扩散模型中的应用是什么?

-ControlNet是一种用于图像生成的扩散模型,它通过添加一个小模块来进行特定条件的微调,而不是对整个模型进行微调,从而实现对新任务的快速适应。

多模态数据生成在扩散模型中是如何处理的?

-多模态数据生成可以通过两种方式实现:一种是学习一个统一的大型多模态扩散模型,另一种是通过定义各个模态的扩散模型并让它们协作生成数据,后者被称为Composer方法。

Composer方法在多模态数据生成中的优势是什么?

-Composer方法允许灵活地组合不同的输入和输出模态,例如,可以生成图像和声音,或者从声音生成文本,通过各模态扩散模型的协作来实现多模态数据的生成。

Outlines

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифMindmap

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифKeywords

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифHighlights

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифTranscripts

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифПосмотреть больше похожих видео

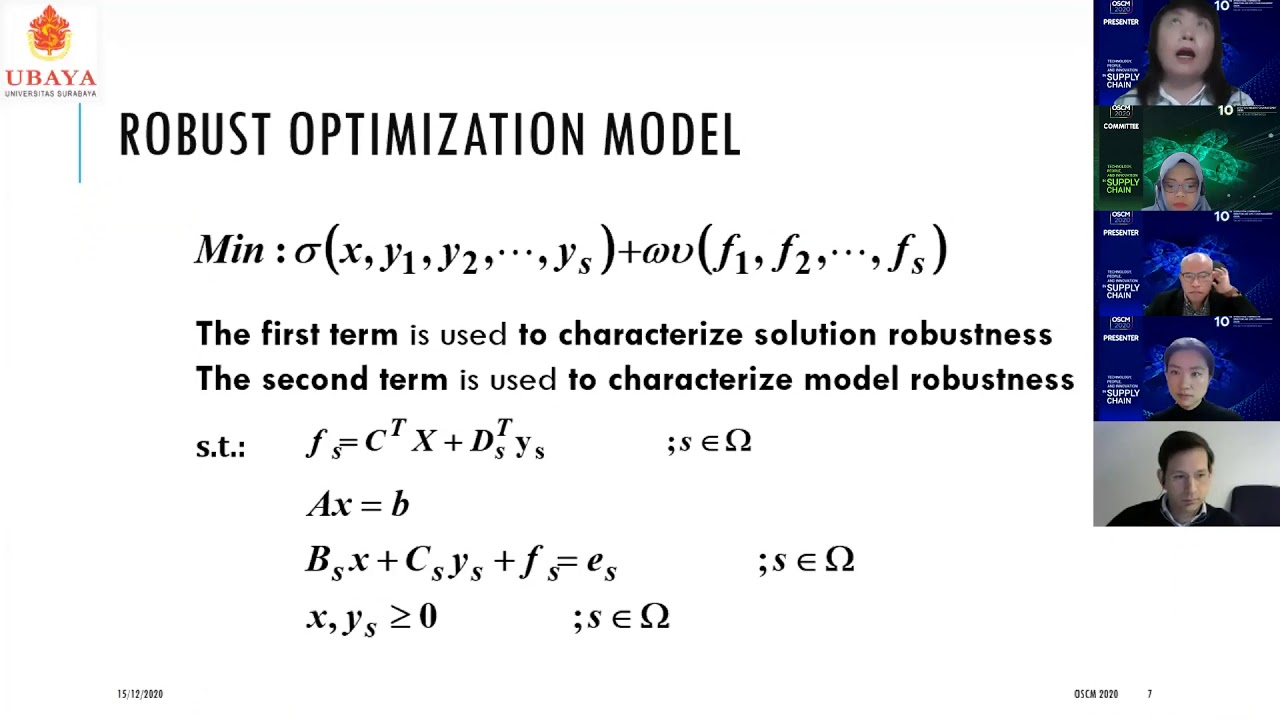

Supply Chain Modelling: Multi Objective Robust Optimization Model for Facility Layout Design

Field-scale Actual ET Estimation using SSEBop | Gabriel Senay, Ph.D., P.E.

Stanford CS25: V3 I Retrieval Augmented Language Models

[ML News] Jamba, CMD-R+, and other new models (yes, I know this is like a week behind 🙃)

New OPEN SOURCE Software ENGINEER Agent Outperforms ALL! (Open Source DEVIN!)

The New Stack and Ops for AI

Meta 碾压 OpenAI? MovieGen 模型简单粗暴才是王道?

5.0 / 5 (0 votes)