¿Qué es una Red Neuronal? Parte 2 : La Red | DotCSV

Summary

TLDREste video explica de manera clara y detallada los fundamentos de las redes neuronales artificiales. Se profundiza en cómo las neuronas, organizadas en capas, pueden procesar información de manera jerárquica para abordar problemas complejos. A través de ejemplos, se demuestra cómo las funciones de activación, como la sigmoide y ReLU, permiten que las redes neuronales modelen patrones no lineales, superando las limitaciones de las regresiones lineales. Finalmente, se ilustra cómo estas redes pueden aprender por sí solas, desarrollando soluciones complejas a través de la interacción de múltiples neuronas.

Takeaways

- 😀 En el video anterior, se explicó cómo una neurona artificial procesa información y cómo se puede modelar con una regresión lineal.

- 😀 Al usar más de una neurona en una red neuronal, es posible modelar información más compleja, como las puertas lógicas 'AND' y 'OR'.

- 😀 Las neuronas pueden organizarse en capas, lo que permite a la red neuronal aprender de forma jerárquica y con más profundidad.

- 😀 Cuantas más capas se agreguen a una red neuronal, más complejos y abstractos pueden ser los conocimientos que se aprenden.

- 😀 El aprendizaje profundo (deep learning) se refiere a redes neuronales con múltiples capas que permiten un aprendizaje más complejo.

- 😀 Para evitar que las redes neuronales se colapsen al agregar más neuronas, es necesario incorporar funciones de activación no lineales.

- 😀 Las funciones de activación son fundamentales para distorsionar los valores de salida y permitir el encadenamiento efectivo de neuronas.

- 😀 Se mostraron diferentes tipos de funciones de activación: escalonada, sigmoide, tangente hiperbólica y ReLU, cada una con beneficios distintos.

- 😀 Las funciones de activación sigmoide y tangente hiperbólica son útiles para representar probabilidades, mientras que ReLU se utiliza para evitar valores negativos.

- 😀 El ejemplo de clasificación de células cancerígenas se usó para demostrar cómo las redes neuronales pueden separar nubes de puntos y resolver problemas complejos.

- 😀 Al combinar varias neuronas en capas y usar funciones de activación apropiadas, es posible crear fronteras de clasificación no lineales que resuelvan problemas complejos, como el de salvar a los personajes de una batalla en el ejemplo presentado.

Q & A

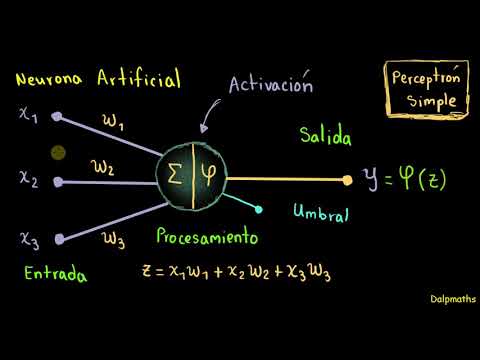

¿Qué es una neurona artificial en el contexto de una red neuronal?

-Una neurona artificial es un componente básico dentro de una red neuronal que procesa información mediante una suma ponderada de sus valores de entrada. Su funcionamiento se asemeja al de un modelo de regresión lineal.

¿Qué problema se identificó al intentar clasificar una nube de puntos con una sola neurona?

-Una sola neurona no puede separar de manera lineal una nube de puntos que no sea linealmente separable, como es el caso de una puerta XOR, lo que demuestra la necesidad de redes más complejas.

¿Cómo se soluciona el problema de separación lineal utilizando más neuronas?

-Añadiendo más neuronas y organizándolas en capas, se puede obtener una separación no lineal de los datos, lo que permite modelar problemas más complejos y clasificar correctamente las clases.

¿Cuál es la diferencia entre las capas de entrada, ocultas y de salida en una red neuronal?

-La capa de entrada recibe los datos iniciales, las capas ocultas realizan cálculos intermedios para aprender patrones complejos y la capa de salida produce el resultado final del proceso.

¿Qué significa 'aprendizaje profundo' en el contexto de redes neuronales?

-El 'aprendizaje profundo' se refiere a las redes neuronales con múltiples capas ocultas, lo que permite aprender representaciones jerárquicas y complejas de los datos, aumentando la capacidad de la red para realizar tareas sofisticadas.

¿Por qué es importante introducir funciones de activación en las neuronas?

-Las funciones de activación son cruciales para introducir no linealidad en el modelo, permitiendo que la red neuronal aprenda representaciones complejas y no solo combinaciones lineales de entradas.

¿Qué efecto tiene la función de activación escalonada sobre los resultados de una neurona?

-La función escalonada convierte la salida de la neurona en un valor binario (0 o 1) dependiendo de si el valor de entrada supera o no un umbral, lo que produce una transición abrupta en el valor de salida.

¿Cuál es la ventaja de usar la función sigmoide como función de activación?

-La función sigmoide es útil porque mapea las salidas a un rango entre 0 y 1, lo que es útil para problemas de clasificación y para representar probabilidades, además de proporcionar una distorsión no lineal.

¿Cómo contribuye la unidad rectificada lineal (ReLU) al aprendizaje de una red neuronal?

-ReLU introduce una no linealidad manteniendo las entradas positivas sin cambios y estableciendo las entradas negativas a cero, lo que ayuda a acelerar el entrenamiento de la red al evitar la saturación de la activación.

¿Por qué es necesario encadenar varias neuronas para resolver problemas más complejos?

-Encadenando varias neuronas con funciones de activación no lineales, la red puede aprender combinaciones de características más abstractas y complejas, lo que le permite resolver problemas que no son lineales.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

¿Que es un grafo?, Elementos, Características y componentes

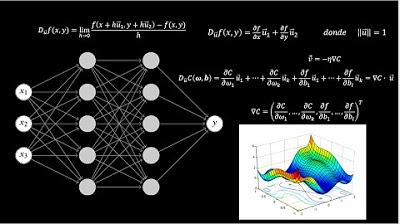

Las Matemáticas detrás de la IA

¿Qué hacen las capas de una Red Neuronal? - Inteligencia Artificial -

Redes neuronales: Introducción al perceptrón simple.

¿Qué es una Red Neuronal? Parte 3.5 : Las Matemáticas de Backpropagation | DotCSV

Neural Networks and Deep Learning: Crash Course AI #3

5.0 / 5 (0 votes)