【人工智能】万字通俗讲解大语言模型内部运行原理 | LLM | 词向量 | Transformer | 注意力机制 | 前馈网络 | 反向传播 | 心智理论

Summary

TLDR本文介绍了大语言模型的工作原理,通过词向量和Transformer结构,模型能够理解和预测语言。文章解释了模型如何通过数十亿词汇的训练,学习单词间的关系,并使用注意力机制和前馈网络来处理歧义和多义词。同时,模型的训练过程依赖大量数据和计算资源,通过预测下一个词的方法,不断调整权重参数以提高准确性。尽管模型表现出高级推理能力,但其内部机制仍不完全被理解。

Takeaways

- 📚 大语言模型的火爆起源于其在预测下一个词的能力,但大众对其内部工作原理了解不多。

- 👨💻 蒂姆·李和肖恩·特洛特的文章旨在用最少的数学知识解释大语言模型,适合初学者理解。

- 🧠 大语言模型基于神经网络,使用数十亿个语言词汇进行训练,而非传统软件的明确指令。

- 📈 词向量(Word Vector)是大语言模型的基础,用数字列表表示单词,捕捉词与词之间的关系。

- 🌐 词向量通过高维度空间表示单词,相似含义的词在向量空间中位置更接近。

- 🔄 Google的word2vec项目通过向量运算展示了词之间复杂的关系,如类比和上下文理解。

- 🧬 大语言模型能够根据上下文用不同的向量表示同一个词,处理同音异义词和多义词。

- 🔄 Transformer结构是构建大语言模型的基石,通过注意力机制和前馈网络处理和预测词序列。

- 🛠️ 训练大语言模型通过预测文本中的下一个词进行,不需要显式标记数据,使用大量文本材料。

- 📈 模型性能随规模增长而提升,GPT-3和GPT-4在心智理论和复杂推理任务上表现接近人类。

- 🤖 尽管大语言模型在多个任务上表现出色,但其内部工作原理的完全理解仍是一个长期且复杂的研究过程。

Q & A

大语言模型的工作原理是什么?

-大语言模型通过预测文本中的下一个词来学习,它们使用词向量表示单词,并通过神经网络层(如Transformer)处理这些向量,以理解和推理语言。这些模型通常包含数十亿个参数,能够处理和生成自然语言文本。

词向量是如何帮助大语言模型理解和处理语言的?

-词向量是将单词表示为一长串数字列表的方法,这些数字列表在高维空间中表示单词之间的关系。具有相似含义的词在向量空间中的位置会更接近,这使得大语言模型能够通过数学运算捕捉到词与词之间的微妙关系,从而理解和处理语言。

Transformer结构在大语言模型中扮演什么角色?

-Transformer是构建大语言模型如ChatGPT的基石。它通过注意力机制和前馈网络处理输入文本中的每个单词的向量,添加上下文信息,并尝试预测下一个词。Transformer使得模型能够利用现代GPU的并行处理能力,并处理长文本。

大语言模型是如何训练的?

-大语言模型通过大量的文本数据进行训练,不需要显式标记数据。它们通过尝试预测文本中的下一个单词来调整模型的权重参数。训练过程涉及前向传播和反向传播,通过反复迭代来提高模型的预测准确性。

为什么大语言模型需要大量的数据来进行训练?

-大量数据使得大语言模型能够学习到丰富的语言规律和词汇用法。这些模型通过数十亿甚至数千亿个单词的学习,逐渐调整权重参数,以更好地预测下一个词。数据量越大,模型学习到的语言知识越丰富,性能也越好。

大语言模型在处理歧义时有哪些挑战?

-自然语言中的歧义,如同音异义词和多义词,给大语言模型带来了挑战。模型需要理解单词在特定上下文中的准确含义,这不仅涉及词与词之间的关系,还需要对现实世界的情况进行理解。大语言模型通过多层神经网络和注意力机制来解决这些挑战。

大语言模型如何表示同一个词的不同含义?

-大语言模型能够根据上下文用不同的向量表示同一个词。例如,对于词'bank',模型会有分别表示金融机构和河岸的向量。这种表示方法使得模型能够捕捉到单词的多重含义。

大语言模型的规模如何影响其性能?

-大语言模型的规模,即模型中的参数数量,直接影响其性能。模型规模越大,能够处理的语言任务越复杂,表现也越好。随着模型规模的增加,它们在需要高级推理的任务上的表现尤其出色。

大语言模型是否真正理解语言?

-这是一个有争议的问题。一些专家认为,大语言模型通过预测下一个词的方式,可能已经开始真正理解语言的含义。而另一些人则认为,这些模型只是重复复杂的单词序列,并没有真正理解它们。目前,这个问题还没有定论。

大语言模型在心智理论任务上的表现如何?

-最新的大语言模型,如GPT-3和GPT-4,在心智理论任务上的表现接近于人类。它们能够正确回答涉及推理他人思维状态的问题,这表明模型可能已经自发地发展出高级推理能力。然而,这一领域的研究仍在进行中,专家们对这些结果的解释存在分歧。

大语言模型在未来发展中可能面临哪些挑战?

-大语言模型在未来发展中可能面临的挑战包括如何更全面地理解模型的内部工作原理,如何减少偏见和歧视,以及如何提高模型的解释性和透明度。此外,还需要解决模型的能源消耗和训练成本问题。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

【生成式AI導論 2024】第10講:今日的語言模型是如何做文字接龍的 — 淺談Transformer (已經熟悉 Transformer 的同學可略過本講)

How Did Dario & Ilya Know LLMs Could Lead to AGI?

[ML News] Jamba, CMD-R+, and other new models (yes, I know this is like a week behind 🙃)

Understand DSPy: Programming AI Pipelines

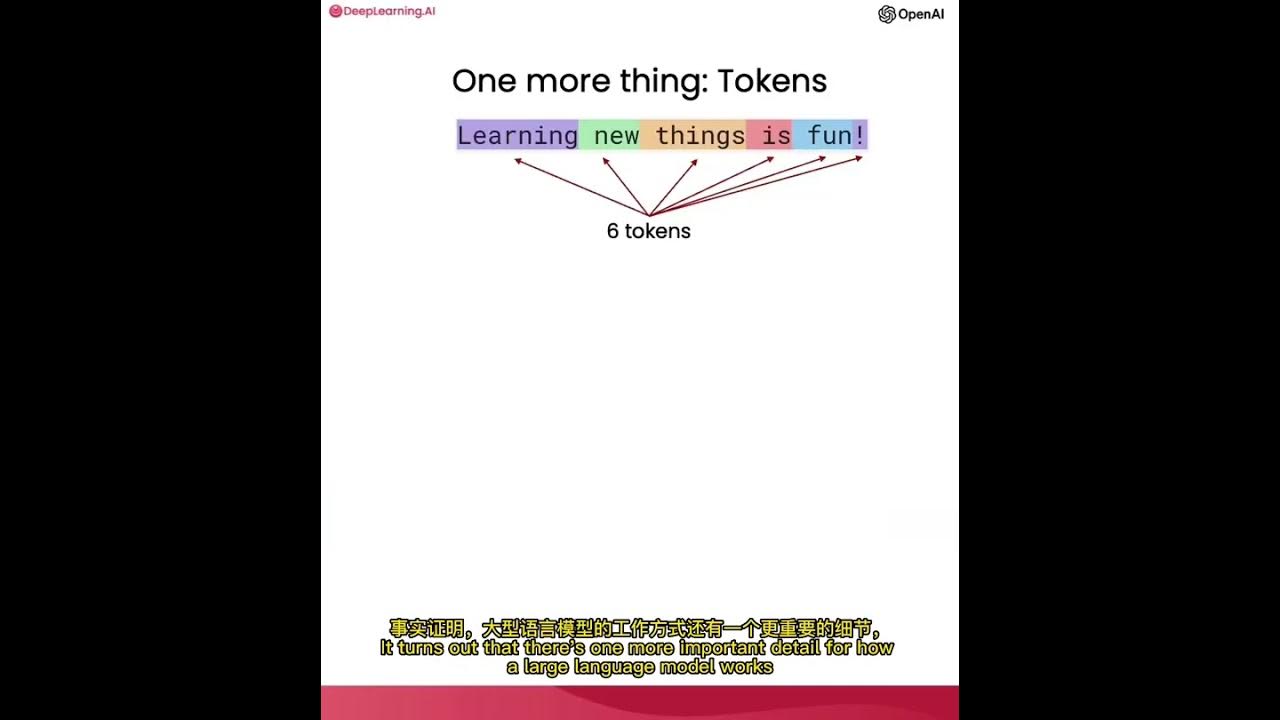

使用ChatGPT API构建系统1——大语言模型、API格式和Token

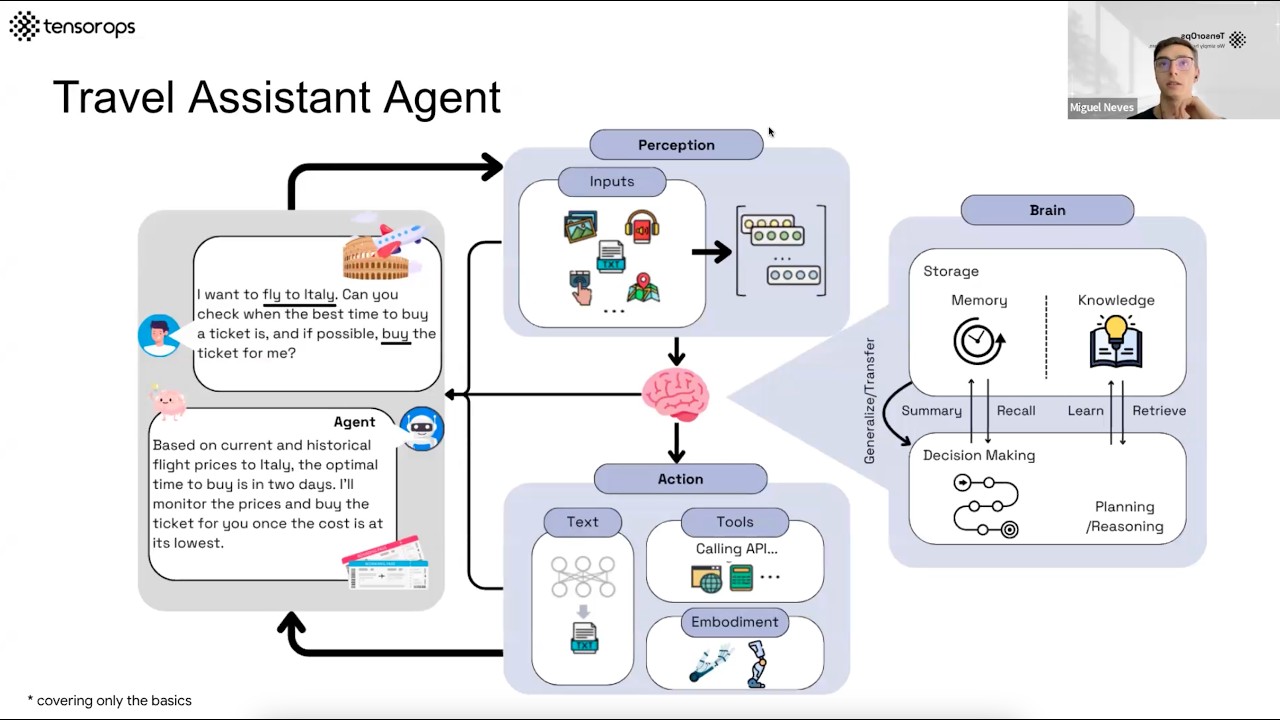

AI Agents– Simple Overview of Brain, Tools, Reasoning and Planning

5.0 / 5 (0 votes)