ROC and AUC, Clearly Explained!

Summary

TLDRDans cette vidéo, Josh Starmer explique le concept de la courbe ROC et de l'AUC en utilisant des données sur des souris obèses et non obèses. Il illustre comment la régression logistique peut classer ces souris selon leur poids et comment le choix du seuil de classification influence les résultats. En utilisant des matrices de confusion, il démontre l'importance de la sensibilité et de la spécificité, puis introduit la courbe ROC pour visualiser la performance de différents seuils. Enfin, il souligne l'AUC comme un moyen de comparer l'efficacité des modèles, offrant ainsi un aperçu accessible de l'analyse statistique.

Takeaways

- 😀 Le ROC (Receiver Operating Characteristic) et l'AUC (Area Under the Curve) sont des outils essentiels pour évaluer la performance des modèles de classification.

- 😀 La matrice de confusion aide à résumer les classifications en vrai positif, faux positif, vrai négatif et faux négatif.

- 😀 La régression logistique permet de prédire la probabilité qu'un échantillon appartienne à une catégorie, par exemple, obèse ou non obèse.

- 😀 Un seuil de classification peut être ajusté (par exemple, 0.5) pour optimiser la classification, influençant ainsi les taux de faux positifs et de faux négatifs.

- 😀 En abaissant le seuil, on peut minimiser les faux négatifs, mais cela augmente les faux positifs.

- 😀 Le graphique ROC trace le taux de vrais positifs contre le taux de faux positifs, permettant de visualiser la performance du modèle à différents seuils.

- 😀 L'AUC quantifie la performance globale d'un modèle : plus l'AUC est proche de 1, meilleure est la performance.

- 😀 Des seuils différents peuvent produire des matrices de confusion similaires, rendant le ROC utile pour éviter des comparaisons compliquées.

- 😀 La précision peut également être utilisée à la place du taux de faux positifs, surtout dans les cas de déséquilibre entre les classes.

- 😀 En résumé, les courbes ROC aident à identifier le meilleur seuil de décision, facilitant la comparaison des méthodes de catégorisation.

Q & A

Qu'est-ce que la courbe ROC et à quoi sert-elle ?

-La courbe ROC (Receiver Operating Characteristic) est un graphique qui permet d'évaluer la performance d'un modèle de classification en visualisant le taux de vrais positifs par rapport au taux de faux positifs pour différents seuils de classification.

Comment la courbe ROC aide-t-elle à choisir un seuil de classification ?

-La courbe ROC montre comment le taux de vrais positifs et le taux de faux positifs changent en fonction du seuil. En traçant ces points, on peut identifier le seuil qui offre le meilleur équilibre entre sensibilité et spécificité.

Qu'est-ce que l'AUC et pourquoi est-elle importante ?

-L'AUC (Area Under the Curve) mesure la surface sous la courbe ROC. Une AUC plus élevée indique une meilleure performance du modèle, facilitant la comparaison entre différents modèles.

Qu'est-ce qu'un matrice de confusion et comment est-elle utilisée dans ce contexte ?

-Une matrice de confusion résume les classifications correctes et incorrectes d'un modèle, en montrant les vrais positifs, faux positifs, vrais négatifs et faux négatifs, ce qui permet d'évaluer la performance globale.

Pourquoi choisir un seuil de 0,5 pour la classification des échantillons ?

-Le seuil de 0,5 est souvent utilisé comme point de départ, car il équilibre les classifications entre les deux classes. Cependant, selon le contexte, il peut être nécessaire d'ajuster ce seuil.

Comment un seuil plus bas affecte-t-il la classification des échantillons ?

-Un seuil plus bas augmente le taux de vrais positifs, mais peut aussi accroître le nombre de faux positifs, ce qui peut être acceptable dans des situations où il est crucial d'identifier tous les cas positifs.

Comment un seuil plus élevé influence-t-il les classifications ?

-Un seuil plus élevé diminue le nombre de faux positifs, mais peut également entraîner des faux négatifs, où des cas positifs ne sont pas identifiés. Cela peut être préférable dans des contextes où les faux positifs sont coûteux.

Qu'est-ce que la précision et comment diffère-t-elle du taux de faux positifs ?

-La précision est le rapport des vrais positifs au total des résultats positifs prédit, tandis que le taux de faux positifs mesure le proportion de négatifs incorrectement classés comme positifs.

Quel exemple est donné pour illustrer l'utilisation de seuils dans des situations critiques ?

-L'exemple d'une classification d'échantillons infectés par Ebola montre qu'il est essentiel de minimiser les faux négatifs, justifiant l'utilisation d'un seuil plus bas, même au risque d'augmenter les faux positifs.

Pourquoi la courbe ROC peut-elle être préférable à une multitude de matrices de confusion ?

-La courbe ROC permet de résumer efficacement les performances de classification pour plusieurs seuils en un seul graphique, ce qui rend l'interprétation plus simple que d'examiner plusieurs matrices de confusion.

Outlines

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantMindmap

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantKeywords

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantHighlights

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantTranscripts

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantVoir Plus de Vidéos Connexes

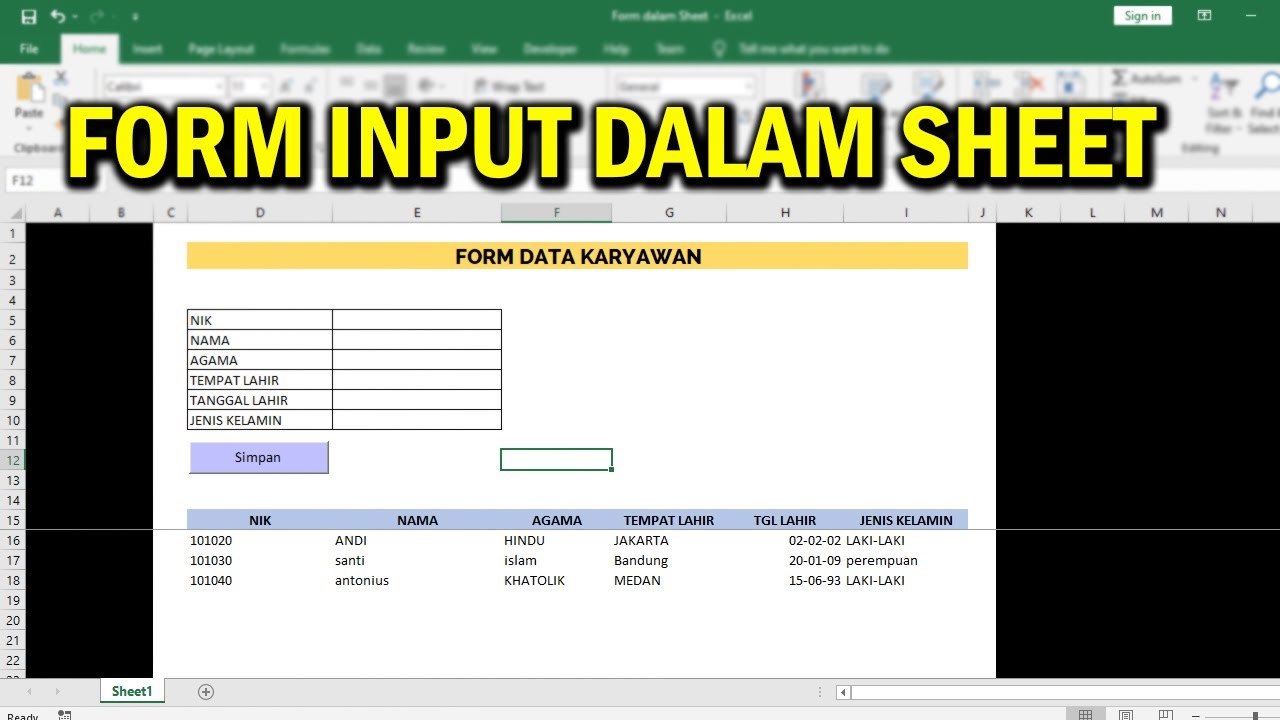

Creating an Input Form in an Excel VBA Sheet Without a Userform

Encoder-Only Transformers (like BERT), Clearly Explained!!!

Flore intestinale, obésité, risques cardio-métaboliques

Comprendre HTTPS et le chiffrement SSL TLS en animation 3D

Finetuning Flux Dev on a 3090! (Local LoRA Training)

Le Secret pour mémoriser à LONG TERME

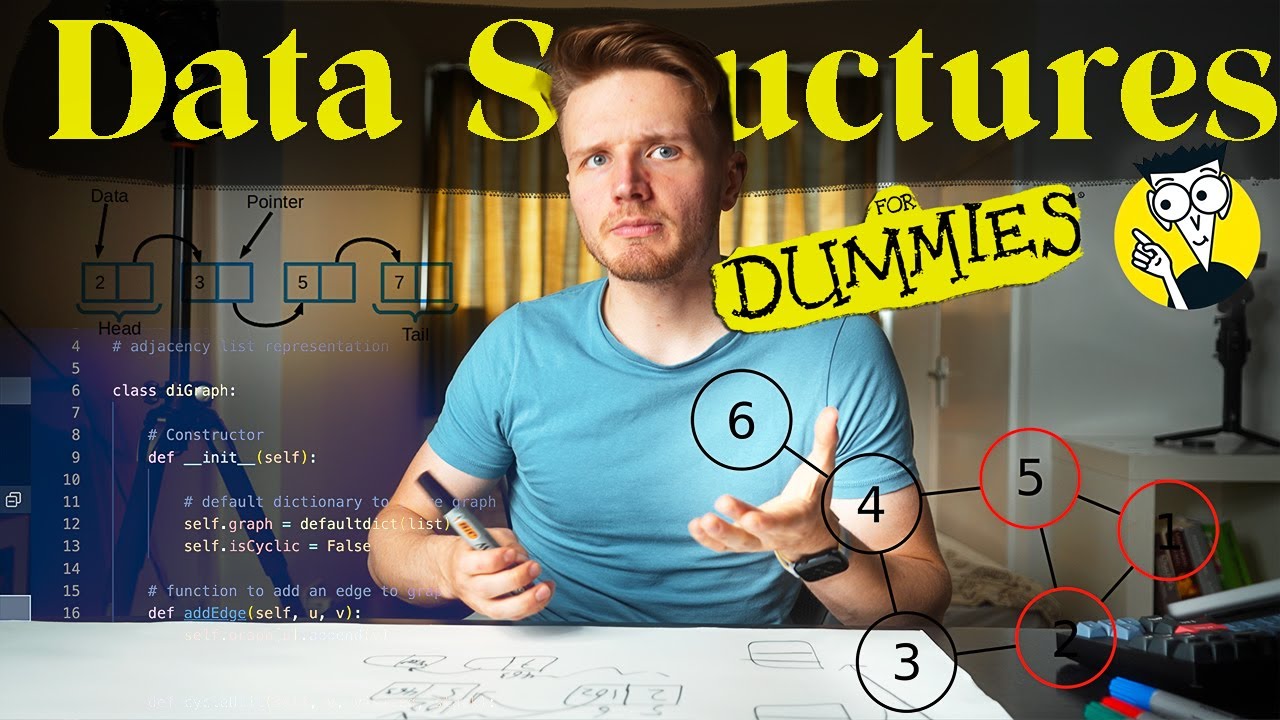

Data Structures Explained for Beginners - How I Wish I was Taught

5.0 / 5 (0 votes)