Explainable AI explained! | #3 LIME

Summary

TLDRIn diesem Video wird LIME (Local Interpretable Model-Agnostic Explanations) vorgestellt, eine Methode zur Erklärung von Black-Box-Algorithmen. LIME ermöglicht es, lokale Erklärungen für Vorhersagen zu generieren, indem es einfache Modelle in der Umgebung eines bestimmten Datenpunkts erstellt. Diese Erklärungen helfen, die Funktionsweise komplexer Modelle besser zu verstehen und die wichtigsten Merkmale zu identifizieren. Das Video behandelt den mathematischen Optimierungsansatz von LIME und zeigt, wie es auf verschiedene Datenarten wie Tabellendaten, Bilder und Text angewendet werden kann, um Vertrauen und Verständnis für KI-Modelle zu schaffen.

Takeaways

- 🧠 **LIME steht für Local Interpretable Model-Agnostic Explanations und ist ein Ansatz zur Erklärung von Schwarz-Kasten-Algorithmen.

- 🌐 **LIME kann für jeden maschinellen Lernmodell verwendet werden, da es model-agnostisch ist.

- 📈 **Die Idee hinter LIME besteht darin, die lokale Umgebung einer individuellen Vorhersage zu betrachten und dort eine einfache Erklärung zu erstellen.

- 🔍 **LIME verwendet eine lineare, interpretierbare Modellfamilie (wie lineare Regression), um eine lokale Approximation des komplexen Modells zu schaffen.

- 🔄 **Die Erklärungen von LIME sind lokal treu, aber sie müssen möglicherweise nicht global sinnvoll sein.

- 🔍 **LIME arbeitet mit fast jeder Art von Eingabe, wie Text, tabellarischen Daten, Bildern oder sogar Graphen.

- 🔧 **LIME kann dazu beitragen, das Vertrauen in Vorhersagealgorithmen zu stärken, indem es Erklärungen bereitstellt, die von Fachexperten überprüft werden können.

- 📊 **Die mathematische Optimierung bei LIME ist intuitiv, da sie eine lokale Approximation des komplexen Modells für eine bestimmte Eingabe sucht.

- 📈 **LIME verwendet eine Verlustfunktion, die zwei Hauptkomponenten hat: eine zur Lokaltreue und eine zur Einfachheit des Ersatzmodells.

- 💻 **In der Praxis wird LIME oft mit regulärenisierungstechnischen Methoden wie Lasso-Linear-Regression verwendet, um eine einfache Erklärung mit nur wenigen relevanten Variablen zu erhalten.

- 🌐 **LIME kann auf verschiedene Arten von Daten angewendet werden, wie im Video gezeigt wird, um Erklärungen für Bilder, Textdaten und andere zu erstellen.

Q & A

Was ist LIME und was bedeutet die Abkürzung?

-LIME steht für 'Local Interpretable Model-agnostic Explanations'. Es ist eine Methode, um Black-Box-Algorithmen zu erklären, indem es lokale, interpretierbare Erklärungen erstellt.

Wozu dient die LIME-Methode?

-LIME dient dazu, lokale Erklärungen für individuelle Vorhersagen von Black-Box-Modellen zu erzeugen, ohne auf die gesamte Komplexität des Modells eingehen zu müssen.

Warum ist es schwierig, Black-Box-Modelle zu erklären?

-Black-Box-Modelle sind komplex und ihre Entscheidungsprozesse sind oft nicht linear, was es schwierig macht, eine einfache und verständliche Beziehung zwischen Eingabe und Vorhersage zu finden.

Wie funktioniert die Grundidee von LIME?

-Die Grundidee von LIME besteht darin, auf eine kleine Umgebung des zu erklärenden Datenpunktes zu zoomen und dort eine einfache Erklärung zu erstellen, die in dieser lokalen Region Sinn ergibt.

Was ist eine 'lokale Approximation' in Bezug auf LIME?

-Eine lokale Approximation ist ein einfaches Modell, das in der Nähe eines bestimmten Eingabedatenpunktes eine gute Annäherung an das komplexe Modell darstellt.

Wie wird die Nähe zu einem Datenpunkt in LIME definiert?

-Die Nähe zu einem Datenpunkt wird in LIME durch eine Proximity-Funktion definiert, die als Abstandsmessung dient und oft mit einem Exponentialkern implementiert wird.

Was ist das Ziel der mathematischen Optimierungsprobleme, die in LIME verwendet werden?

-Das Ziel ist es, ein einfaches Modell zu finden, das sowohl die komplexen Modelle in der Umgebung des Datenpunktes annähert als auch so einfach wie möglich bleibt.

Wie wird die Einfachheit des lokalen Modells in LIME gewährleistet?

-Die Einfachheit wird durch Regularisierung erreicht, oft durch Verwendung von Lasso-Linear-Regression, um eine sparsame lineare Modelle zu erhalten, die viele Null-Gewichte haben.

Welche Art von Daten kann LIME erklären?

-LIME kann fast jeden Eingabetyp erklären, wie Text, tabellarische Daten, Bilder oder sogar Graphen.

Welche Rolle spielen Fachexperten bei der Verwendung von LIME?

-Fachexperten können die Erklärungen von LIME nutzen, um das Modell zu validieren und zu verstehen, ob es sinnvolle Vorhersagen trifft, basierend auf ihrem vorherigen Wissen über das Problem.

Wie wird die Genauigkeit der lokalen Erklärungen in LIME gewährleistet?

-Die Genauigkeit wird durch das Minimieren der Verlustfunktion gewährleistet, die sowohl die Annäherung des komplexen Modells in der lokalen Umgebung als auch die Einfachheit des einfachen Modells berücksichtigt.

Outlines

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraMindmap

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraKeywords

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraHighlights

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraTranscripts

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraVer Más Videos Relacionados

Understanding LIME | Explainable AI

A Weekly Hack That Grows ANY MUSICIAN From 0 To 1,000,000 Fans // INSTAGRAM CLOSE FRIENDS TRICK

Löse den Rubik's Cube in 10 minuten - Der Zauberwürfel für Anfänger

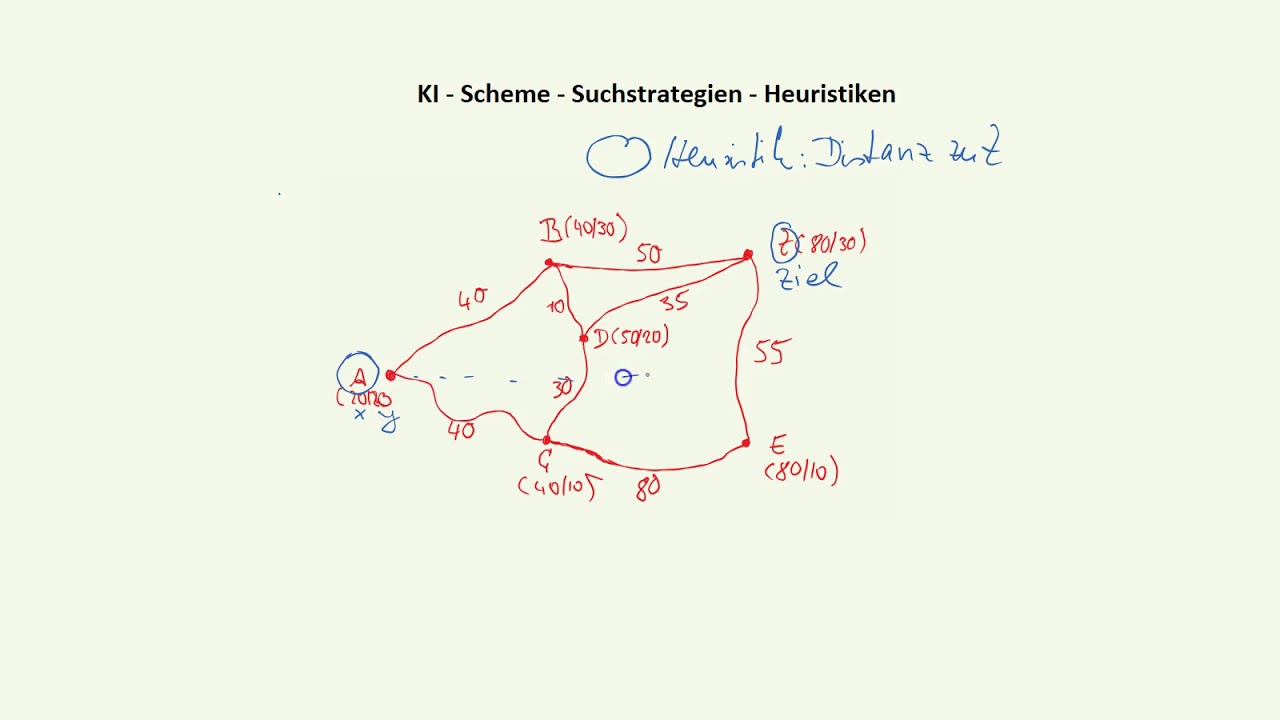

Ki und Scheme - Suchstrategien - Heuristiken

The Perfect Diet To Build Muscle, Lose Fat and Get Healthy

"schnelle" Prozentrechnung - einfach erklärt *Trick* | Mathematik | Lehrerschmidt

5.0 / 5 (0 votes)