How to add genuinely useful AI to your webapp (not just chatbots) - Steve Sanderson

Summary

TLDR本视频介绍了如何利用语言模型进行有效的端到端测试,强调了确保应用程序在已知状态下运行以及如何应对语言模型的不确定性。演讲者通过使用Aspire等工具,展示了如何在测试中进行数据预先种子设置和缓存策略,以确保测试的稳定性和高效性。除了介绍语义搜索、总结和分类等不同的UI模式外,演讲者还鼓励在开发初期就注重评估,使用定量反馈提升质量。最终,视频呼吁更多开源库的创造,以便于开发人员提升工作效率。

Takeaways

- 😀 在进行端到端测试时,确保应用程序处于已知状态是非常重要的,避免因开发者机器上已删除或修改的数据导致测试失败。

- 😀 使用Aspira等工具可以帮助管理测试中的不同数据场景,确保所有团队成员共享一致的初始数据。

- 😀 语言模型通常不是确定性的,即使使用固定的种子和低温度,模型输出仍然可能会有所不同。

- 😀 为了克服语言模型的非确定性,可以使用缓存机制:首次运行时调用真实的语言模型并将响应缓存,后续运行则直接使用缓存数据。

- 😀 缓存策略可以使测试更加快速和可预测,同时避免每次都进行外部API调用,减少对API密钥的依赖。

- 😀 在CI服务器上运行时,通过缓存机制可以避免调用外部服务,从而不需要API密钥,提高测试效率。

- 😀 如果在测试中更改了提示词或参数,缓存将失效,测试将失败,直到重新生成缓存数据。

- 😀 端到端测试中的这种缓存模式不仅能提高测试效率,还能确保测试的可重复性和一致性。

- 😀 在进行语言模型相关工作时,要有明确的评估机制,及时获得数值化反馈,有助于确保工作的质量和进展。

- 😀 尽管目前有像Aspira和Semantic Kernel等工具,但该领域仍在不断发展,未来可能会出现新的库来简化数据生成、摄取和评估过程。

- 😀 语言模型的应用不仅仅限于聊天机器人,语义搜索、文本摘要、分类等多个UI模式也是可行的,提供了丰富的应用选择。

- 😀 开发者应该从一开始就进行评估,以确保改进措施朝着正确的方向推进,并确保对所做更改有信心。

Q & A

如何确保在进行端到端测试时,应用程序总是处于已知状态?

-为了确保应用程序总是处于已知状态,可以在测试开始前使用特定的测试数据进行数据填充。通过配置或环境变量,确保每个人都使用相同的JSON文件存储的测试数据,这样测试将始终从相同的状态开始,避免因为开发人员本地数据的差异而导致测试失败。

语言模型为什么通常不是确定性的?

-语言模型通常不是确定性的,即使设置了种子值或较低的温度,模型的输出仍然可能不一致。这是因为模型会根据训练数据的复杂性和输入的细微变化产生不同的输出。

如何通过缓存解决语言模型的不确定性问题?

-为了解决语言模型的不确定性,可以在首次运行测试时将模型的响应缓存到磁盘中。接下来的测试将使用缓存的响应,而不是再次调用外部API。这样可以确保测试是确定性的,并且提高了测试的速度。

缓存机制如何提高测试效率?

-通过缓存机制,第二次运行相同的测试时,测试将直接使用缓存的响应,而无需再次与语言模型进行交互。这不仅加快了测试速度,还确保了每次测试都在相同的条件下运行,减少了外部依赖和不确定因素的干扰。

缓存机制如何帮助避免API密钥的使用?

-由于缓存的响应来自本地存储,而不是每次都从外部API获取,因此在测试过程中不需要使用API密钥。这对于持续集成环境特别有用,因为它简化了环境配置,并减少了对外部服务的依赖。

在进行端到端测试时,如何确保生成的数据始终一致?

-为了确保生成的数据一致,可以使用一组预定义的JSON文件,这些文件可以存储在版本控制中,并且在测试期间始终被加载。这样,所有团队成员都可以使用相同的数据集,并且每次运行测试时,数据都将保持一致。

为什么语言模型和生成式AI的测试模式仍在不断发展?

-语言模型和生成式AI的测试模式仍在不断发展,因为这些技术相对较新,且其应用范围广泛,涉及多个领域。随着技术的不断成熟和新模式的出现,测试方法和最佳实践也在逐步演变。

如何通过数值反馈确保语言模型的改进方向是正确的?

-从一开始就对语言模型进行数值评估,可以帮助开发人员更清楚地了解模型性能的变化。通过定期评估,开发人员可以确保每次更新或调整都能朝着提升模型质量的方向发展。

除了对话型应用,语言模型还有哪些其他应用模式?

-除了聊天机器人应用,语言模型还可以用于语义搜索、摘要生成、分类任务等。通过不同的UI模式和任务类型,可以将语言模型应用到各种领域,提高数据处理和信息获取的效率。

在使用语言模型时,如何选择合适的模型和服务?

-选择合适的语言模型和服务时,可以考虑多种因素,包括模型的大小、可定制性、是否支持本地运行、以及是否依赖外部API等。可以使用开源模型(如Hugging Face的模型)或云服务提供的API,具体选择取决于项目需求和资源限制。

Outlines

此内容仅限付费用户访问。 请升级后访问。

立即升级Mindmap

此内容仅限付费用户访问。 请升级后访问。

立即升级Keywords

此内容仅限付费用户访问。 请升级后访问。

立即升级Highlights

此内容仅限付费用户访问。 请升级后访问。

立即升级Transcripts

此内容仅限付费用户访问。 请升级后访问。

立即升级浏览更多相关视频

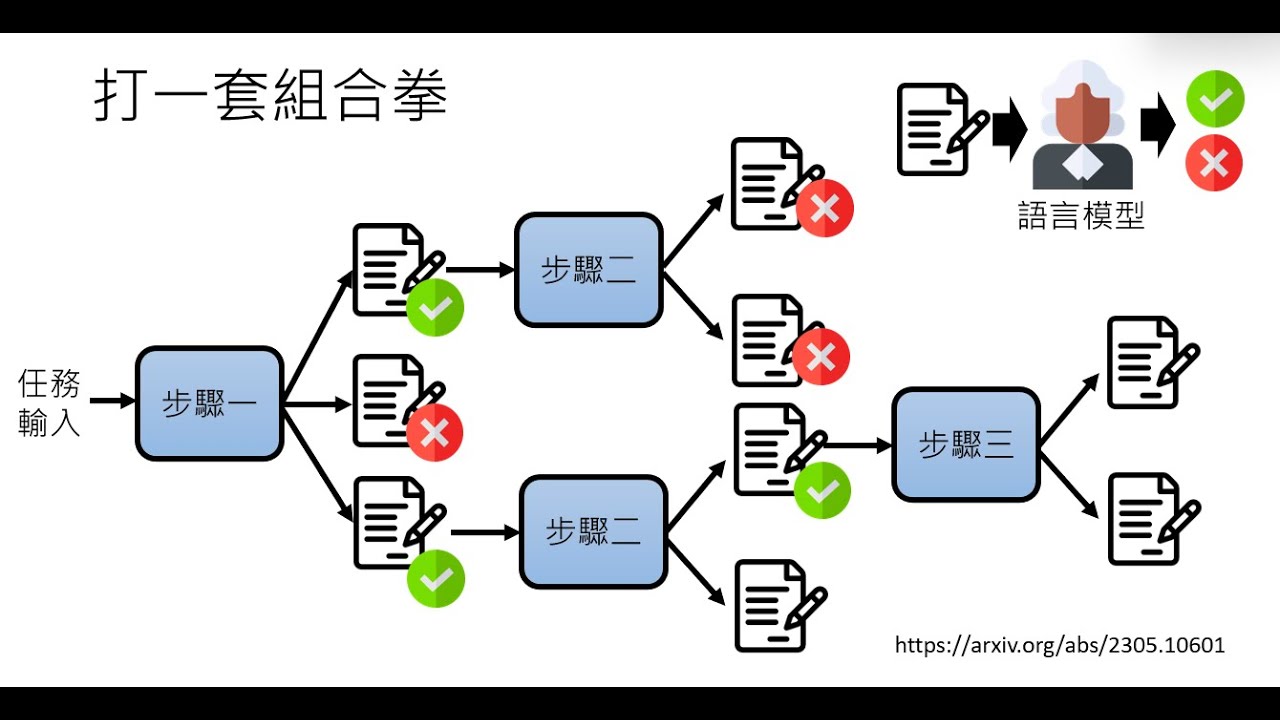

【生成式AI導論 2024】第4講:訓練不了人工智慧?你可以訓練你自己 (中) — 拆解問題與使用工具

Adapt SwiftUI app for iPad, Landscape, and Dark Mode | Todo List #6

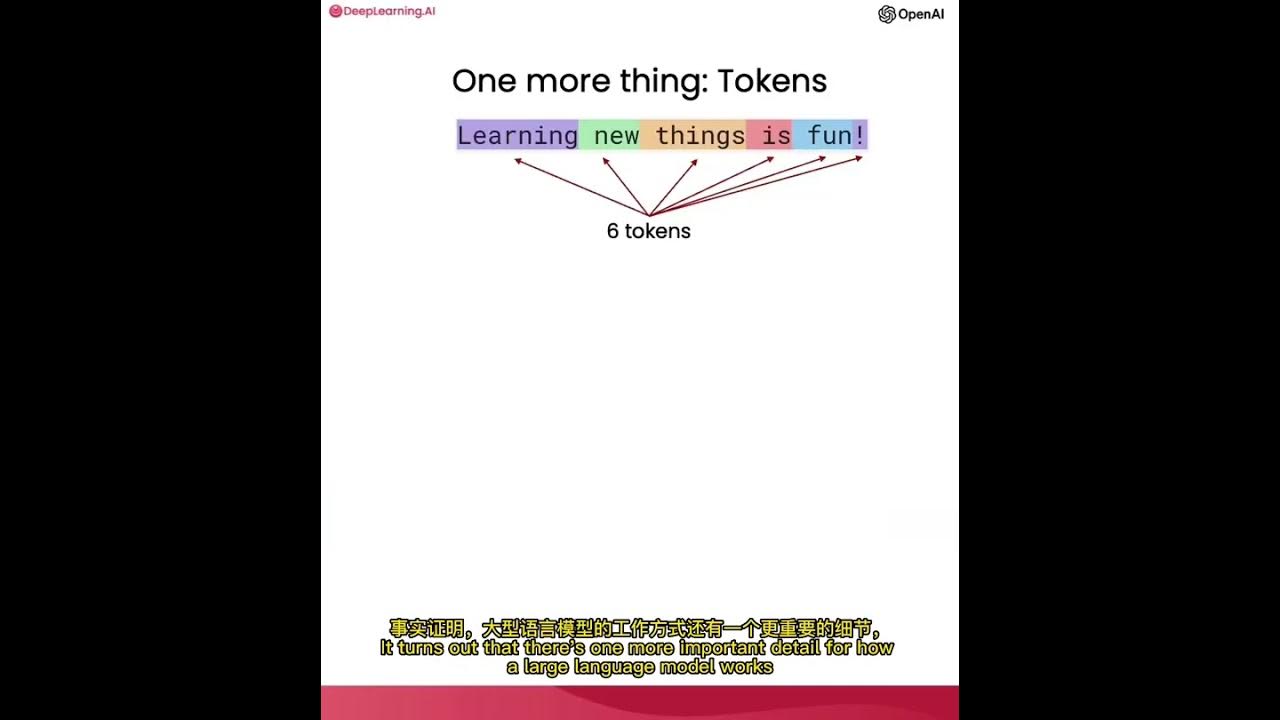

使用ChatGPT API构建系统1——大语言模型、API格式和Token

The New Stack and Ops for AI

Optimization of LLM Systems with DSPy and LangChain/LangSmith

LLAMA-3 🦙: EASIET WAY To FINE-TUNE ON YOUR DATA 🙌

Trying to make LLMs less stubborn in RAG (DSPy optimizer tested with knowledge graphs)

5.0 / 5 (0 votes)