Summary Evaluators | LangSmith Evaluations - Part 11

Summary

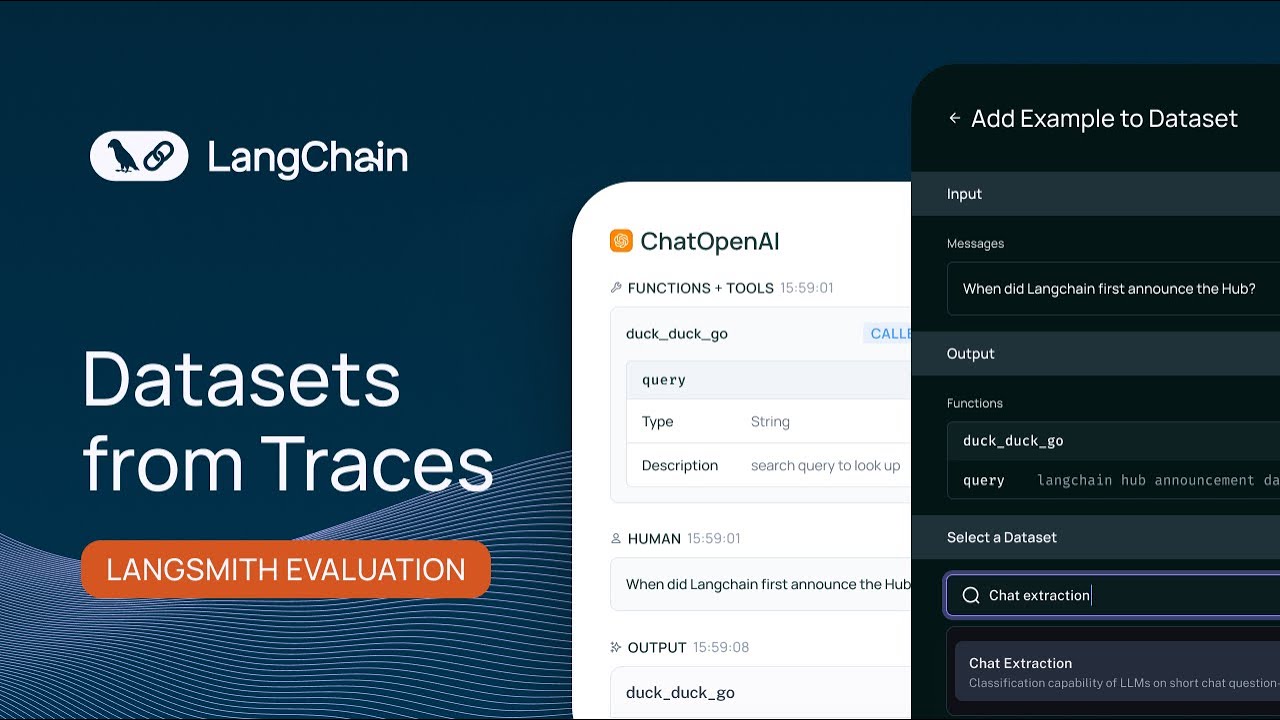

TLDRビデオスクリプトでは、Lanceが文書の評価に焦点を当てたLangs Smith評価シリーズの11번째動画を紹介しています。彼は、既存のirrelevantな文書を特定するため、文書のレトロスペクティブを評価し、二値grades(はい/いいえ)を返すLLMを用いて評価セットを作成しました。彼は、精度だけではなく、精度とリコールを組み合わせた独自のメトリックを使用したいという動機から、F1スコア評価器を適用し、mystic GraderとOpen AI Graderの両方を比較しています。結果、両方の評価器がテストサンプル全体で正確であったことが示され、カスタム評価器の利点を強調しています。

Takeaways

- 📚 これは、LanceがLang Chainからお届けする、文書グレード評価シリーズの11番目のビデオです。

- 🔍 Lanceは、文書の関連性を判断するため、リトリーブとグレードを組み合わせて使っています。

- 📈 評価セット「relevance grade」を使って、グレードプロセスをテストすることができます。

- 🛠️ カスタムメトリックを定義して、データセット全体の集計サマリーメトリックとして使用することができます。

- 🤖 LLM(Large Language Model)を用いて、文書のグレードを自動化し、バイナリスコア(はい/いいえ)を返すことができます。

- 📝 データモデルは、構造化された出力を生成し、そのバイナリスコアをLLMにバインドします。

- 📊 F1スコアは、正確さと再現性のバランスをとるための良いメトリックです。

- 🔧 MRAW(Maybe Right, Always Working)グレーダーを使用して、ローカルで評価を行ってJSON出力を強制することができます。

- ⚖️ ABテストを使って、OpenAIグレーダーとMRAWグレーダーを比較評価します。

- 📉 真陽性、偽陽性、偽陰性を計算し、それに基づいてF1スコアを算出します。

- 📈 評価結果では、F1スコアが各実験に記録され、比較モードで確認することができます。

- 🎓 Lanceは、データセットでカスタム評価器を見つけることの利便性を強調し、さらに探索を勧めています。

Q & A

ランスが紹介した評価シリーズの11番目のビデオの焦点は何ですか?

-ランスが紹介した評価シリーズの11番目のビデオは、文書のグレードを評価するサマリー評価者に焦点を当てています。

文書のグレードを決定するためにランスはどのような方法を使用していますか?

-ランスは、リレーティブアクセス性ガイド(RAG)の文脈で使用されるように、LLMグレーダーを使用して文書の関連性を決定し、バイナリスコア(はいまたはいいえ)を返します。

ランスが使用するデータセットの名前は何ですか?

-ランスが使用するデータセットは「関連性グレード」と呼ばれており、各例には文書、例の質問、および文書が質問に関連しているかどうかのスコアが含まれています。

カスタムメトリックを定義する動機は何ですか?

-ランスは、データセット全体の集約サマリーメトリックとして正確さを使用したくない場合、または精度と再呼出しを組み合わせたカスタムメトリックを見つけたいと考えています。

F1スコアとは何ですか?

-F1スコアは、精度と再呼出しを結合するメトリックで、精度と再呼出しの調和平均を計算します。これは、機械学習や他の分野で一般的に使用され、精度と再呼出しのトレードオフを結合する方法として使用されます。

ランスはどのようにしてカスタムメトリックを定義しましたか?

-ランスは、OpenAIとローカルで動作するMRAWを使用して、データセットのバイナリスコアを返すカスタムメトリックを定義しました。

MRAWとOpenAIのグレーダーを比較するために行われたテストは何ですか?

-ランスは、MRAWとOpenAIのグレーダーを比較するために、関連性グレードデータセットに対してABテストを実行しました。

F1スコアを計算するために必要な3つの要素は何ですか?

-F1スコアを計算するために必要な3つの要素は、真正的例子(True Positives)、偽陽性(False Positives)、および偽陰性(False Negatives)です。

ビデオの最後でランスはどのように結論づけましたか?

-ビデオの最後で、ランスは、データセットでカスタム評価者を使用し、MRAWとOpenAIの両方のテストが全てのテストサンプルを正しく評価したことを確認しました。

ランスが使用したデータセットの形式はどのようなものですか?

-ランスが使用したデータセットは、開発者によってキュレーションされたデータセットであり、各サンプルはバイナリスコア(はいまたはいいえ)で評価されます。

ランスが提案するカスタム評価者の利点は何ですか?

-ランスが提案するカスタム評価者の利点は、精度と再呼出しのトレードオフを組み合わせることができる柔軟性と、特定のデータセットや問題に応じて最適なメトリックを定義できることです。

ランスはどのようにしてデータセットの結果を確認しましたか?

-ランスは、Langs Smithのデータセットセクションにアクセスし、実験を確認することで、データセットの結果を確認しました。また、比較ビューを使用して、OpenAIとMRAWのテスト結果を比較しました。

Outlines

此内容仅限付费用户访问。 请升级后访问。

立即升级Mindmap

此内容仅限付费用户访问。 请升级后访问。

立即升级Keywords

此内容仅限付费用户访问。 请升级后访问。

立即升级Highlights

此内容仅限付费用户访问。 请升级后访问。

立即升级Transcripts

此内容仅限付费用户访问。 请升级后访问。

立即升级5.0 / 5 (0 votes)