Custom Evaluators | LangSmith Evaluations - Part 6

Summary

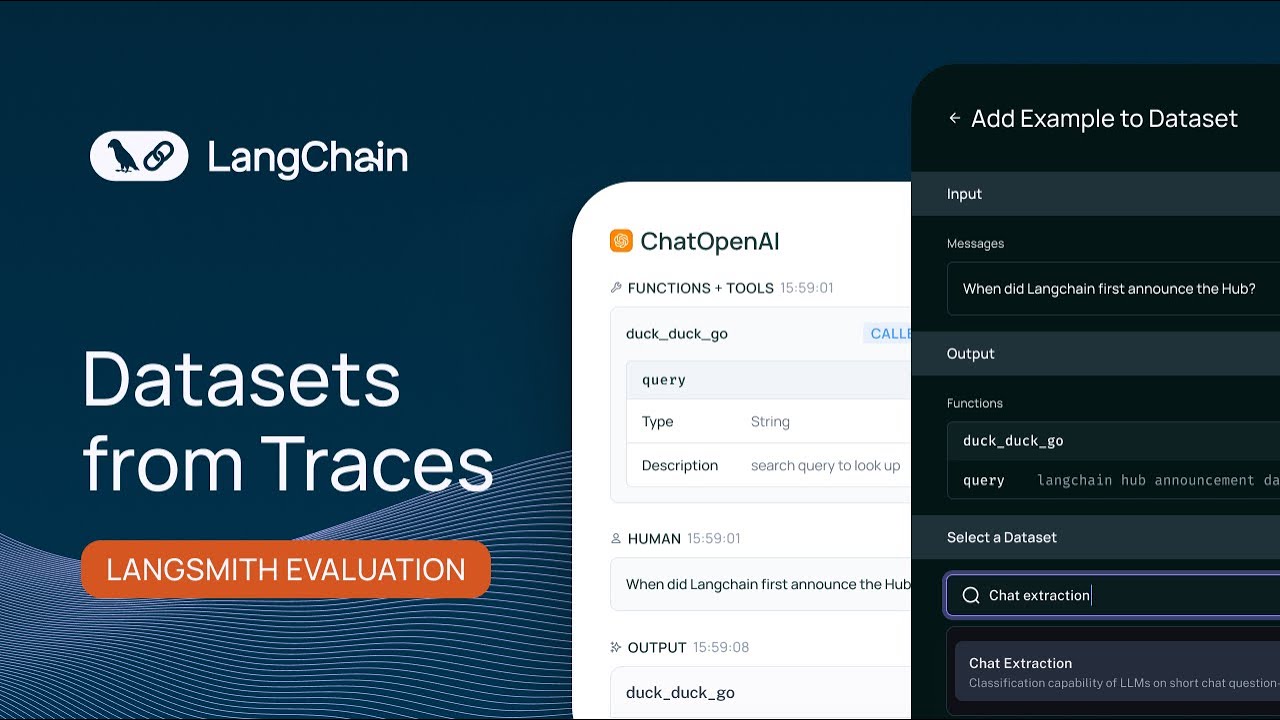

TLDRこの動画スクリプトは、シリーズの第6回目の動画であり、長評価について焦点を当てています。動画では、評価が重要である理由、Langs Smith Primitivesの基礎、データセットの構築方法、開発者によるデータセットのカスタマイズ、ユーザーログからのデータセットの構築、評価器の使用方法について説明しています。特に、カスタム評価器の作成方法について詳細に説明しており、シンプルなアサーションに基づいた機能テストを通じて、システムが正しく動作していることを確認する方法を提案しています。

Takeaways

- 📈 シリーズの第6回目の動画で、長評価について焦点を当てています。

- 🌟 評価の重要性を説明し、Langs Smith Primitivesの基礎を築きました。

- 🛠️ データセットの構築方法を学び、Databricksを使用してカスタマイズしました。

- 📝 質問と回答のデータセットを作成し、編集と追加の方法を紹介しました。

- 🔍 ユーザーログからデータセットを構築し、フィードバックや質問をプラグインする方法を説明しました。

- 🧠 生成されたデータセットを使用して、ビルトインのライフチャイン評価器を用いてアプリを評価しました。

- 🤖 GDP-35を使用して質問に答え、手作業でキュレートされたデータセットと比較しました。

- 💡 カスタマイズされた評価器を作成し、答えが生成されたかどうかを確認する単純なアサーションを設定しました。

- 📊 評価器は、答えが存在するかどうかを判断し、単位テストのような機能を有する非常简单なアサーションです。

- 🔧 カスタム評価器を構築する際には、出力を抽出する能力が必要です。

- 🎯 カスタム評価器は非常に柔軟で、任意のスコアリング方法を選択できます。

- 📖 情報フローを理解し、例と実行の出力を利用することで、カスタム評価器の構築は非常に簡単です。

Q & A

ビデオ_SERIESの主題は何ですか?

-ビデオ_SERIESの主題は、言語評価に関するものです。

最初のビデオは何を説明していますか?

-最初のビデオでは、評価が重要である理由について説明しています。

Langs Smith Primitivesとは何ですか?

-Langs Smith Primitivesは、データセットの構築に使用される基本的な要素です。

データセットの構築方法について説明するビデオは何ですか?

-3番目のビデオがデータセットの構築方法について説明しています。

Databricksとは何ですか?

-Databricksは、データ分析と機械学習のためのプラットフォームです。

Databricksモデルを使用した質問回答データセットの構築方法について説明するブログ記事のリンクはどこにありますか?

-ブログ記事のリンクは、ビデオのスクリプトの途中部分に示されています。

ユーザーログからデータセットを構築する方法について説明するビデオは何ですか?

-4番目のビデオがユーザーログからデータセットを構築する方法について説明しています。

評価器とは何ですか?

-評価器は、アプリケーションの性能を判断するために使用されるツールです。

GPT-35とは何ですか?

-GPT-35は、OpenAIによって開発された自然言語処理のモデルです。

カスタム評価器を作成する場合、どのようなアサーションを使用することができますか?

-カスタム評価器を作成する場合、答えが生成されたかどうかを確認するようなシンプルなアサーションを使用することができます。

カスタム評価器を構築する際の主な利点は何ですか?

-カスタム評価器を構築する主な利点は、非常に柔軟で、任意の評価方法を適用できることです。

このビデオ_SERIESで説明された評価方法の適用範囲はどこまでですか?

-このビデオ_SERIESで説明された評価方法は、オフライン評価やCIなど、様々な場面で適用可能です。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade Now5.0 / 5 (0 votes)