Basic Theory | Neural Style Transfer #2

Summary

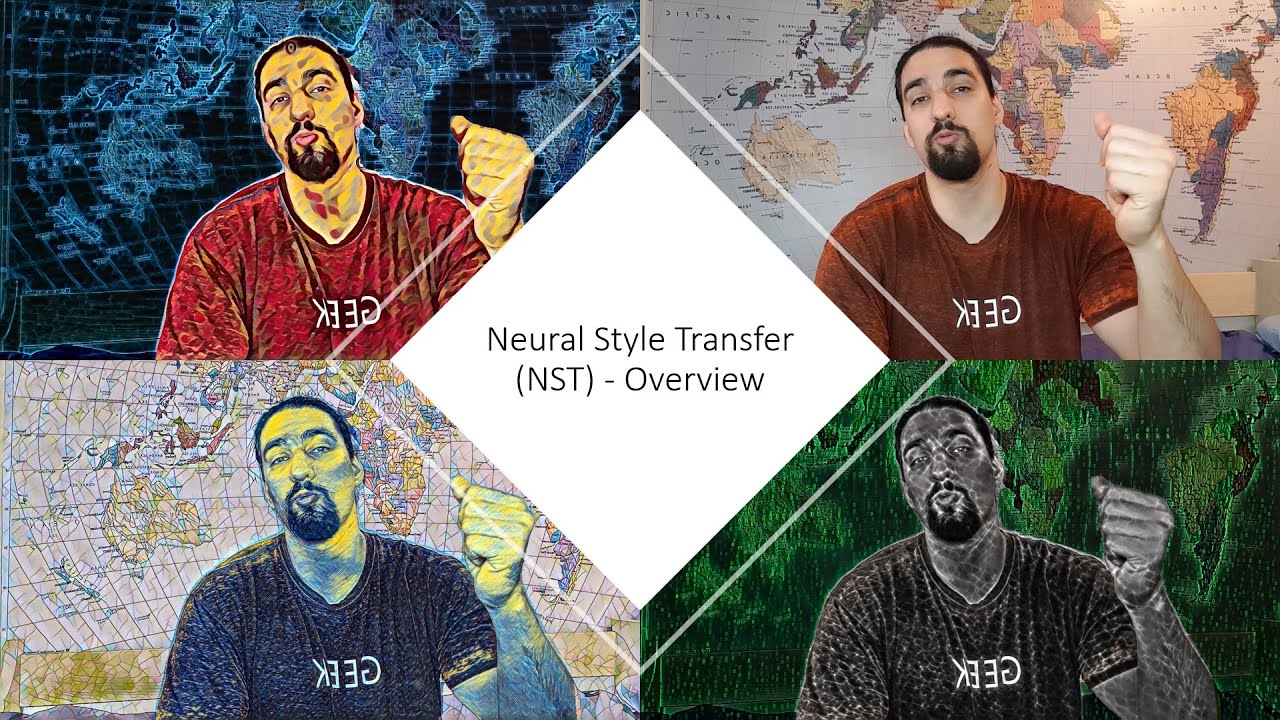

TLDRDieses Videotutorial führt in die Grundlagen des neuronalen Stiltransfers ein. Es bietet einen Überblick über die gesamte Videoserie, die sich auf das Erstellen von Stilübertragungen für statische Bilder und Videos konzentriert. Der Schwerpunkt liegt auf der praktischen Anwendung von Techniken wie dem L-BFGS-Optimierungsverfahren und der Verwendung von CNNs. Darüber hinaus wird die Geschichte des Stiltransfers von einfachen Signalverarbeitungstechniken bis hin zu modernen neuronalen Netzen erläutert. Das Video erklärt auch, wie man die Inhalts- und Stilrepräsentationen in einem CNN trennt und wie man mithilfe von Gram-Matrizen die Textur eines Bildes erfasst.

Takeaways

- 🎨 Die Serie von Videos behandelt das Thema des neuronalen Stiltransfers und ist in mehrere Abschnitte unterteilt, die sich mit verschiedenen Aspekten der Technik befassen.

- 📊 Der erste Teil der Serie konzentriert sich auf den statischen Bildstiltransfer, während der zweite Teil sich mit Videos und der Anwendung von temporalem Verlust befasst.

- 🤖 Die dritte Folge der Serie wird sich mit fortgeschrittenen Stiltransfer-Theorien und der Verwendung von CNNs ohne Optimierungsmethoden beschäftigen.

- 👨🏫 Der Ersteller der Serie möchte die Videos code-orientiert gestalten und möchte nur Python und ein oder zwei Frameworks verwenden, um die Komplexität zu reduzieren.

- 🔗 Der Code für die Serie wird über GitHub bereitgestellt, um es einfacher für die Zuschauer zu machen, die Umgebung zu klonen und sofort loszulegen.

- 🖼 Der Kern der Stiltransfer-Technik besteht darin, ein Content-Bild und ein Stil-Bild zu kombinieren, um ein kompositorisches Bild zu erzeugen, das den Stil des Stilbildes und den Inhalt des Content-Bildes aufweist.

- 🎨 Der Stiltransfer kann in zwei Kategorien eingeteilt werden: künstlerischer Stiltransfer und photorealistischer Stiltransfer.

- 📚 Die Geschichte des Stiltransfers reicht zurück bis zu einfachen Signalverarbeitungstechniken und wurde erstmals 2015 mit der Einführung des neuronalen Stiltransfers revolutioniert.

- 🧠 Die VGG-Netzwerkarchitektur, insbesondere VGG-19, spielt eine Schlüsselrolle in der Implementierung des neuronalen Stiltransfers, indem Inhalt und Stil innerhalb der Architektur entkoppelt werden können.

- 🔍 Die Inhaltsrepräsentation eines Bildes wird durch die Feature Maps bestimmter Layer des CNNs ermittelt, wohingegen die Stilrepräsentation durch Gram-Matrizen der Feature Maps gewonnen wird.

- 📉 Der Gesamtverlust im neuronalen Stiltransfer ist eine Kombination aus Inhaltsverlust und Stilverlust, wobei der Ziel ist, den Stil des Stilbildes und den Inhalt des Content-Bildes im Ergebnisbild widerzuspiegeln.

Q & A

Worum geht es in der zweiten Video-Serie des Skripts?

-Das zweite Video der Serie behandelt die grundlegende Theorie des neuronalen Stiltransfers (NST). Es bietet einen tieferen Einblick in die Theorie und wird später auf statischen Bildstiltransfer und Optimierungsmethoden wie L-BFGS oder Adam eingehen.

Was wird im dritten und vierten Video der Serie behandelt?

-Im dritten Video wird es um den statischen Bildstiltransfer mithilfe von Optimierungsverfahren wie L-BFGS oder Adam gehen. Das vierte Video dient als Anhang zum zweiten Video und behandelt fortgeschrittene Theorien zum neuronalen Stiltransfer.

Was ist das Ziel der Video-Serie laut dem Skript?

-Die Serie soll sehr praxisorientiert und codebasiert sein. Es wird hauptsächlich auf Python und PyTorch als Framework gesetzt, um es den Zuschauern einfach zu machen, den Code nachzuvollziehen. Es wird kein TensorFlow oder andere exotische Frameworks verwendet.

Was ist der Unterschied zwischen künstlerischem Stiltransfer und fotorealistischem Stiltransfer?

-Der künstlerische Stiltransfer verwendet künstlerische Bilder wie Gemälde oder Zeichnungen, um den Stil zu übertragen. Der fotorealistische Stiltransfer überträgt den Stil zwischen zwei realistischen Bildern, um einen realistischeren Effekt zu erzielen.

Was unterscheidet neuronalen Stiltransfer von herkömmlichem Stiltransfer?

-Herkömmlicher Stiltransfer existiert seit Jahrzehnten und nutzte Signalverarbeitungstechniken. Neuronaler Stiltransfer verwendet neuronale Netze, um den Stil zu übertragen, was erst ab 2015 möglich wurde und ältere Methoden übertraf.

Welche Rolle spielt das VGG-Netzwerk beim neuronalen Stiltransfer?

-Das VGG-Netzwerk wird verwendet, um sowohl die Stil- als auch die Inhaltsrepräsentationen eines Bildes zu extrahieren. Es wurde ursprünglich für Bildklassifizierungsaufgaben trainiert, spielt aber eine zentrale Rolle im neuronalen Stiltransfer, indem es Inhalte und Stile trennt.

Wie wird der Inhaltsverlust beim neuronalen Stiltransfer berechnet?

-Der Inhaltsverlust wird durch die Differenz der Feature-Maps des Eingangsbildes und des Rauschbildes im VGG-Netzwerk berechnet. Diese Differenz wird mit einer MSE-Verlustfunktion minimiert.

Wie wird der Stil eines Bildes im neuronalen Stiltransfer erfasst?

-Der Stil eines Bildes wird durch die Berechnung von Gram-Matrizen aus den Feature-Maps des VGG-Netzwerks erfasst. Diese Matrizen stellen die stilistischen Merkmale des Bildes dar, wie z.B. Texturen und Farben.

Was ist eine Gram-Matrix und welche Rolle spielt sie im Stiltransfer?

-Eine Gram-Matrix ist eine Kovarianzmatrix, die die Beziehungen zwischen verschiedenen Feature-Maps eines Bildes erfasst. Sie zeigt, welche Merkmale zusammen aktiviert werden, und wird verwendet, um die stilistische Information eines Bildes zu bestimmen.

Wie wird die Gesamtkostenfunktion (Loss) beim neuronalen Stiltransfer berechnet?

-Die Gesamtkostenfunktion ist eine gewichtete Kombination aus Inhaltsverlust und Stilverlust. Ziel ist es, ein Bild zu erzeugen, das sowohl den Inhalt des Eingabebildes als auch den Stil des Stilbildes in sich vereint.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

Basic Theory | Neural Style Transfer #2

#5.2 OOM - Bubblesort

#35 - Automation For Adding Life & Movement to Your Music (Newbie to Ninja - Logic Pro Series)

Wie schreibe ich eine Sachtextanalyse? Wie analysiere ich einen Sachtext? - Textanalyse

Crashkurs für Anfänger | Canva Tutorial Deutsch

1.1.1 Warum ist Betriebswirtschaft anders?

5.0 / 5 (0 votes)