CURSO PROMPT Engineering para CHATGPT y otros modelos - Aprende las MEJORES prácticas - Nivel BÁSICO

Summary

TLDREl curso de 'brom engineering' o ingeniería de prompt para chat GPT se enfoca en mejorar la comunicación con herramientas de inteligencia artificial para obtener mejores resultados. Incluye una definición de chat GPT y los llamados LLM (Modelos de Lenguaje a Gran Escala), principios para una comunicación efectiva, y cómo iterar y mejorar prompts. Aborda las limitaciones, como las 'alucinaciones' de GPT, y cómo evitarlas. El curso también explora aplicaciones prácticas como la generación de resúmenes, inferencias y transformación de información. Se destaca la importancia de ser claro y específico, permitir tiempo para que el modelo 'piense', y entender las limitaciones de la tecnología. Finalmente, se motiva a los usuarios a explorar y utilizar chat GPT y otros LLM en diversos campos, recordando que estas son herramientas en desarrollo constante.

Takeaways

- 📘 Aprender a comunicarte mejor con herramientas de inteligencia artificial como chat GPT para obtener mejores resultados.

- 🔍 Comprender los principios clave de comunicación con modelos de lenguaje a gran escala (LLM): claridad y especificidad en las instrucciones.

- ⏳ Dar tiempo al modelo para procesar la información, evitando respuestas precipitadas que puedan ser incorrectas.

- 🚫 Conocer las limitaciones de chat GPT, como las 'alucinaciones', donde el modelo puede generar información falsa a partir de un contexto parcialmente verdadero.

- 🔄 Iterar sobre los prompts (consultas) para afinar las respuestas, ajustando la longitud, el enfoque y el formato según sea necesario.

- 📝 Conocer las mejores prácticas para resumir contenido, enfocando en la extensión deseada y los puntos clave a destacar.

- 🧐 Utilizar verbos distintos a 'resumir', como 'extraer' o 'sintetizar', para obtener diferentes perspectivas en los resúmenes.

- 🌐 Aprender a transformar información de diversas maneras, incluyendo traducción, cambio de tono, conversión de formatos y revisión ortográfica y gramatical.

- 💡 Entender que los LLM son herramientas valiosas con aplicaciones en múltiples campos, pero no son perfectas y requieren de un uso adecuado y consciente.

- 📈 Mantenerse actualizado sobre las mejores prácticas, limitaciones y fallas de las herramientas de inteligencia artificial para mejorar su uso.

- 🌟 Descubrir y explorar las múltiples aplicaciones de chat GPT más allá de lo cubierto en el curso para ampliar sus posibilidades.

Q & A

¿Qué es la ingeniería de prompt en el contexto de este curso?

-La ingeniería de prompt es el proceso de diseñar y mejorar las instrucciones o 'prompts' que se le dan a un modelo de lenguaje a gran escala (LLM), como Chat GPT, para obtener mejores resultados en la comunicación y la generación de texto.

¿Cuáles son los dos principios clave para comunicarse correctamente con un LLM?

-Los dos principios clave son: 1) Escribir instrucciones claras y específicas para guiar al modelo hacia el resultado deseado y reducir la posibilidad de respuestas incorrectas o irrelevantes. 2) Darle tiempo suficiente al modelo para 'thinking', es decir, procesar la información y generar una respuesta adecuada.

¿Cómo se puede mejorar la claridad en un prompt a través de delimitadores?

-Se pueden utilizar delimitadores como comillas dobles o cualquier otro símbolo que indique claramente las distintas partes del prompt, ayudando al modelo a entender qué parte del texto debe tomar en cuenta para completar la tarea.

¿Por qué es importante proporcionar un ejemplo de respuesta en un prompt?

-Proporcionar un ejemplo deseado de respuesta en un prompt ayuda al modelo a entender mejor la estructura y el estilo que se busca, lo que aumenta las posibilidades de obtener una respuesta precisa y esperada.

¿Qué es la 'alucinación' en un LLM y cómo se puede evitar o reducir?

-La 'alucinación' es una limitación en la que el modelo LLM puede generar información falsa basada en un contexto parcialmente verdadero. Para evitarlo, se debe pedirle al modelo que primero busque información relevante y luego responda basado en los datos encontrados.

¿Cómo se puede iterar sobre un prompt para mejorar los resultados?

-Al notar que el resultado no es el esperado, se toma el prompt, se modifica agregando o ajustando instrucciones específicas, y se prueba de nuevo hasta obtener el resultado deseado. Esto puede incluir ajustes en la extensión de la respuesta, el énfasis en ciertos puntos o el formato deseado.

¿Cuáles son algunas de las aplicaciones comunes de chat GPT que se mencionan en el curso?

-Algunas de las aplicaciones comunes incluyen la capacidad de resumir contenido, hacer inferencias sobre sentimientos o temas en un texto, y transformar información a través de traducción, cambios de tono, conversión de formatos y revisión ortográfica y gramatical.

¿Cómo afecta la 'alucinación' la generación de información falsa en un LLM?

-La 'alucinación' puede hacer que el LLM genere información falsa de manera convincente, ya que utiliza un contexto parcialmente verdadero para crear respuestas que parecen lógicas y plausibles, lo que puede ser peligroso si no se verifica la información.

¿Por qué es importante entender las limitaciones de un LLM como Chat GPT?

-Es importante entender las limitaciones de un LLM porque, aunque son herramientas poderosas, también pueden generar errores o información incorrecta. Conocer sus limitaciones ayuda a utilizarlas de manera más efectiva y a interpretar sus respuestas con escepticismo crítico.

¿Cómo se pueden utilizar verbos distintos a 'resumir' para obtener diferentes tipos de síntesis de un texto?

-Se pueden utilizar verbos como 'extraer', 'sintetizar', 'reduci', etc., para indicar al modelo que se busque una síntesis con enfoques ligeramente diferentes, lo que puede ayudar a obtener resultados más variados y adaptados a las necesidades específicas.

¿Por qué es recomendable darle al modelo LLM el tiempo necesario para 'thinking' antes de generar una respuesta?

-Darle tiempo al modelo permite que procese la información de manera más completa y estructurada, lo que lleva a respuestas más precisas y menos propensas a errores. Limitar el tiempo o las palabras puede resultar en respuestas superficiales o incorrectas.

¿Cómo se puede mejorar la precisión de una respuesta de Chat GPT al solicitar un resumen o síntesis de un texto?

-Se puede mejorar la precisión especificando la extensión deseada del resumen, los puntos o conceptos a destacar y utilizando verbos que indiquen claramente el tipo de síntesis que se busca, como 'extraer', 'sintetizar', en lugar de simplemente 'resumir'.

Outlines

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифMindmap

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифKeywords

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифHighlights

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифTranscripts

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифПосмотреть больше похожих видео

🤖Qué es un Prompt en Inteligencia Artificial y Para qué sirve: EJEMPLOS Reales

¿Qué es un prompt en los sistemas de Inteligencia Artificial?

Capítulo 1 Clase 8 Hablando con la IA: domina y crea con Prompts - Parte 2

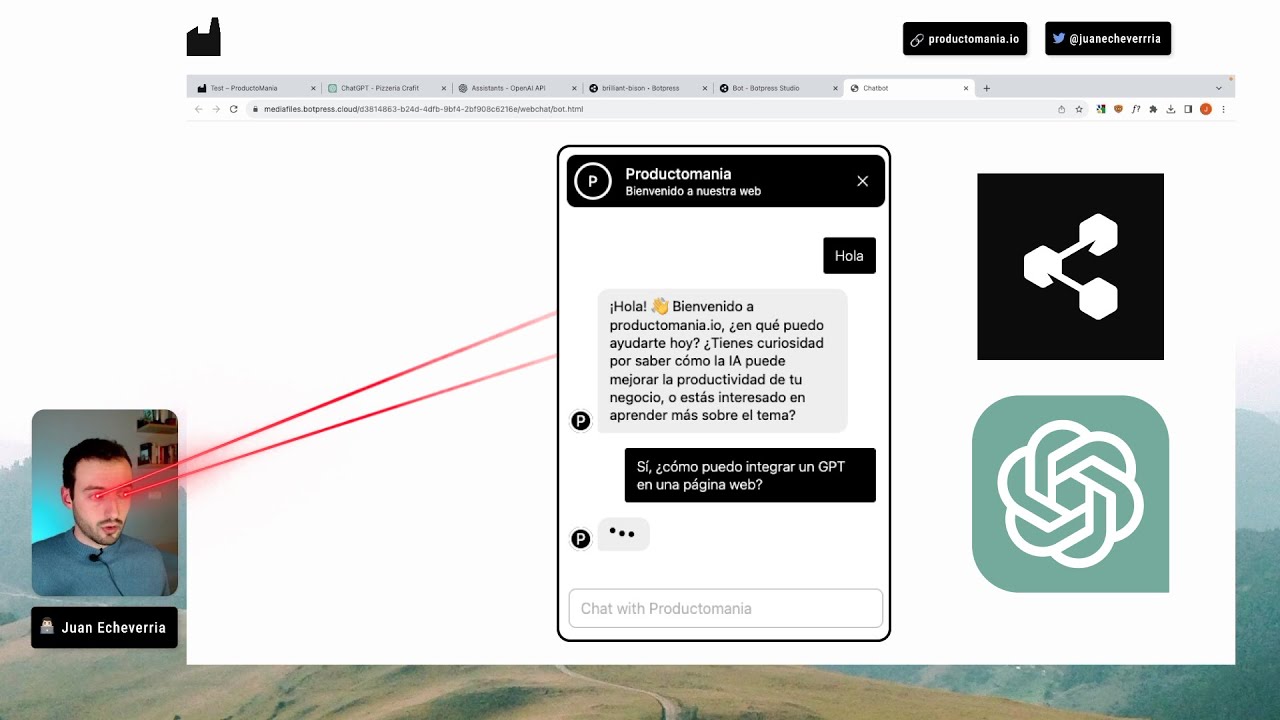

Cómo EMBEBER UN GPT en una página WEB [Tutorial paso a paso]

Módulo 1: Definición SEO, SEO vs SEM y SEO Técnico

Estructura de los Prompts de chatGPT

5.0 / 5 (0 votes)