Future of AI Networks UAL and Ultra Ethernet

Summary

TLDRこのビデオでは、AMDのUltra Accelerator Link(UA Link)とUltra Ethernetの技術が、AIや高性能コンピューティング(HPC)環境におけるスケーラビリティと効率性を向上させる方法について詳しく説明されています。UA Linkは複数のGPU間の高速通信を可能にし、専用プロトコルとして最適化されています。一方、Ultra Ethernetは多ノード間の通信に焦点を当てています。業界の主要企業が協力し、将来的にはメモリ専用ノードの統合も視野に入れています。全体を通じて、これらの技術の革新性と今後の展望が強調されています。

Takeaways

- 😀 UA LinkとUltra Ethernetは、AIとHPCのスケーラビリティと効率性を向上させるオープンスタンダードである。

- 😀 スケールアップは、複数のGPUを1つの大きなGPUとして機能させることに焦点を当てている。

- 😀 UA Linkは、ポッド内のコンポーネントを接続し、低遅延かつ高帯域幅のメモリ共有を最適化するために設計されている。

- 😀 協力関係を通じて、AMDを含む大手企業が統一されたエコシステムを構築し、様々なアクセラレータを支援している。

- 😀 UA Linkは、負荷/ストアプロトコルを使用してパケット化の必要を排除し、パフォーマンスを最適化している。

- 😀 CXLやUCIなどの他の技術との違いについても言及され、各技術の特性が強調された。

- 😀 100のGPUを1つのサーバーに配置するのは難しいが、複数のGPUを持つサーバーは可能である。

- 😀 将来的には、UA Linkがメモリ標準として進化する可能性が考慮されているが、現在は具体的な計画はない。

- 😀 参加企業は、技術の急速な変化に対応するために、定期的に新しい仕様をリリースする必要がある。

- 😀 今後の展望として、1〜2年内に新たな機能や拡張が検討されていることが示唆された。

Q & A

UA LinkとEthernetの違いは何ですか?

-UA LinkはAMDのInfinity Fabricに基づく独自のプロトコルであり、スケーラブルな環境向けに最適化されています。一方、Ethernetは一般的なネットワークプロトコルで、広く使用されていますが、スケーラブルなシステムには最適化されていません。

スケールアップの問題に対する最適な解決策は何ですか?

-UA Linkは負荷ストアプロトコルを採用しており、パケット化の必要がないため、スケールアップ環境に最適化されています。

UCIとは何で、どのようにUA Linkと異なりますか?

-UCIはパッケージ内のチップ間接続に焦点を当てており、主に小規模なポッドを実現します。UA Linkはノード間の接続を重視しており、より広範なスケーラビリティを提供します。

CXLはどのような役割を果たすのですか?

-CXLはプロセッサー外のメモリ接続を効率的に行うための技術ですが、速度に関する課題があります。将来的に重要な役割を果たすと考えられています。

AMDは新しいGPUを毎年発表する理由は何ですか?

-AMDやNvidiaは技術革新を続ける必要があり、市場競争において優位性を保つために毎年新しいGPUを発表しています。

100 GPUサーバーは現実的ですか?

-1台のサーバーに100 GPUを搭載するのは難しいですが、4〜16 GPUのサーバーは可能です。接続は主にPCIを使用し、バックエンドネットワークはUA Linkを使用します。

UA Linkは将来的にメモリ標準として採用される可能性はありますか?

-現在のところUA Linkの1.0ではメモリモジュールをサポートする予定はありませんが、今後の可能性として検討されています。

UA Linkの今後の計画はありますか?

-UA Linkは将来的にメモリ専用ノードを含む拡張が検討されていますが、具体的なロードマップはまだ策定されていません。

Ethernetはスケーラブルな環境にどのように関与していますか?

-Ethernetは多くの既存インフラに統合されているため、スケーラブルな環境でも利用されていますが、最適化はされていません。

今後の技術革新に対する業界の対応はどうなっていますか?

-業界は新技術の導入と適応に積極的であり、特に新しい仕様の発表は技術の進化に合わせて行われる必要があります。

Outlines

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantMindmap

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantKeywords

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantHighlights

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantTranscripts

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantVoir Plus de Vidéos Connexes

SNIA SDC 2024 - Disaggregated Memory for High Performance Computing

Mature at Scale Memory Fabrics for all Performance and Price Points

Optimizing Networks for Tomorrow‚ as Cloud & Enterprise - Presented by Intel

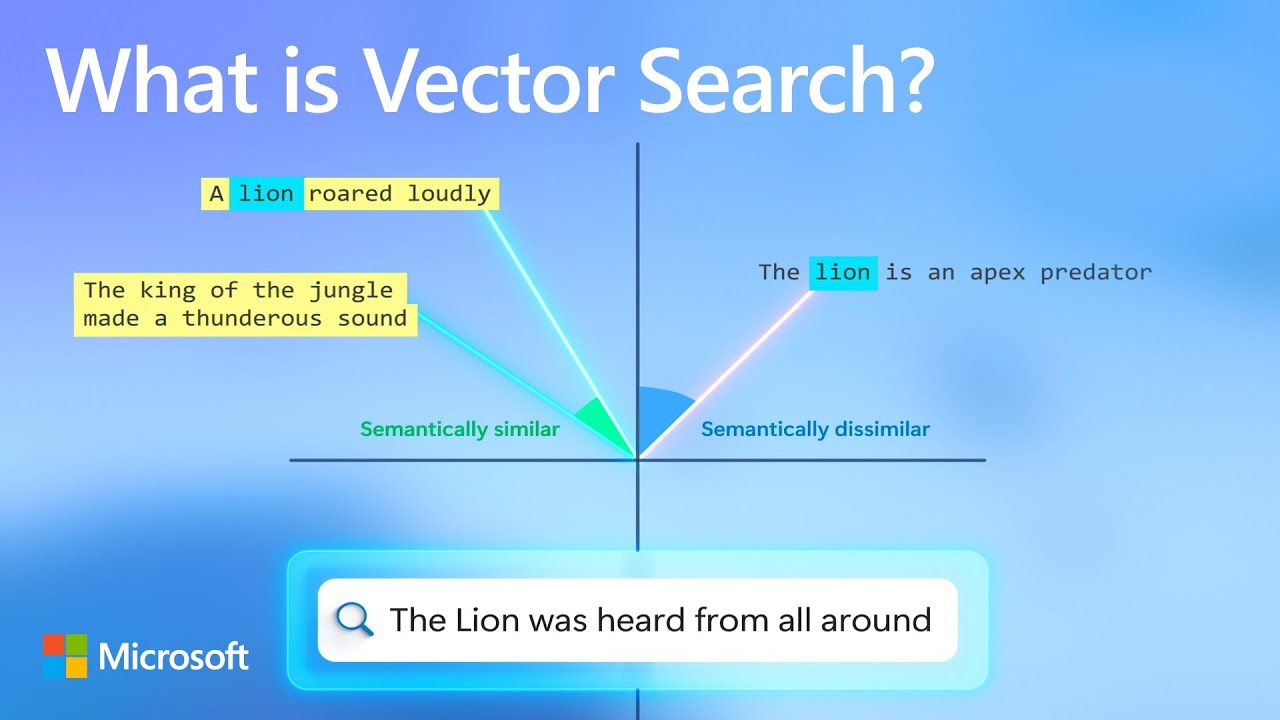

How vector search and semantic ranking improve your GPT prompts

Open Systems for Density and AI

【9割が知らない】AI時代だから差がつく!頭が良くなる読書法!「読書脳」樺沢紫苑

5.0 / 5 (0 votes)