How Robots.txt Works

Summary

TLDREn este video, Martin Splitt explica cómo usar los archivos robots.txt y las etiquetas meta robots para controlar el acceso de los bots de Google a tu sitio web. Se cubren conceptos clave como la exclusión de páginas específicas del índice de búsqueda, la diferencia entre robots.txt y las metaetiquetas, y la importancia de no bloquear una página en robots.txt si se quiere evitar que sea indexada. Además, se mencionan las herramientas de prueba disponibles, como el informe de robots.txt en Google Search Console, para verificar cómo los bots interactúan con tu página.

Takeaways

- 😀 Los archivos robots.txt permiten gestionar qué páginas de tu sitio web pueden ser indexadas por Googlebot.

- 😀 El metaetiqueta 'robots' en HTML se puede usar para evitar que una página específica sea indexada en los resultados de búsqueda.

- 😀 Puedes usar la etiqueta meta 'robots' para especificar si deseas permitir que ciertos bots (como Googlebot News) indexen una página.

- 😀 Los valores de la etiqueta 'robots' se pueden usar tanto en una metaetiqueta HTML como en un encabezado HTTP (X-Robots).

- 😀 Para evitar que Googlebot acceda a una página, puedes utilizar el archivo robots.txt, ubicado en la raíz de tu dominio.

- 😀 El archivo robots.txt contiene reglas que pueden permitir o bloquear el acceso de bots a diferentes partes de tu sitio web.

- 😀 El archivo robots.txt puede especificar reglas para bots individuales usando sus nombres de agente de usuario (user agent).

- 😀 A veces, se usan tanto robots.txt como metaetiquetas de robots, pero esto puede causar problemas si ambas instrucciones son contradictorias.

- 😀 Cuando Googlebot no puede acceder a una página debido a restricciones en robots.txt, no puede leer la metaetiqueta robots y puede indexar la página sin información completa.

- 😀 Para evitar que una página sea indexada por Google, utiliza la metaetiqueta robots o el encabezado X-Robots, pero no la combines con una restricción en robots.txt.

- 😀 Puedes probar cómo tu archivo robots.txt influye en el comportamiento de Google Search usando la herramienta de Google Search Console o el probador de robots.txt de código abierto.

Q & A

¿Qué es un archivo robots.txt y cuándo se utiliza?

-Un archivo robots.txt es un archivo de texto que se coloca en la ruta raíz de un dominio, como example.com/robots.txt. Se utiliza para decirle a los robots de los motores de búsqueda qué páginas o directorios pueden o no pueden rastrear e indexar.

¿Cuál es la diferencia entre la metaetiqueta robots y un archivo robots.txt?

-La metaetiqueta robots se inserta en el encabezado HTML de una página web y se utiliza para controlar cómo los motores de búsqueda deben tratar esa página en particular, como impedir su indexación o mostrar fragmentos. En cambio, un archivo robots.txt es un archivo global que controla el acceso de los robots a diferentes partes de todo el sitio web.

¿Cómo se utiliza la metaetiqueta robots para evitar la indexación de una página?

-Para evitar que una página se indexe, se puede agregar la metaetiqueta robots en el encabezado de la página HTML con el valor 'noindex'. Esto indicará a los motores de búsqueda que no deben incluir la página en los resultados de búsqueda.

¿Qué significa el valor 'noindex' en una metaetiqueta robots?

-El valor 'noindex' en una metaetiqueta robots le dice a los motores de búsqueda que no deben indexar la página en sus resultados. Esto impide que la página aparezca en las búsquedas, pero no necesariamente evita que los robots rastreen la página.

¿Se pueden especificar reglas para diferentes bots utilizando robots.txt?

-Sí, en el archivo robots.txt se pueden especificar reglas para diferentes bots o agentes de usuario. Por ejemplo, se puede permitir que un bot específico acceda a ciertas páginas mientras se bloquea el acceso a otros bots.

¿Qué pasa si un bot no sigue las reglas establecidas en robots.txt?

-Aunque la mayoría de los bots, como Googlebot, siguen las reglas de robots.txt, no todos los bots en internet lo hacen. Algunos bots pueden ignorar estas reglas y acceder a las páginas bloqueadas.

¿Cuál es la importancia de la configuración correcta de robots.txt y las metaetiquetas robots?

-Una configuración incorrecta de robots.txt y las metaetiquetas robots puede resultar en una indexación no deseada o en que Googlebot no pueda acceder correctamente a una página para leer la metaetiqueta robots. Es crucial usar estas herramientas de forma coherente para controlar el comportamiento de los motores de búsqueda.

¿Qué ocurre si se usa robots.txt y una metaetiqueta robots en la misma página?

-Si se bloquea el acceso a una página en robots.txt y luego se utiliza una metaetiqueta robots para evitar la indexación, Googlebot no podrá ver la metaetiqueta robots, ya que no puede acceder a la página debido al bloqueo en robots.txt. Esto puede resultar en que la página sea indexada con información limitada.

¿Cómo puedo probar la efectividad de mi archivo robots.txt?

-Puedes probar la efectividad de tu archivo robots.txt utilizando el informe de robots.txt en Google Search Console o la herramienta de prueba de robots.txt de código abierto proporcionada en el enlace que se menciona en el video.

¿Cómo se utiliza la directiva sitemap en un archivo robots.txt?

-En el archivo robots.txt, puedes incluir una directiva 'Sitemap' para señalar la ubicación de tu sitemap, lo que ayuda a los bots a encontrar las URLs relevantes para rastrear en tu sitio web.

Outlines

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraMindmap

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraKeywords

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraHighlights

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraTranscripts

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraVer Más Videos Relacionados

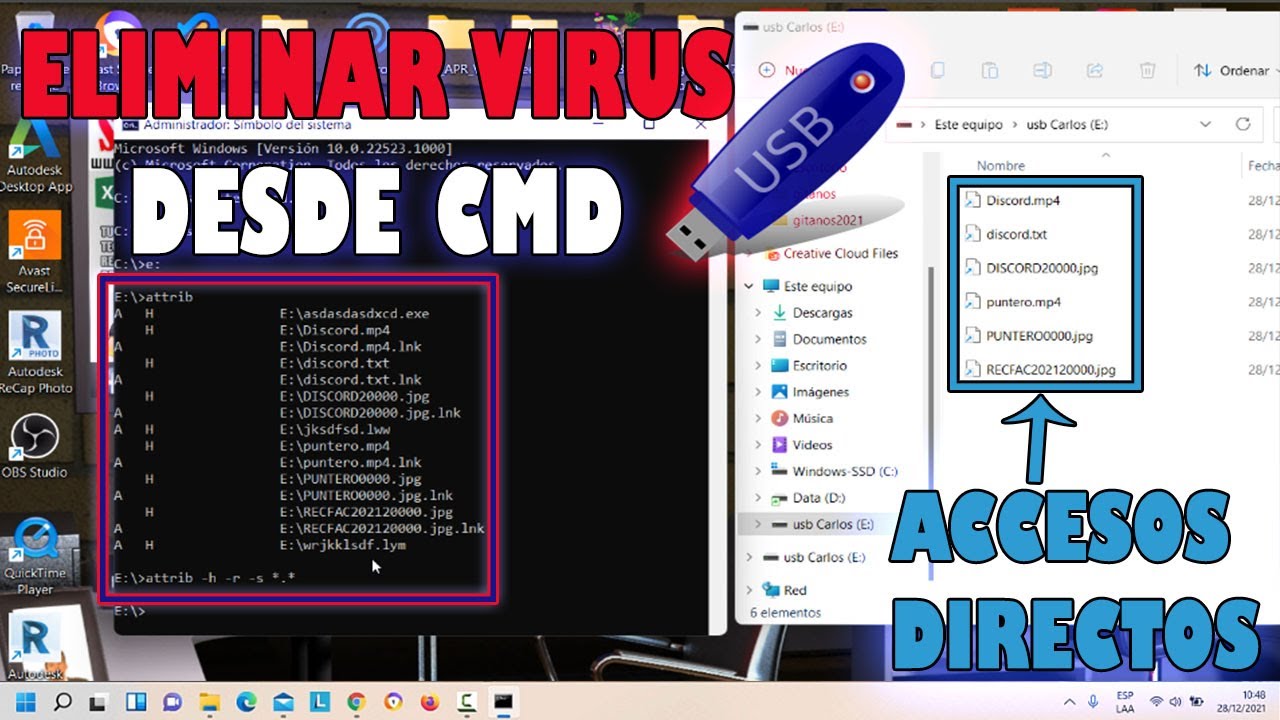

Recuperar Archivos Convertidos en Accesos Directos en USB | Eliminar Virus USB o PC | SOLUCIÓN |

como escalar un dibujo en Autocad (comando SCALE)

CURSO BASICO DE CMD #3

Photoshop: The PATRONUS Effect from Harry Potter! “Expecto Patronum!”

🟨🟩🟦 Google DRIVE De forma FÁCIL y COMPLETO ! Aprende todas sus funciones . PASO A PASO 💻📱

Almacenamiento en la Nube - Lo bueno, lo malo y lo feo

Guía completa impresión 3D para principiantes: montaje, nivelación, CURA y primeras impresiones

5.0 / 5 (0 votes)