Run ALL Your AI Locally in Minutes (LLMs, RAG, and more)

Summary

TLDREste video guía a los usuarios a través del proceso de configurar una infraestructura de inteligencia artificial local utilizando Llama 3.1 y RAG (Generación Aumentada por Recuperación). El presentador demuestra cómo cargar documentos en Google Drive y utilizarlos para responder preguntas específicas mediante el modelo de AI. Además, discute planes futuros para mejorar la infraestructura agregando tecnologías como Redis para almacenamiento en caché y Supabase para autenticación. El objetivo es crear una plataforma local fácil de usar para implementaciones de IA, ideal tanto para desarrolladores como para aquellos interesados en mejorar sus configuraciones tecnológicas locales.

Takeaways

- 😀 Se logró configurar un sistema local de IA utilizando Llama 3.1, integrado con un proceso de recuperación de documentos mediante RAG (Generación Aumentada por Recuperación).

- 😀 El sistema fue probado con éxito al hacer preguntas y obtener respuestas precisas, como sobre una campaña publicitaria centrada en 'mascotas robóticas'.

- 😀 Aunque las respuestas del modelo son correctas, se encontró que la presentación inicial de las respuestas era algo incómoda y podría mejorarse ajustando el sistema de instrucciones para la respuesta del modelo.

- 😀 El proceso de prueba mostró que la integración de Google Drive como fuente de conocimiento funciona correctamente al alimentar los documentos en el modelo de IA.

- 😀 El uso local de Llama 3.1 presenta una ventaja significativa de control y privacidad, ya que el sistema no depende de servidores externos.

- 😀 Se mencionó que la configuración es un excelente punto de partida, pero se planean futuras expansiones para mejorar la robustez y funcionalidad del sistema.

- 😀 Algunas mejoras previstas incluyen la integración de Redis para almacenamiento en caché y la sustitución de Postgres con Supabase autohospedado, lo que permitirá manejar la autenticación.

- 😀 También se sugirió la posibilidad de desarrollar una infraestructura completa de IA local que incluya tanto el backend como el frontend, facilitando su adopción y uso.

- 😀 Se explorará la creación de un stack de IA local más completo con mejores prácticas para la implementación de RAG y flujos de trabajo de LLM, buscando crear una plantilla fácil de usar.

- 😀 El creador de este sistema se muestra entusiasmado con las posibilidades de expandir y personalizar esta configuración local, con el objetivo de que sea útil y escalable para más personas.

Q & A

¿Qué es Llama 3.1 y cómo se utiliza en el video?

-Llama 3.1 es un modelo de lenguaje que se ejecuta localmente en la computadora. En el video, se utiliza para recuperar información específica de un documento almacenado en Google Drive mediante un sistema de Generación Aumentada por Recuperación (RAG).

¿Qué es el proceso de RAG (Generación Aumentada por Recuperación)?

-RAG es un enfoque que permite que un modelo de lenguaje, como Llama 3.1, recupere información relevante de una base de datos o documentos externos antes de generar una respuesta. En el video, se utiliza para obtener respuestas específicas de un documento cargado en Google Drive.

¿Por qué el autor considera que el tiempo de respuesta del modelo es lento?

-El autor menciona que el tiempo de respuesta de Llama 3.1 es lento porque está ejecutándose localmente en su computadora, que no tiene una configuración de alta potencia como una infraestructura de servidores o BPS (Back-end Processing System), lo que reduce la velocidad de respuesta.

¿Qué problema de formato se observa en la respuesta del modelo?

-La respuesta generada por Llama 3.1 es algo torpe al principio. El autor sugiere que esto se puede mejorar añadiendo instrucciones al modelo para que responda de una manera más estructurada y clara.

¿Cómo puede el autor mejorar la calidad de las respuestas de Llama 3.1?

-El autor puede mejorar la calidad de las respuestas agregando instrucciones adicionales en el 'prompt' del sistema, indicando cómo el modelo debe formatear sus respuestas para que sean más claras y estructuradas.

¿Cuál es el propósito del ejemplo que el autor muestra en el video?

-El propósito del ejemplo es demostrar cómo se puede integrar Llama 3.1 con un sistema de RAG utilizando documentos almacenados en Google Drive para obtener respuestas relevantes a preguntas específicas, como información sobre una campaña publicitaria.

¿Qué es lo que el autor planea mejorar en el sistema de IA local a futuro?

-El autor planea agregar características adicionales, como Redis para almacenamiento en caché, una versión auto-hospedada de Supabase para autenticación, y crear una plantilla más robusta para facilitar el uso de sistemas de IA locales, incluyendo mejores prácticas y flujos de trabajo para RAG y LLMs.

¿Cómo planea el autor hacer que el sistema sea más accesible para los usuarios?

-El autor planea crear un 'stack' de IA local que también incluya componentes como el front-end, facilitando la creación de soluciones completas y adaptables para aquellos que deseen implementar su propia IA local. Esto incluiría la implementación de mejores prácticas y flujos de trabajo optimizados.

¿Por qué el autor menciona que esta configuración es un buen punto de partida?

-El autor considera que la configuración presentada en el video es un buen punto de partida porque ofrece una solución básica y funcional para ejecutar IA localmente. Sin embargo, aún tiene margen para mejoras y ampliaciones que la harán más robusta y eficiente.

¿Qué beneficios ofrece usar una IA local en lugar de una basada en la nube?

-El uso de IA local permite mayor control sobre los datos y la privacidad, ya que todo se procesa en la propia infraestructura del usuario, sin depender de servicios de terceros. Además, la configuración local ofrece mayor flexibilidad y personalización.

Outlines

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraMindmap

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraKeywords

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraHighlights

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraTranscripts

Esta sección está disponible solo para usuarios con suscripción. Por favor, mejora tu plan para acceder a esta parte.

Mejorar ahoraVer Más Videos Relacionados

Building open source LLM agents with Llama 3

SISTEMA De AGENTES AI Completo Para Gmails (en n8n)

Crea una Recepcionista con Inteligencia Artificial | Retell AI + N8N + Calendar

Tutorial como hacer cluster en windows con MySQL Cluster

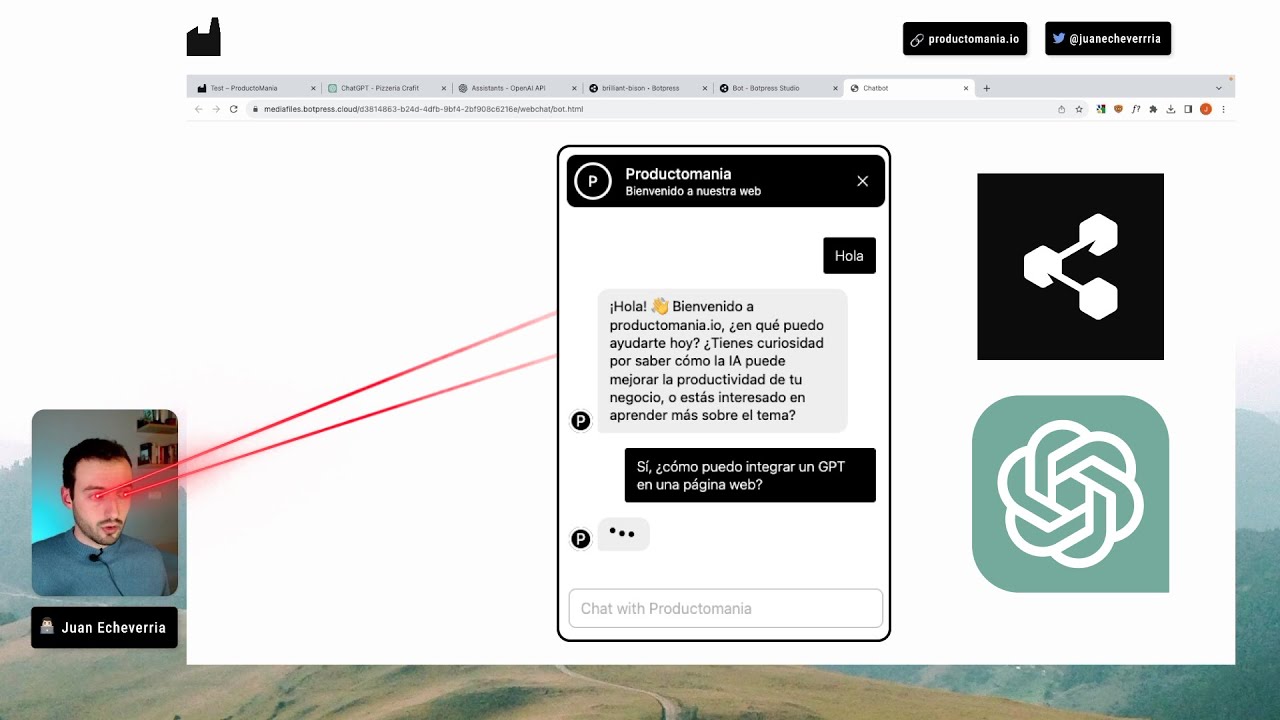

Cómo EMBEBER UN GPT en una página WEB [Tutorial paso a paso]

Cómo Crear Una Tienda de Dropshipping en 2024 (solo por 1€)

Curso Configurar VLANs + Hotspot

5.0 / 5 (0 votes)