How might LLMs store facts | Chapter 7, Deep Learning

Summary

TLDRDieses Skript beleuchtet die Funktionsweise von Multi-Layer Perceptrons (MLPs) in großen Sprachmodellen und wie sie Fakten speichern. Es wird erklärt, wie MLPs aus einfachen Matrixmultiplikationen bestehen, die jedoch schwierig zu interpretieren sind. Ein Beispiel zeigt, wie ein Modell den Faktensatz 'Michael Jordan spielt Basketball' speichern könnte. Darüber hinaus wird die Idee der Superposition diskutiert, die besagt, dass in hohen Dimensionen viele nahezu senkrechte Richtungen verwendet werden können, um eine Vielzahl von Ideen zu speichern, was die Skalierbarkeit von Modellen verbessern könnte.

Takeaways

- 🤖 Große Sprachmodelle wie Michael Jordan in der Sportart Basketball zuordnen, deuten darauf hin, dass das Modell spezifische Fakten über Personen und Aktivitäten gespeichert hat.

- 🧠 Die Fakten scheinen in einem speziellen Teil der Netzwerke, den sogenannten Multi-Layer Perceptrons (MLPs), gespeichert zu sein.

- 🔍 Die Forscher von Google DeepMind haben ermittelt, dass die Fakten in den MLPs leben, obwohl eine vollständige mechanistische Verständnis der Speicherung von Fakten noch ungelöst ist.

- 📚 Die Architektur der Transformers, auf der große Sprachmodelle basieren, besteht aus Aufmerksamkeits- und MLP-Blöcken, wobei die meisten Modellparameter in den MLP-Blöcken liegen.

- 🧮 Die Berechnungen innerhalb der MLPs sind relativ einfach und bestehen aus einer Reihe von Matrixmultiplikationen mit einer einfachen Operation dazwischen.

- 📈 Die Interpretation dieser Berechnungen ist jedoch sehr herausfordernd, da die Vektoren in einem sehr hochdimensionalen Raum leben, in dem verschiedene Richtungen verschiedene Bedeutungen kodieren können.

- 🏀 Ein konkretes Beispiel zeigt, wie ein MLP-Block die Tatsache speichern könnte, dass Michael Jordan Basketball spielt, indem es die entsprechenden Vektoren und Richtungen in einem hochdimensionalen Raum nutzt.

- 🔑 Die Aktivierung von Neuronen in einem MLP-Block kann auf die Ausrichtung eines Vektors mit bestimmten Richtungen im hochdimensionalen Raum hindeuten, was für die Interpretation von Fakten wichtig ist.

- 🔍 Die Idee der Superposition, wonach Vektoren, die fast orthogonal sind, viel mehr Informationen kodieren können als orthogonale Vektoren, könnte erklären, warum Modelle mit zunehmender Größe ihre Leistung verbessern.

- 🔗 Die Superposition kann auch die Interpretierbarkeit von Modellen erschweren, da einzelne Merkmale möglicherweise nicht als Aktivierung eines einzelnen Neurons sichtbar sind, sondern als Kombination mehrerer Neuronen.

Q & A

Wie funktioniert die Vorhersage eines großen Sprachmodells, wenn es einen Satz wie 'Michael Jordan spielt die Sportart von Leerstelle' erhält?

-Das Modell verwendet seine Hunderte von Milliarden Parametern, die durch Training mit Daten gefüllt sind, um korrekt 'Basketball' vorherzusagen. Dies deutet darauf hin, dass es spezifische Fakten wie die Beziehung zwischen einer Person und ihrer Sportart gespeichert hat.

Wo werden diese Fakten in einem Sprachmodell gespeichert?

-Die Fakten scheinen in einem speziellen Teil des Netzwerks, den sogenannten Multi-Layer Perceptrons (MLPs), gespeichert zu sein.

Was ist die Funktion von MLPs in einem Sprachmodell?

-MLPs bestehen aus einer Reihe von Matrixmultiplikationen mit einer einfachen Operation dazwischen. Sie bieten zusätzlichen Speicherplatz, um Fakten abzuspeichern, und sind für die Verarbeitung von Eingaben verantwortlich, die in einen bestimmten Vektor umgewandelt werden.

Wie interpretiert man die Berechnungen innerhalb der MLPs?

-Die Interpretation ist sehr herausfordernd, da die Vektoren in einem sehr hohen Dimensionsraum leben, in dem verschiedene Richtungen verschiedene Bedeutungen kodieren können.

Was ist ein Beispiel dafür, wie ein MLP-Block einen konkreten Fakten speichern könnte?

-Ein Beispiel ist die Speicherung des Faktums, dass Michael Jordan Basketball spielt, durch die Aktivierung bestimmter Neuronen, die mit dem vollständigen Namen und der Sportart korrelieren.

Wie viele Parameter hat die Matrix in einem MLP-Block und wie sind sie mit dem Eingabevektor verbunden?

-Die Matrix hat etwa 50.000 Zeilen, die der Größe des Einbettungsraums entsprechen. Jeder Eingabevektor wird mit dieser Matrix multipliziert, was eine Reihe von Dot-Produkten ergibt, die auf die Eigenschaften des Eingabevektors abgestimmt sind.

Was ist die Funktion der Bias-Vektoren in der Matrixmultiplikation?

-Bias-Vektoren werden zu den Ergebnissen der Matrixmultiplikation hinzugefügt und stellen eine Art von Versatz dar, der das Modell ermöglicht, seine Ausgaben zu justieren.

Warum wird die ReLU-Funktion in der Verarbeitung von MLPs verwendet?

-Die ReLU-Funktion (Rectified Linear Unit) wird verwendet, um die negativen Werte auf Null zu setzen und die positiven Werte beizubehalten, was die Aktivierung der Neuronen im Modell ermöglicht.

Wie viele MLP-Blöcke gibt es in einem Modell wie GPT-3 und wie viele Parameter umfassen sie?

-GPT-3 hat 96 MLP-Blöcke, die insgesamt etwa 116 Milliarden Parameter umfassen, was etwa zwei Drittel der gesamten Parameter des Netzwerks ausmacht.

Was ist die Hypothese der Superposition und wie könnte sie die Interpretierbarkeit von Sprachmodellen erklären?

-Die Superposition ist die Idee, dass viele verschiedene Merkmale durch fast senkrechte Richtungen im hohen Dimensionsraum des Modells dargestellt werden. Dies könnte erklären, warum einzelne Neuronen selten ein einzelnes klares Merkmal repräsentieren und warum Modelle mit wachsender Größe ihre Leistung steigen lassen.

Outlines

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenMindmap

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenKeywords

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenHighlights

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenTranscripts

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenWeitere ähnliche Videos ansehen

ChatGPT Limitations and Reliability

52) Dizilere(Array) Giriş | JAVASCRIPT Dersleri

Evolution der Religion - Aus Quarks & Co. 2014

Neuronale Netze unter der Lupe | Die Welt der KI entdecken 10

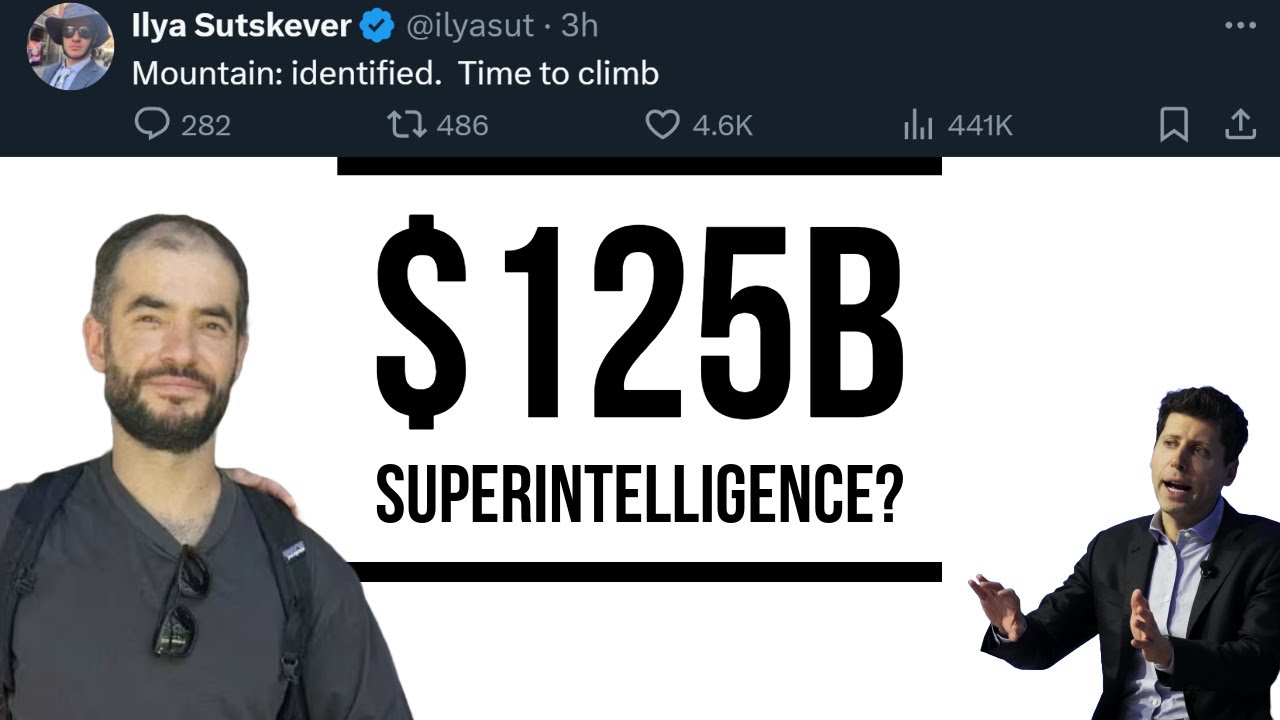

$125B for Superintelligence? 3 Models Coming, Sutskever's Secret SSI, & Data Centers (in space)...

Ich bin so wütend! Kindliche Aggression

How to Release Emotions Trapped in Your Body 10/30 How to Process Emotions Like Trauma and Anxiety

5.0 / 5 (0 votes)