Neuronale Netze unter der Lupe | Die Welt der KI entdecken 10

Summary

TLDRDieses Skript bietet einen umfassenden Überblick über neuronale Netze, ihre Funktionsweise und ihre Anwendungen in Bereichen wie Bildrkennung, Übersetzung und mehr. Es erklärt die Grundstruktur von Neuronen und wie sie in künstlichen neuronalen Netzwerken zusammenarbeiten, um Lernprozesse und Erinnerungen zu simulieren. Es geht auch auf das Training solcher Netze ein, wie sie Gewichte und Bias anpassen, um Vorhersagen zu optimieren, und stellt verschiedene Netztypen wie Feed-Forward-Netzwerke, CNNs und GANs vor. Der Fokus liegt auf der Fähigkeit von neuronalen Netzen, komplexe Datenmuster zu verarbeiten und zu lernen.

Takeaways

- 🧠 Neuronale Netze sind eine Sammlung verschiedener, aber verwandter Methoden, die Eingabedaten verarbeiten und nützliche Ausgaben liefern.

- 💡 Diese Netze sind inspiriert vom menschlichen Gehirn, das aus Nervenzell组团, sogenannten Neuronen, besteht.

- 🔄 Neurone reagieren auf eingehende Signale und passen ihre Reaktionen im Laufe der Zeit an, was das Lernen und Merken ermöglicht.

- 🤖 Künstliche Neuronen werden durch Computer implementiert, wobei elektrische Signale die Eingabedaten repräsentieren.

- 🔢 Die Funktionsweise eines Neurons basiert auf der Multiplikation von Eingabewerten mit Gewichten, Summierung und Aktivierung durch eine Aktivierungsfunktion.

- 📈 Aktivierungsfunktionen wie der ReLU (Rectified Linear Unit) ermöglichen es neuronalen Netzen, die Beziehung zwischen Ein- und Ausgabe zu modellieren.

- 🌐 Neuronale Netze bestehen aus Schichten, wobei die Ausgabe einer Schicht als Eingabe für die nächste Schicht dient.

- 📊 Das Training neuronaler Netze erfolgt durch überwachtes Lernen, bei dem die tatsächliche Ausgabe mit dem Sollwert verglichen und Fehler minimiert werden.

- 🔧 Das Ziel des Trainings ist es, die Gewichte und Biaswerte so anzupassen, dass das Netzwerk die richtige Vorhersage trifft.

- 🖼️ Spezialisierungen von Neuronale Netzen, wie Convolutional Neural Networks (CNNs), sind für Aufgaben wie die Bilderkennungs optimiert.

- 🎨 Generative Adversarial Networks (GANs) bestehen aus zwei Netzwerken, einem Generator und einem Diskriminator, die gegenseitig trainiert werden, um Daten zu generieren oder zu fälschen.

Q & A

Was sind neuronale Netze und wofür werden sie verwendet?

-Neurnale Netze sind eine Reihe verschiedener, aber verwandter Methoden, die Eingabedaten verarbeiten und nützliche Ausgaben liefern. Sie werden für eine Vielzahl von Anwendungen verwendet, darunter Bilderkennung, Nachahmung von Kunststilen, Computer-Übersetzung und mehr.

Wie funktionieren neuronale Netze im Vergleich zu unserem Gehirn?

-Neurnale Netze sind entfernt von unserem Gehirn inspiriert. Sie bestehen aus sogenannten Neuronen, die eingehende Signale aufnehmen und bei Erreichen eines Schwellenwerts ein Signal an andere Neuronen ausgeben. Im Vergleich zum menschlichen Gehirn sind sie jedoch stark vereinfacht und arbeiten mit Zahlen anstatt Nervenzellen.

Was ist ein künstliches Neuron und wie verhält es sich zu einem echten Neuron?

-Ein künstliches Neuron ist eine vereinfachte Version eines echten Neurons. Es nimmt Eingabesignale, multipliziert sie mit Gewichten, summiert sie und gibt bei Erreichen eines bestimmten Schwellenwerts ein Signal aus. Es kann jedoch nicht besonders viel ohne die Zusammenarbeit mit vielen anderen künstlichen Neuronen.

Was ist eine Aktivierungsfunktion und welche Rolle spielt sie in neuronalen Netzen?

-Eine Aktivierungsfunktion ist ein Mechanismus, der die Beziehung zwischen Ein- und Ausgabe in neuronalen Netzen modelliert. Sie gibt neuronalen Netzen mehr Möglichkeiten, indem sie die Ausgaben der Neuronen in einer Schicht verändert, um die Ausgaben der nächsten Schicht zu beeinflussen.

Wie wird ein neuronales Netz trainiert?

-Ein neuronales Netz wird durch überwachtes Lernen trainiert. Das bedeutet, dass es Eingabe- und Erwartungsausgabe-Paare erhält, um die Gewichte und Biase im Netz anzupassen, um den Fehler zu minimieren. Dieser Prozess wird als Backpropagation bezeichnet.

Was sind einige der bekanntesten Aktivierungsfunktionen in neuronalen Netzen?

-Zu den bekanntesten Aktivierungsfunktionen gehören der ReLU (Rectified Linear Unit), der nur positive Werte weitergibt, und die Sigmoid-Funktion, die negative Werte annähernd Null und positive Werte annähernd Eins auf eine S-förmige Kurve abbildet.

Was sind die Vorteile von Mehr-Schichten-Netzwerken im Vergleich zu Ein-Schicht-Netzwerken?

-Mehr-Schichten-Netzwerke können komplexere Beziehungen zwischen Eingabe und Ausgabe abdecken und modellieren. Sie ermöglichen es, Daten in mehreren Abstraktionsebenen zu verarbeiten, was zu besseren Lernresultaten führt.

Was sind Convolutional Neural Networks (CNNs) und wie unterscheiden sie sich von regulären neuronalen Netzen?

-Convolutional Neural Networks (CNNs) sind spezialisierte neuronale Netze, die für die Bildverarbeitung entwickelt wurden. Sie verwenden Convolution und Pooling Schichten, um Muster in Bildern zu erkennen und zu klassifizieren, was sie effektiver für die Bildrkennung macht.

Was sind Generative Adversarial Networks (GANs) und wie funktionieren sie?

-Generative Adversarial Networks (GANs) bestehen aus zwei Teilnetzwerken: einem Generator, der neue Inhalte erzeugt, und einem Diskriminator, der beurteilt, ob ein Inhalt echt oder gefälscht ist. Sie werden durch gegenseitiges Lernen trainiert, wobei der Generator immer besser im Erzeugen von Inhalten und der Diskriminator im Unterscheiden von echten und gefälschten Inhalten wird.

Warum ist es manchmal schwierig, die Entscheidungen von neuronalen Netzen zu erklären?

-Neurnale Netze können sehr komplex sein mit vielen Parametern, die optimiert werden müssen. Dies kann dazu führen, dass bestimmte Entscheidungen des Netzes schwer zu verstehen sind, da die Beziehung zwischen Eingabe und Ausgabe nicht immer klar ist.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

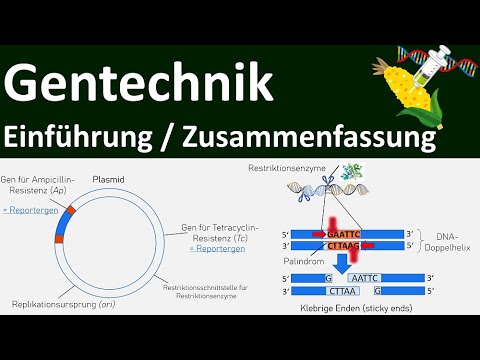

Gentechnik - [Einführung + Zusammenfassung] - Abitur [Biologie, Genetik, Oberstufe] - [1/7]

Leber - Aufbau und Funktion einfach erklärt

TextCortex explained in 180 seconds

Explaining Intel & AMD CPUs

Cybersecurity Career Paths: Which One Is Right for You?

Supervised vs Unsupervised vs Reinforcement Learning | Machine Learning Tutorial | Simplilearn

5.0 / 5 (0 votes)