Demo: Rapid prototyping with Gemma and Llama.cpp

Summary

TLDRJeffrey Hui, ingénieur chez Google, présente comment utiliser localement des grands modèles de langage (LLM) via llama.cpp, un framework open-source optimisé pour les appareils, notamment les MacBooks. Il montre comment éviter les coûts élevés d'appels d'API ou les problèmes de connexion en utilisant Gemma sur son propre appareil. Jeffrey illustre cela en créant un jeu similaire à Connections du New York Times, où il génère des modèles à partir de Gemma localement. Il met en avant la rapidité, l'efficacité et la possibilité de développer des applications sans dépendre de serveurs externes coûteux ou inaccessibles.

Takeaways

- 🔧 Jeffrey Hui, ingénieur de recherche chez Google, aime travailler sur des projets parallèles, en particulier sur des outils logiciels pour lui-même.

- 💡 Il explore l'utilisation des grands modèles de langage (LLM) dans ses projets de développement, mais l'utilisation des API peut être coûteuse et nécessiter une connexion internet stable.

- 🚆 L'objectif de sa présentation est de montrer comment utiliser le modèle Gemma localement avec l'écosystème *llama.cpp*, un cadre d'inférence open-source pour exécuter des LLM sur des machines locales.

- 💻 *llama.cpp* est optimisé pour les appareils personnels, en particulier les MacBooks, et écrit en C++ avec un minimum de dépendances, ce qui le rend efficace et portable.

- 📂 Gemma est disponible au format GGUF, un format de checkpoint auto-contenu, conçu pour une utilisation facile avec *llama.cpp*, éliminant le besoin de fichiers de configuration supplémentaires.

- 🤝 Grâce à *llama.cpp*, il est possible de faire des inférences localement en une seule ligne de code, après avoir téléchargé le modèle depuis le dépôt Hugging Face.

- 🎮 Jeffrey donne un exemple pratique en construisant un mini-jeu inspiré de *Connections* du *New York Times* pour démontrer l'utilisation de Gemma.

- 🔄 L'exécution locale du modèle permet d'itérer rapidement sur les prompts et de tester en temps réel, rendant le développement plus fluide et économique.

- 📝 Il utilise l'interface LM Studio pour configurer et interagir avec le modèle Gemma, tout en insistant sur le fait qu'il est accessible depuis une machine standard.

- 🎉 L'élément clé est la capacité de prototyper des applications localement, sans frais supplémentaires, tout en ayant des performances comparables à celles d'une API externe.

Q & A

Qui est Jeffrey Hui et que fait-il chez Google ?

-Jeffrey Hui est un ingénieur en recherche chez Google. En parallèle, il aime créer des projets annexes, notamment des outils logiciels pour lui-même.

Pourquoi Jeffrey aime-t-il utiliser des LLM (modèles de langage) dans son processus de développement ?

-Jeffrey apprécie utiliser des LLM car ils lui permettent d'enrichir son cycle de développement. Cependant, appeler une API pour ces modèles peut devenir coûteux et nécessite une connexion Internet stable.

Quel problème Jeffrey rencontre-t-il lorsqu'il utilise des modèles via une API ?

-L'utilisation d'une API pour des modèles de langage peut s'avérer coûteuse, et l'absence d'une connexion Internet stable, comme dans un avion ou un train, peut rendre l'accès difficile.

Qu'est-ce que llama.cpp et pourquoi est-il important pour Jeffrey ?

-Llama.cpp est un cadre d'inférence open-source permettant d'exécuter des modèles de langage de grande taille localement, sur sa propre machine. Il est optimisé pour les ordinateurs, en particulier les MacBooks, et est léger avec peu de dépendances.

Pourquoi llama.cpp est-il avantageux pour les utilisateurs ?

-Llama.cpp permet d'exécuter des modèles en local sans nécessiter de connexion Internet ou d'API externe, ce qui réduit les coûts et permet d'itérer rapidement sur des projets.

Qu'est-ce que le format GGUF et pourquoi est-il important dans ce contexte ?

-Le format GGUF est un format de point de contrôle auto-contenu, conçu pour être utilisé avec llama.cpp. Il regroupe toutes les informations nécessaires à l'exécution d'un modèle dans un seul fichier, simplifiant ainsi l'utilisation et le partage des modèles.

Quel projet Jeffrey présente-t-il dans cette démo ?

-Jeffrey montre comment utiliser le modèle Gemma pour créer un jeu similaire à 'Connections', un mini-jeu de mots du New York Times, qui génère de nouveaux puzzles localement.

Comment Jeffrey teste-t-il le bon fonctionnement du modèle Gemma ?

-Jeffrey teste le modèle en lui demandant de générer des mots et des associations de mots, comme dans le jeu 'Connections', et il vérifie que les résultats sont corrects et en accord avec ses attentes.

Quels sont les avantages de l'utilisation d'un modèle en local selon Jeffrey ?

-L'exécution d'un modèle en local permet de développer et d'itérer rapidement sans coûts supplémentaires, contrairement à une API externe qui peut devenir onéreuse. Cela permet aussi d'expérimenter sans restrictions.

Quelle est la principale conclusion de la démo de Jeffrey ?

-Jeffrey démontre que l'utilisation de modèles localement, comme avec llama.cpp et Gemma, permet d'avoir un environnement de développement flexible et économique, ouvrant la voie à de nombreuses possibilités pour les développeurs.

Outlines

此内容仅限付费用户访问。 请升级后访问。

立即升级Mindmap

此内容仅限付费用户访问。 请升级后访问。

立即升级Keywords

此内容仅限付费用户访问。 请升级后访问。

立即升级Highlights

此内容仅限付费用户访问。 请升级后访问。

立即升级Transcripts

此内容仅限付费用户访问。 请升级后访问。

立即升级浏览更多相关视频

Accelerating LLM family of models on Arm Neoverse based Graviton AWS processors with KleidiAI

Comment avoir des IA (LLMs) en local sur son ordinateur facilement ? (Présentation d'Ollama)

MISTRAL AI : Comment installer GRATUITEMENT le Chat GPT Français en local ? (WebUI)

Demo: Gemma on-device with MediaPipe and TensorFlow Lite

WTF is an AI PC?

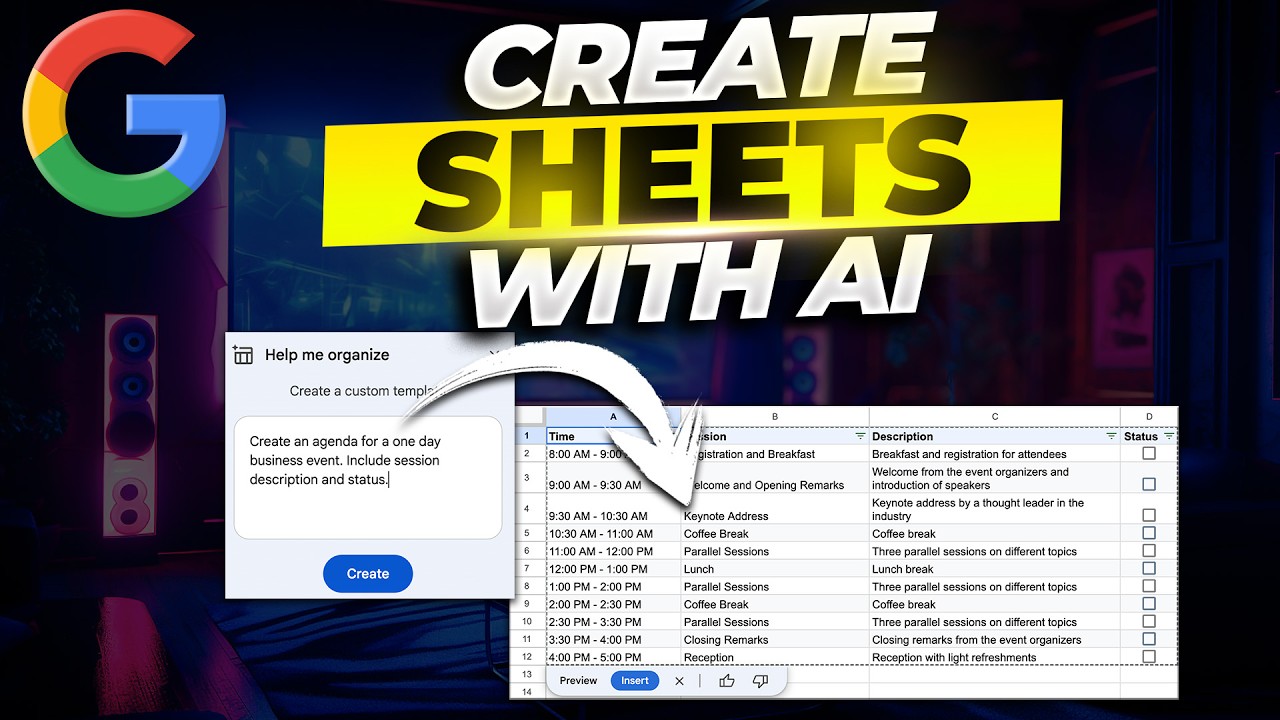

Create Google Sheets Automatically using AI

5.0 / 5 (0 votes)