Accelerating LLM family of models on Arm Neoverse based Graviton AWS processors with KleidiAI

Summary

TLDRDans cette présentation, MIL Pich discute des avancées réalisées par ARM pour optimiser l'exécution des modèles de langage de grande taille (LLM) sur les processeurs ARM. Il présente l'intégration d'un nouveau logiciel, Clay, conçu pour simplifier l'intégration des accélérateurs ARM dans les frameworks de machine learning comme PyTorch. Grâce à des techniques de quantification et d'optimisation, les performances sont améliorées, notamment sur des modèles comme Llama et Google JMA. L'intégration de Clay permet des gains significatifs en termes de performance et d'efficacité énergétique, tout en facilitant l'adoption par les développeurs.

Takeaways

- 😀 ARM travaille sur l'optimisation des modèles de langage (LLMs) pour les exécuter efficacement sur des processeurs ARM.

- 🤖 Les modèles d'apprentissage machine, comme les LLMs, sont souvent exécutés à l'aide de bibliothèques comme PyTorch et OpenBLAS pour l'accélération.

- ⚡ Deux approches sont utilisées pour l'accélération des modèles : décomposition graduelle (top-down) et approche basée sur le compilateur (bottom-up).

- 🛠 L'intégration de plusieurs bibliothèques peut entraîner des coûts supplémentaires liés à la gestion de la mémoire et des threads, ce qui impacte la performance.

- 🆕 Une nouvelle bibliothèque, Cing, a été introduite pour simplifier l'intégration des accélérateurs ARM dans les frameworks ML.

- 📦 Cing est une bibliothèque légère et performante qui ne nécessite aucune dépendance externe et supporte les formes dynamiques de données.

- 🔧 Cing peut être intégré facilement à des frameworks comme PyTorch, ACL, OpenBLAS et les compilateurs ML pour améliorer les performances des LLMs.

- 🔍 L'intégration de Cing avec PyTorch a été démontrée à travers un processus de quantification des poids de modèles pour réduire la taille de la mémoire (réduction de 87 %).

- 💡 L'utilisation de la quantification des poids et l'optimisation des couches linéaires permettent d'améliorer les performances des modèles LLM.

- 📊 Les tests de performance ont montré que l'intégration de Cing avec PyTorch offre des gains significatifs, y compris une réduction de 60 % de la consommation énergétique et une augmentation de 25 % des performances par rapport à la génération précédente de processeurs Graviton.

- 🚀 Cing contribue à l'amélioration des performances de PyTorch sur les processeurs ARM et est une technologie ouverte pour l'accélération des charges de travail AI/ML.

Q & A

Quel est le principal objectif des travaux réalisés par ARM concernant les modèles de langage à grande échelle ?

-L'objectif principal des travaux d'ARM est d'accélérer l'exécution des modèles de langage à grande échelle sur les processeurs ARM afin de les rendre plus efficaces, notamment en utilisant des accélérateurs ARM intégrés.

Quels sont les deux approches principales pour accélérer les opérations des modèles de machine learning mentionnées dans la présentation ?

-Les deux approches sont la décomposition graduelle, qui suit une approche top-down et utilise des bibliothèques comme OpenBLAS ou ACL, et l'approche par compilation utilisant un ensemble fixe d'opérations pour optimiser le code et exploiter les accélérateurs ARM.

Qu'est-ce que la bibliothèque CING et pourquoi est-elle importante ?

-La bibliothèque CING est une bibliothèque légère et performante dédiée à l'accélération des modèles de machine learning sur ARM. Elle est importante car elle simplifie l'intégration des accélérateurs ARM dans les frameworks, permettant ainsi une meilleure efficacité et des performances accrues.

Quels types d'opérations le CING optimise-t-il pour les modèles de machine learning ?

-CING optimise des opérations comme la multiplication de matrices (gemm), et fonctionne sans dépendances avec d'autres bibliothèques, ce qui lui permet d'être intégré directement dans les frameworks comme PyTorch, ACL ou d'autres compilateurs de ML.

Comment ARM a-t-il amélioré l'efficacité des modèles de langage en utilisant la bibliothèque CING ?

-ARM a amélioré l'efficacité des modèles de langage en quantifiant les poids des modèles à 4 bits, ce qui réduit la taille des données et améliore les performances. En utilisant CING, ces modèles peuvent tirer parti des accélérateurs ARM pour des calculs plus rapides et une meilleure utilisation de la mémoire.

Quel est l'avantage de la quantification des poids des modèles dans le processus de génération de texte ?

-La quantification des poids des modèles permet de réduire considérablement l'empreinte mémoire, avec une compression allant jusqu'à 87%, ce qui permet d'accélérer les calculs tout en réduisant la consommation d'énergie.

Quelles sont les performances obtenues en utilisant les instances ARM Graviton 3 sur AWS par rapport à la génération précédente ?

-Les instances ARM Graviton 3 offrent une amélioration de 25% des performances, une multiplication des performances ML par trois, et une réduction de 60% de la consommation d'énergie par rapport aux Graviton 2.

Pourquoi la bibliothèque CING est-elle considérée comme une bibliothèque sans dépendances ?

-CING est considérée comme une bibliothèque sans dépendances car elle ne nécessite pas d'autres bibliothèques externes pour fonctionner, ce qui simplifie son intégration dans différents environnements et systèmes sans ajouter de surcharge de gestion des dépendances.

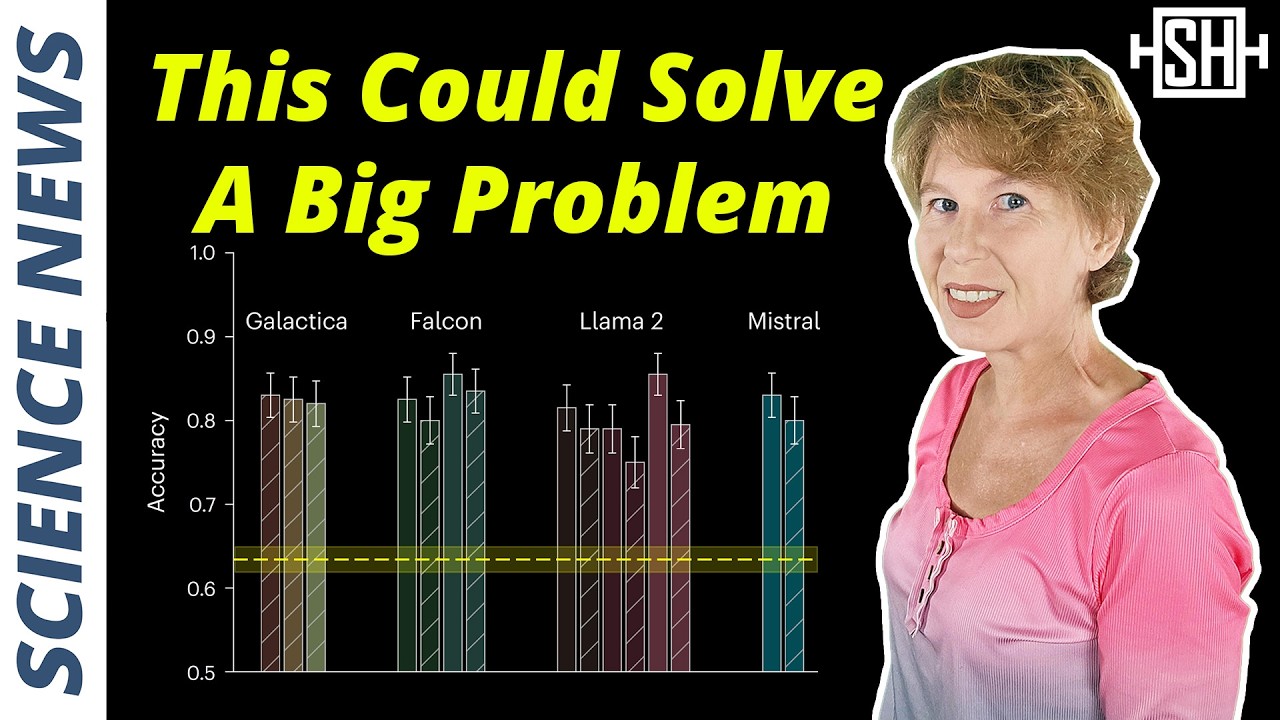

Quels modèles ont été utilisés dans les tests de performance décrits dans la présentation ?

-Les tests de performance ont utilisé les modèles Llama 2 et Llama 3, ainsi que le modèle JMA de Google.

Quel est le résultat de l'intégration de la bibliothèque CING dans PyTorch en termes de génération de texte ?

-L'intégration de CING dans PyTorch améliore les performances de génération de texte, permettant de produire plus rapidement des tokens avec une légère différence par rapport à l'exécution sur des frameworks non optimisés, tout en maintenant une bonne qualité de génération.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

AIs Predict Research Results Without Doing Research

Comment avoir des IA (LLMs) en local sur son ordinateur facilement ? (Présentation d'Ollama)

Dijkstra on foolishness of Natural Language Programming

Mindblowing Research That Will Change The Way You Use LLMs

THIS is the REAL DEAL 🤯 for local LLMs

Apple prépare un coup de maître ?!

5.0 / 5 (0 votes)