Introduction à l’intelligence artificielle - 5 - Apprentissage Automatique

Summary

TLDRCe script présente les principes de la modélisation prédictive et de l'apprentissage automatique, expliquant comment les modèles statistiques évoluent avec de nouvelles données pour éviter l'obsolescence. Il introduit les concepts de validation croisée et de régularisation pour contrôler le sur-apprentissage et optimiser les modèles. Le texte couvre une variété d'algorithmes, allant des méthodes simples comme KNN et les arbres de décision, aux modèles plus complexes tels que les SVM, les réseaux neuronaux et les forêts aléatoires, mettant en évidence leur utilisation dans divers domaines tels que la finance, la robotique et les jeux.

Takeaways

- 📊 Le modèle prédictif a pour but de donner une probabilité de mesure ou d'occurrence d'un événement.

- 📐 L'essence de la création de modèles repose sur le calcul de distances entre observations.

- 🔍 La classification d'une observation inconnue est basée sur sa proximité avec des observations connues.

- 📚 L'importance de l'algèbre linéaire et du calcul matricielle est soulignée pour faciliter les mesures de distance.

- ⏳ Les modèles statiques deviennent obsolètes avec le temps, car les corrélations à leur base évoluent.

- 🔄 L'évolution automatique des modèles est recherchée pour s'adapter aux nouvelles observations sans intervention manuelle.

- 🔒 La validation croisée et la régularisation sont des concepts clés pour éviter le sur-apprentissage et améliorer la fiabilité des modèles.

- 🔄 La validation croisée implique de tester le modèle sur des échantillons différents pour assurer sa validité.

- 🔧 La régularisation ajuste la fonction de coût pour contrôler l'optimisation et éviter le sur-apprentissage.

- 🛠️ L'apprentissage automatique est axé sur l'optimisation des hyper-paramètres plutôt que la simple définition des paramètres du modèle.

- 🌐 Il existe une variété d'algorithmes d'apprentissage, allant des méthodes supervisées à non supervisées et de l'apprentissage par renforcement.

- 🌳 Les forêts aléatoires sont un exemple d'algorithme composite qui utilise la majorité des décisions pour améliorer la précision.

- 🤖 Les réseaux neuronaux, y compris les réseaux profonds, sont utilisés pour simuler le fonctionnement du cerveau et l'apprentissage automatique.

Q & A

Qu'est-ce que la modélisation prédictive et pourquoi est-elle importante?

-La modélisation prédictive est une technique qui vise à prévoir la probabilité d'une mesure ou l'occurrence d'un événement en se basant sur des données historiques. Elle est importante car elle permet de prendre des décisions éclairées en anticipant les résultats possibles.

Quels sont les principes de base de la modélisation prédictive mentionnés dans le script?

-Les principes de base incluent la simplicité du modèle, la notion de distance entre observations pour la classification, et l'utilisation d'algèbre linéaire et de calcul matriciel pour faciliter ces mesures de distance.

Pourquoi est-il nécessaire de vectoriser l'espace et d'utiliser du calcul matriciel dans l'apprentissage automatique?

-Vectoriser l'espace et d'utiliser du calcul matriciel facilite les mesures de distance entre observations, en les transformant en vecteurs et en les manipulant via des matrices, ce qui est essentiel pour la comparaison et la classification.

Quels sont les défis associés à la création de modèles prédictifs qui ne deviennent pas obsolètes avec le temps?

-Les défis comprennent la nécessité d'adapter les modèles à un univers en constante évolution, et la gestion des corrélations qui peuvent changer, ce qui peut rendre les modèles obsolètes si ils ne sont pas régulièrement mis à jour.

Quel est le rôle de la validation croisée dans l'apprentissage automatique?

-La validation croisée permet de contrôler le risque de surapprentissage en testant le modèle sur différents échantillons aléatoires et en comparant les résultats pour confirmer la validité de la méthode de modélisation choisie.

Comment la régularisation contribue-t-elle à prévenir le surapprentissage?

-La régularisation pénalise volontairement la fonction de coût pour éviter qu'elle ne soit parfaite, ce qui permet de contrôler les calculs des paramètres du modèle et d'éviter ainsi le surapprentissage.

Quels sont les types de modèles mentionnés dans le script?

-Les types de modèles mentionnés sont les modèles supervisés, les modèles non supervisés, et les modèles d'apprentissage par renforcement.

Quels sont les principaux algorithmes utilisés dans les modèles de régression supervisée?

-Les principaux algorithmes incluent la régression linéaire, la régression logistique, et le support vector machine (SVM).

Quel est l'intérêt de l'utilisation de plusieurs algorithmes en même temps dans un ensemble?

-L'utilisation conjointe de plusieurs algorithmes dans un ensemble permet de prendre le résultat de la majorité, ce qui améliore la précision des prédictions et contribue à éviter les erreurs individuelles des algorithmes.

Comment la forêt aléatoire est-elle utilisée dans l'apprentissage automatique?

-La forêt aléatoire est une technique qui consiste à créer plusieurs arbres de décision de manière aléatoire et à prendre le résultat de la majorité pour améliorer la robustesse et la précision des prédictions.

Quel est le but de l'algorithme K-means dans les modèles non supervisés?

-Le but de l'algorithme K-means est de segmenter les données en plusieurs groupes (segments) homogènes en utilisant un calcul de distance moyenne et en optimisant la fonction de coût pour maximiser la séparation entre les groupes.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

04 Những kỹ năng mà một nhà khoa học dữ liệu cần là gì

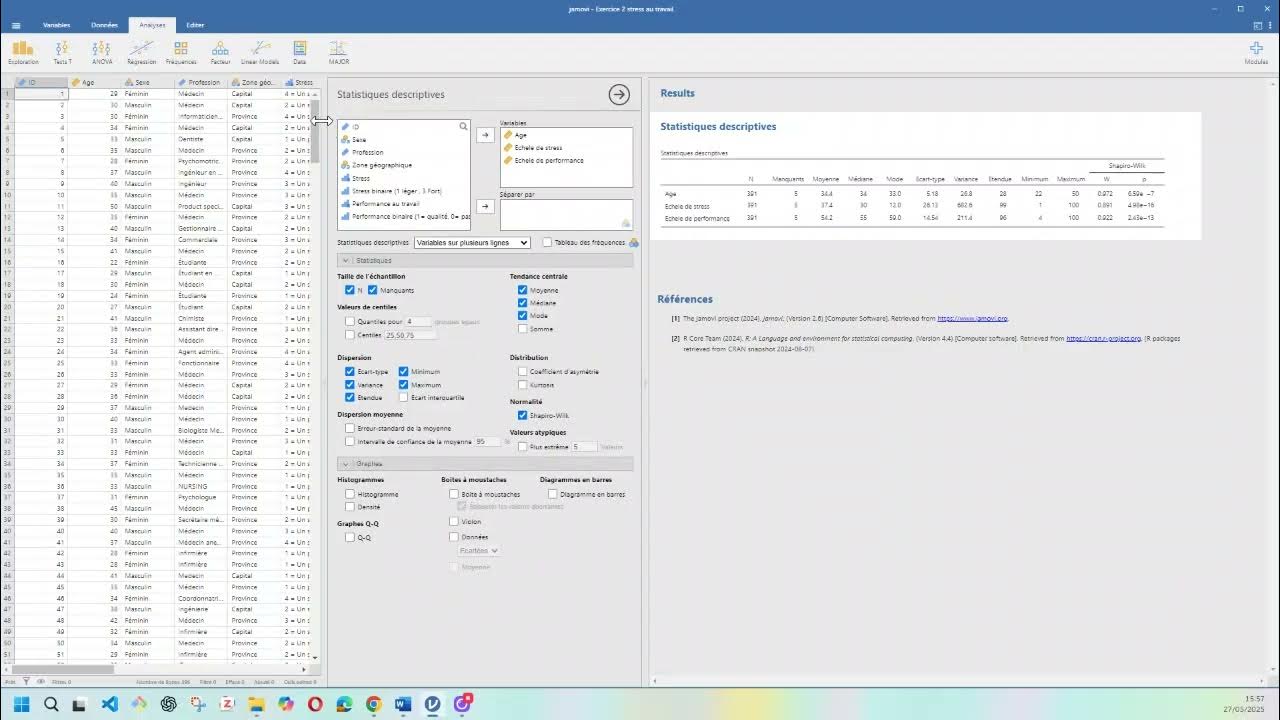

✅ Statistique descriptive : premier cours (notions de base)

Join Cut Intersect Fusion 360 Tutorial

Artificial Intelligence Strategy - The Machine Learning Value Chain

Learn NUMPY in 5 minutes - BEST Python Library!

Analyse descriptive des variables quantitatives

5.0 / 5 (0 votes)