Ein Agent der lernt | Die Welt der KI entdecken 02

Summary

TLDRDieses Video erklärt das Prinzip des maschinellen Lernens anhand von Beispielen wie Schach, Go und Mini-Schach. Es zeigt, wie Computerprogramme als 'Agenten' Umwelten wahrnehmen, Entscheidungen treffen und durch Belohnung und Bestrafung ihre Strategien verbessern. Durch das Hinzufügen von Schokolinsen als Belohnungen lernt ein Computer, Schachstrategien anzupassen. Das Video veranschaulicht, wie künstliche Intelligenz in Spielen und der Praxis Anwendung findet und wie es durch stärker gefördertes Lernen stetig optimiert wird.

Takeaways

- 🤖 Die künstliche Intelligenz hat in Spielen wie Schach und Go bedeutende Fortschritte gemacht, mit Deep Blue und AlphaGo als Beispiele für KI-Systeme, die weltbekannte Spieler geschlagen haben.

- 🎲 Das Mini-Schach-Spiel dient als vereinfachtes Beispiel, um zu demonstrieren, wie ein Computer durch das Lernen von Regeln und Strategien autonom spielen kann.

- 👑 Der Begriff 'Schachtürken' bezieht sich auf eine frühe Vorstellung von KI, bei der tatsächlich ein Mensch in einer Apparatur verborgen war und das Schachspiel führte, um die Idee einer intelligenten Maschine zu vermitteln.

- 📚 Maschinelles Lernen beinhaltet, dass ein Computerprogramm seine Umwelt wahrnimmt, Entscheidungen trifft und selbstständiges Verhalten zeigt, abhängig von den gegebenen Umständen.

- 🔄 Verstärktes Lernen verwendet Belohnungen und Bestrafungen, um die Effektivität von Aktionen zu verbessern und somit die Strategie des Computers oder Roboters zu optimieren.

- 🧩 Der Prozess des Lernens durch Belohnung und Bestrafung ähnelt dem menschlichen Lernprozess, bei dem durch Ausprobieren und Anpassung an die Ergebnisse gelernt wird.

- 🤹♂️ Verstärktes Lernen ermöglicht es Maschinen, komplexe Aufgaben zu erlernen, wie etwa die Bewältigung von Spielen, die anpassungsfähigere Verhaltensweisen erfordern als Schach.

- 🔧 Anwendungsbereiche von verstärktem Lernen umfassen nicht nur Spiele, sondern auch industrielle Anwendungen, wie zum Beispiel die Steuerung von Industrierobotern für präzise Aufgaben.

- 🌐 Verstärktes Lernen kann auch in Simulationsumgebungen eingesetzt werden, bevor Roboter oder Fahrzeuge mit der realen Welt interagieren, um zuvor Erfahrungen zu sammeln und zu lernen.

- 🔋 Ein Beispiel für die Anwendung von verstärktem Lernen ist die Optimierung von Energieverbrauch in Rechenzentren, wobei die Belohnung auf der Verbesserung der Energieeffizienz basiert.

- 🔢 Die Anwendung von verstärktem Lernen in der Praxis erfordert oft umfangreiche Datenmengen und erlaubt es, Probleme zu lösen, die für Menschen zu komplex sind, wie bei der Optimierung von Klimaanlagen oder Fahrplänen.

Q & A

Was war das Hauptthema des Videos?

-Das Hauptthema des Videos war das maschinelle Lernen und wie Maschinen durch Belohnung und Bestrafung lernen können, anhand von Beispielen wie Schach, Go und Mini-Schach.

Welche historische Ereignisse wurden im Video erwähnt, um Fortschritte in der künstlichen Intelligenz zu illustrieren?

-Im Video wurden die Niederlage von Garry Kasparow durch Deep Blue im Jahr 1996 und die Niederlage von Lee Sedol, einem der besten Golfspieler, durch AlphaGo im Jahr 2016 erwähnt.

Was ist der Unterschied zwischen dem Schach-Türken und einem modernen Computerprogramm für maschinelles Lernen?

-Der Schach-Türke war ein mechanisches Pferd, das von einem versteckten Menschen gesteuert wurde, während ein modernes Computerprogramm für maschinelles Lernen ein autonomes System ist, das durch Umweltbeobachtung und Aktionen lernen kann, ohne menschliche Intervention.

Wie wird das Verhalten eines Computers in Bezug auf das Lernen im Video beschrieben?

-Das Verhalten des Computers wird als selbstständiges und autonomes Verhalten beschrieben, das in der Lage ist, Strategien zu lernen und zu verbessern, basierend auf Belohnungen und Bestrafungen für bestimmte Aktionen.

Was ist das Ziel des Mini-Schach-Spiels im Video?

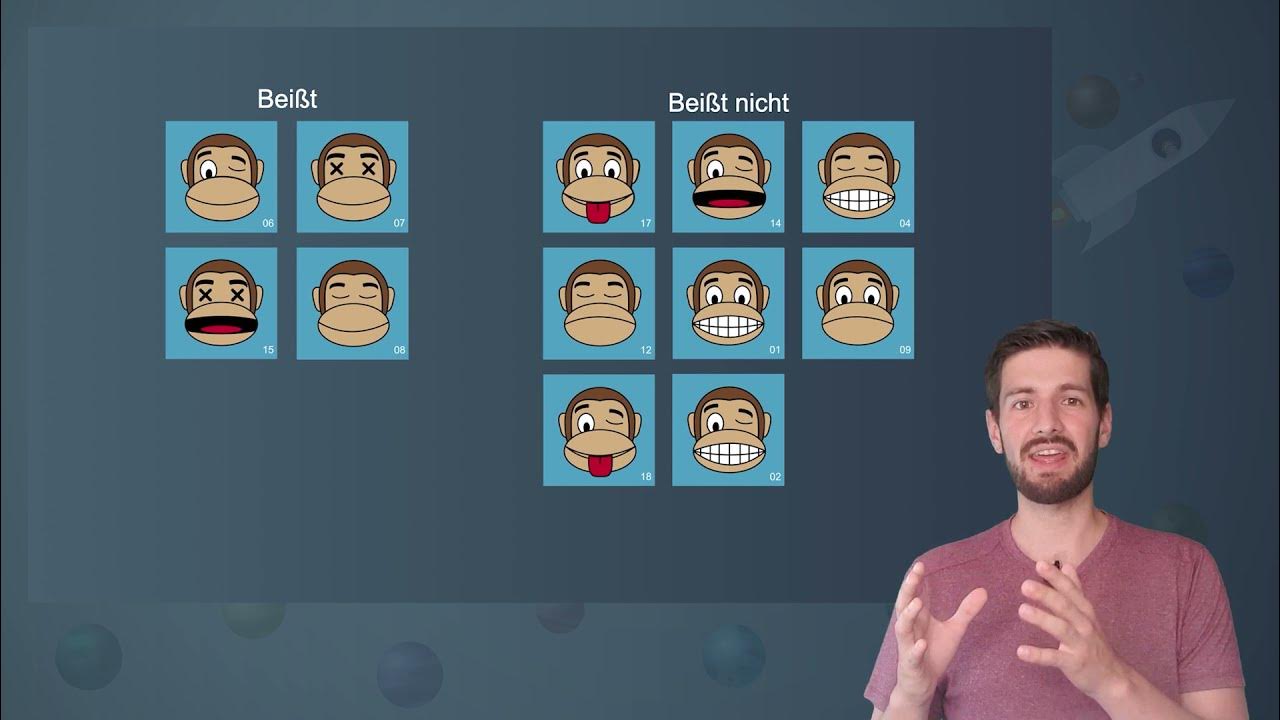

-Das Ziel des Mini-Schach-Spiels ist es, zu demonstrieren, wie ein Computer durch das Hinzufügen und Entfernen von Schokolinsen als Belohnungen und Bestrafungen Strategien für Spielzüge lernen kann.

Wie werden Belohnungen und Bestrafungen im Mini-Schach-Spiel verwendet?

-Belohnungen werden verwendet, indem Schokolinsen hinzugefügt werden, wenn der Computer eine gute Entscheidung trifft, während Bestrafungen durch das Entfernen von Schokolinsen erfolgen, wenn eine schlechte Entscheidung gemacht wird.

Welche Rolle spielen Exploration und Exploitation im Lernprozess des Computers?

-Exploration bedeutet, dass der Computer zufällige Aktionen ausprobiert, um zu sehen, welche Ergebnisse sie erzielen. Exploitation bedeutet, dass der Computer dann diejenigen Aktionen nutzt, die zuvor erfolgreich waren, um weiterhin erfolgreich zu sein.

Wie wird das Lernen durch Belohnung und Bestrafung im Video mit dem menschlichen Lernen verglichen?

-Das Lernen durch Belohnung und Bestrafung wird mit dem menschlichen Lernen verglichen, bei dem ein Kind durch Ausprobieren und Scheitern lernt und durch Bestrafung für gefährliches Verhalten oder Belohnung für erfolgreiches Verhalten seine Handlungen anpasst.

Welche Anwendungsbereiche für verstärktes Lernen werden im Video genannt?

-Im Video werden Anwendungsbereiche wie das Erlernen komplexer Spiele wie Go, kollaborative Spiele wie Starcraft 2, die Steuerung von Industrierobotern, Optimierungsaufgaben in Datenzentren und die Planung von Fahrplänen im öffentlichen Nahverkehr genannt.

Was ist ein Beispiel für ein reales Problem, bei dem verstärktes Lernen angewendet werden kann?

-Ein Beispiel für ein reales Problem, bei dem verstärktes Lernen angewendet werden kann, ist die Steuerung einer Klimaanlage in einem Rechenzentrum, um Energie zu sparen und die Effizienz zu verbessern.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

Klassische KI Verfahren und maschinelles Lernen | Die Welt der KI entdecken 04

Überwachtes Lernen | Die Welt der KI entdecken 05

Unüberwachtes Lernen | Die Welt der KI entdecken 07

Stapel und Schlange (Dynamische Datenstrukturen) - Programmieren mit Java

SYSTEMTHEORIE nach Luhmann - Autopoiesis, funktionale Differenzierung... einfach erklärt (2/2)

Interferenz

5.0 / 5 (0 votes)