「RAGは本当に必要か?」コンテキストウィンドウ拡大がRAGに与える影響とは(2024/3/20)

Summary

TLDRこのセミナーでは、検索拡張生成(Retrieving and Generating, 略してRAG)と呼ばれる手法と、それが持つ可能性について語り合われた。RAGは、AIが外部から情報を検索し、生成することで、より質の高い回答を提供する仕組みである。昨年末にジェミニやクロードなどの注目のモデルが発表され、RAGの必要性が議論されるようになった。RAGを用いたサービスは、企業での導入やタスクに特化した回答の向上に注目されており、長文のプロンプトを扱えるようになり、入力文字数の制限を解消する手段として期待されている。一方で、RAG不要論も根強いが、情報の精度やコスト面での利点から、RAGはまだ重要な手法とされており、今後の発展が期待されている。

Takeaways

- 📚 ラグ(Retrieval-Augmented Generation)は、外部の知識ベースから情報を検索し、生成することで、AIの回答質を向上させる手法です。

- 🔍 ラグの進化とコンテキストウィンドウの拡大は、AIが扱えるテキストの長さを増加させ、より長い文書を処理できるように進化しています。

- 🚀 GoogleのジェミニやAI2のクロードなど、最近のAIモデルは、非常に長いテキストを扱うことができる能力を獲得しています。

- 🤖 AIサービスのリリースが増えるにつれ、検索拡張生成ラグの必要性が議論されるようになりました。

- 💡 ラグの主な利点は、AIの回答質の向上、最新情報へのアクセス、ユーザーへの情報提供、そして再学習コストの削減にあります。

- 📈 入力文字数の増加により、ラグ不要論が登場しましたが、ラグはまだ重要な役割を果たしています。

- 🔗 ラグは検索と生成を組み合わせた手法で、ユーザーの質問に応じて最適な情報源を検索し、回答を生成します。

- 📉 長文の入力が増えると、AIの回答精度が下がる「抜け落ち問題」がありますが、ラグはこれを改善する手助けをしています。

- 💬 ラグの適用状況は、用途や目的によって異なり、サービス構築時や業務でAIを活用する際には効果的に利用できます。

- 📝 プロンプトの最適化とナレッジデータの整理は、チャットボットやAIサービスの精度向上に大きく寄与します。

- 💻 ラグを使用する際には、検索手法やデータの投入方法、プロンプトの作り方など、テクニックが必要とされます。

Q & A

セミナーのタイトルについて教えてください。

-セミナーのタイトルは「検索拡張生成ラグ:コンテキストウンドウの拡大がラグに与える影響」というものです。

ラグとは何ですか?

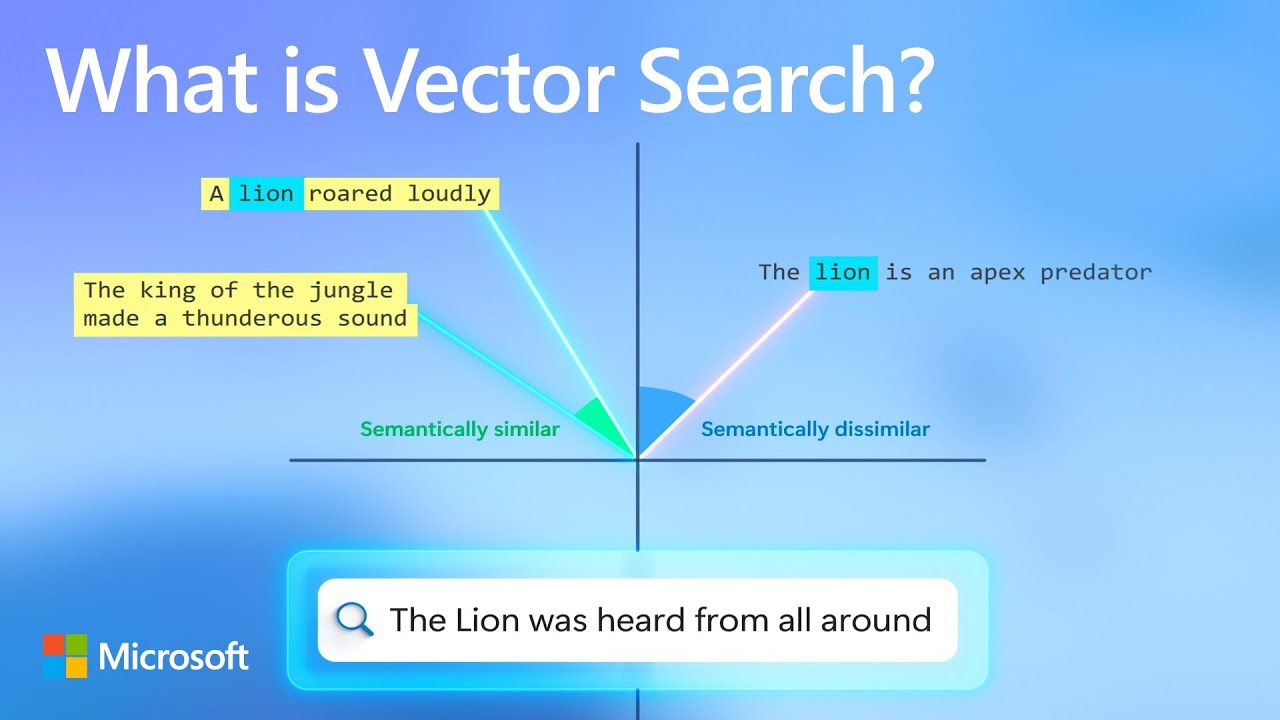

-ラグとは、レトリーバオグメテッドジェネレーションの頭文字をとって名付けられたもので、外部の知識ベースから情報を検索し、それを生成するという仕組みを指します。

ラグの進化について説明してください。

-ラグは、検索と生成を組み合わせた新しいAIのフレームワークであり、外部から情報を得ることができるため、LLM(Large Language Model)の回答の質を向上させることができます。

ラグの利用における主な利点は何ですか?

-ラグの利用により、LLMの回答の質が向上し、常に新しい情報を追加できるだけでなく、学習されていない範囲外のデータも回答に組み込むことができるという利点があります。

最近のLLMの進化の中で、入力文字数の制限がどのように変わってきましたか?

-最近のLLMの進化の中で、入力文字数の制限が緩和されており、GPT4のターボモデルでは最大12万8000文字、Googleのジェミニ1.5プロでは最大100万文字までの対応が可能となっています。

ラグ不要論とは何ですか?

-ラグ不要論とは、入力文字数の上限が拡大されることで、ラグを用いて情報を切り取って与える必要がなくなるという意見であり、その逆にラグを活用することで精度を向上させることができるとの議論があります。

検索拡張生成ラグが注目されるようになった理由は何ですか?

-検索拡張生成ラグが注目されるようになった理由は、昨年頃から注目された背景に、長文のプロンプトが入れられるようになり、ラグの必要性が少し下がっているとの見方があるからです。

AIのウェビナー支援で使われている生成AIのサービスとは何ですか?

-AIのウェビナー支援で使われている生成AIのサービスは、メディアリンクという会社の製品で、ラグを用いたサービスを提供しています。

ジェミニやクロードなどの他のサービスが提供する機能と比べて、ラグの特性とは何ですか?

-ラグの特性は、外部から適切な情報を与えることができるという点で、ジェミニやクロードなどの他のサービスとは異なります。これにより、最新の情報を常に追加し、学習されていない範囲外のデータも回答に組み込むことができます。

セミナーで話される内容の流れについて教えてください。

-セミナーの流れは、セミナーの目的と流れの紹介から始まり、ラグとは何かという基本的な概念の説明に移ります。その後、ラグの進化とコンテキストウィンドウの拡大について議論し、最後に質疑応答を行う予定です。

検索拡張生成ラグが注目されるようになった時期はいつですか?

-検索拡張生成ラグが注目されるようになったのは昨年頃からで、特に昨年末のジェミニの発表以来です。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

How vector search and semantic ranking improve your GPT prompts

AIの能力拡大とAgentモデル – RAG

RAG Evaluation (Document Relevance) | LangSmith Evaluations - Part 14

Demagnetize your cassette/tape recorders for optimal sound

自己投資のレイヤーを上げて、心を開き自分らしく生きる方法。他、自覚度雑談。in葉山

Perplexity CEO on New Advisory Board, Future of Search

5.0 / 5 (0 votes)