Import, Train, and Optimize ONNX Models with NVIDIA TAO Toolkit

Summary

TLDRDieses Video führt durch die Schritte der Modellfinetuning mit dem Open-Source-Onyx-Modell. Es beginnt mit dem Herunterladen des ResNet18-Modells, das auf dem ImageNet-Datensatz trainiert wurde. Anschließend wird das Modell mit NVIDIA TAO und dem neuen BYOM-Skript in ONNX konvertiert und visualisiert. Im dritten Schritt wird das Modell in TAO importiert und trainiert, wobei auf das Anpassen des letzten Aktivierungsschichtennamens geachtet wird. Im vierten Schritt wird das Modell mit dem Pascal VOC-Datensatz trainiert und mit TensorBoard überwacht. Schließlich wird die Genauigkeit des Modells auf dem Testdatensatz analysiert und die Möglichkeit zur Modelloptimierung und -reduktion diskutiert.

Takeaways

- 🌐 **Open-Source-Modell**: Es wird ein wichtiges Open-Source-Modell namens Onyx eingesetzt.

- 🔍 **Computer Vision**: Der Fokus liegt auf der Verwendung eines Computer Vision-Modells für die Klassifizierung.

- 📈 **ResNet18-Modell**: Ein vortrainiertes ResNet18-Modell wird heruntergeladen, das auf dem ImageNet-Datensatz trainiert wurde.

- 🔄 **Transfer Learning**: Das vortrainierte Modell ermöglicht schnelleres Konvergenz und höhere Genauigkeit durch Transfer Learning.

- 🛠️ **Jupyter Notebook**: Jupyter Notebook wird verwendet, um die erforderlichen Schritte auszuführen.

- 💾 **Software-Installation**: Es werden NVIDIA TAU und das NVIDIA TensorFlow-Paket installiert, um das Modell umzuwandeln und zu importieren.

- 📊 **ONNX-Graph**: Der ONNX-Graph wird visualisiert, um die Aktivierungsschicht zu identifizieren und den Import bis zu dieser Schicht zu begrenzen.

- 🔗 **TAU BYOM**: Das TAU BYOM-Skript wird verwendet, um das ONNX-Modell in TAU zu importieren.

- 📚 **PASCAL VOC-Datensatz**: Der PASCAL VOC-Datensatz wird verwendet, um das Modell zu trainieren, der etwa 15.000 Bilder in 20 Klassen umfasst.

- 📊 **TensorBoard**: TensorBoard wird verwendet, um den Trainings- und Validierungsfortschritt zu überwachen.

- 🔧 **Modell-Optimierung**: Nach dem Training kann das Modell weiterhin optimiert und auf Genauigkeit verbessert werden.

Q & A

Was ist das Ziel des in der Transkript erwähnten Projekts?

-Das Ziel ist es, ein offenes Quellmodell namens Onyx zu verwenden, um einen vortrainierten Computer Vision-Modell für die Klassifizierung zu fine-tunen.

Welches Modell wird für die Klassifizierung verwendet?

-Ein ResNet18-Modell wird verwendet, das auf dem ImageNet-Datensatz trainiert wurde, der über eine Million Bilder von 1000 verschiedenen Klassen enthält.

Warum ist das ResNet18-Modell für Transferlearning geeignet?

-Das ResNet18-Modell ist aufgrund seiner Ausbildung an einem umfangreichen Datensatz von Bildern ideal für Transferlearning, was zu einer schnelleren Konvergenz und höherer Genauigkeit führt.

Welche Tools werden zur Installation der erforderlichen Abhängigkeiten genutzt?

-Die Tools sind NVIDIA TAU für Training und Optimierung, das NVIDIA Tensorflow-Paket für Modellkonvertierung und das TAO byom-Paket für die Importierung des Modells in TAO.

Was ist der Zweck des Onyx-Graphen-Visualisierers?

-Der Onyx-Graphen-Visualisierer dient dazu, den Graphen zu visualisieren und die Aktivierungs-Node auszuwählen, um nur bis zur letzten Aktivierungsschicht zu importieren, da die letzten Schichten in unserem Modell anders sein werden.

Wie wird der Name der letzten Aktivierungsschicht im Onyx-Graphen verwendet?

-Der Name der letzten Aktivierungsschicht wird verwendet, um die Modellinhalteinheit zu identifizieren, die während des Imports in TAO angepasst werden muss.

Was passiert, wenn das Modell nicht erfolgreich in TAO konvertiert werden kann?

-Wenn das Modell nicht konvertiert werden kann, können benutzerdefinierte Schichten mit dem '-c'-Flag in TAO byom hinzugefügt werden, um die Konvertierung zu ermöglichen.

Welche Datenmenge wird für das Training des Modells verwendet?

-Für das Training wird das PASCAL VOC-Datensatz verwendet, der 20 Klassen mit etwa 15.000 Bildern repräsentiert.

Wie wird der Trainingsprozess überwacht?

-Der Trainingsprozess wird mit Tensorboard visualisiert, wobei man die Genauigkeit, den Verlust und die Validierungsverlust beobachten kann, um zu überprüfen, ob das Modell überanpasst wird.

Was bedeuten die Histogramme der Modellgewichte und -biases?

-Die Histogramme der Modellgewichte und -biases zeigen die Verteilung der Werte. Idealerweise sollten sie um Null zentriert sein, was auf eine gute Initialisierung der Parameter hinweist.

Wie kann die Genauigkeit des Modells nach dem Training beurteilt werden?

-Die Genauigkeit des Modells nach dem Training kann durch die Beurteilung der Testdatensatz-Akkuranz beurteilt werden, wobei auch die Leistung auf Unterklassen und andere Klassen betrachtet wird.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

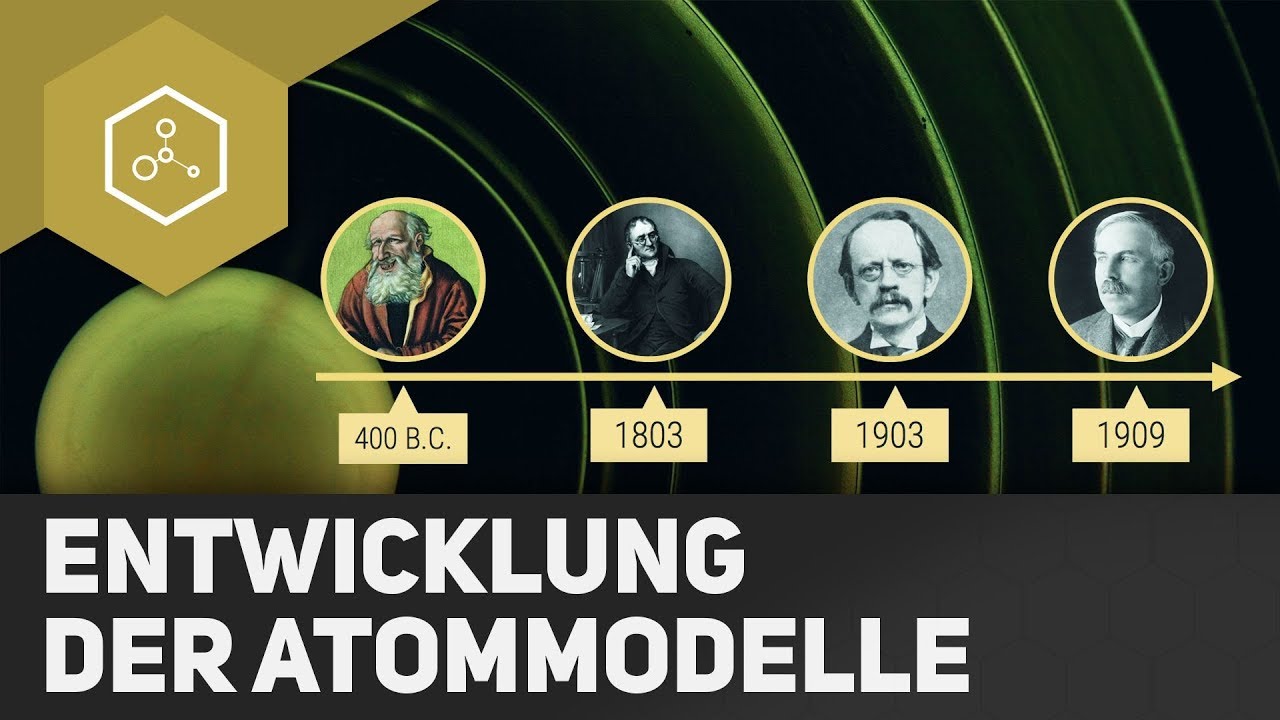

Welche Atommodelle gibt es?! - Teil 1

ACTIONS FÜR CUSTOM GPTS - Das umfassende Tutorial für Dein eigenes ChatGPT, das ALLES kann!

Wie schreibe ich eine Sachtextanalyse? Wie analysiere ich einen Sachtext? - Textanalyse

Hoi4 By Blood Alone: True Blitzkrieg Guide to Dominating the Allies and Poland Before 1939!

Entwicklung der Atommodelle - REMAKE

Škoda ENYAQ iV / VW ID4 / MEB Batterie Produktion in Mlada Boleslav, exklusive Einblicke und Infos

5.0 / 5 (0 votes)