【生成式AI導論 2024】第6講:大型語言模型修練史 — 第一階段: 自我學習,累積實力 (熟悉機器學習的同學從 15:00 開始看起即可)

Summary

TLDR本课程至今为止没有训练任何模型,所有内容基于已训练好的大型语言模型。从这堂课开始,将讲解大型语言模型的训练史,分为三个阶段。在进入语言模型训练前,需了解背景知识,包括文字接龙和Token的概念。机器学习的训练分为训练和推论两个步骤,训练找到模型参数,推论使用这些参数。训练过程中可能遇到超参调试和过拟合问题,需要增加训练数据的多样性和控制初始参数。第一阶段自我学习,从网络爬取大量文字资料进行训练。

Takeaways

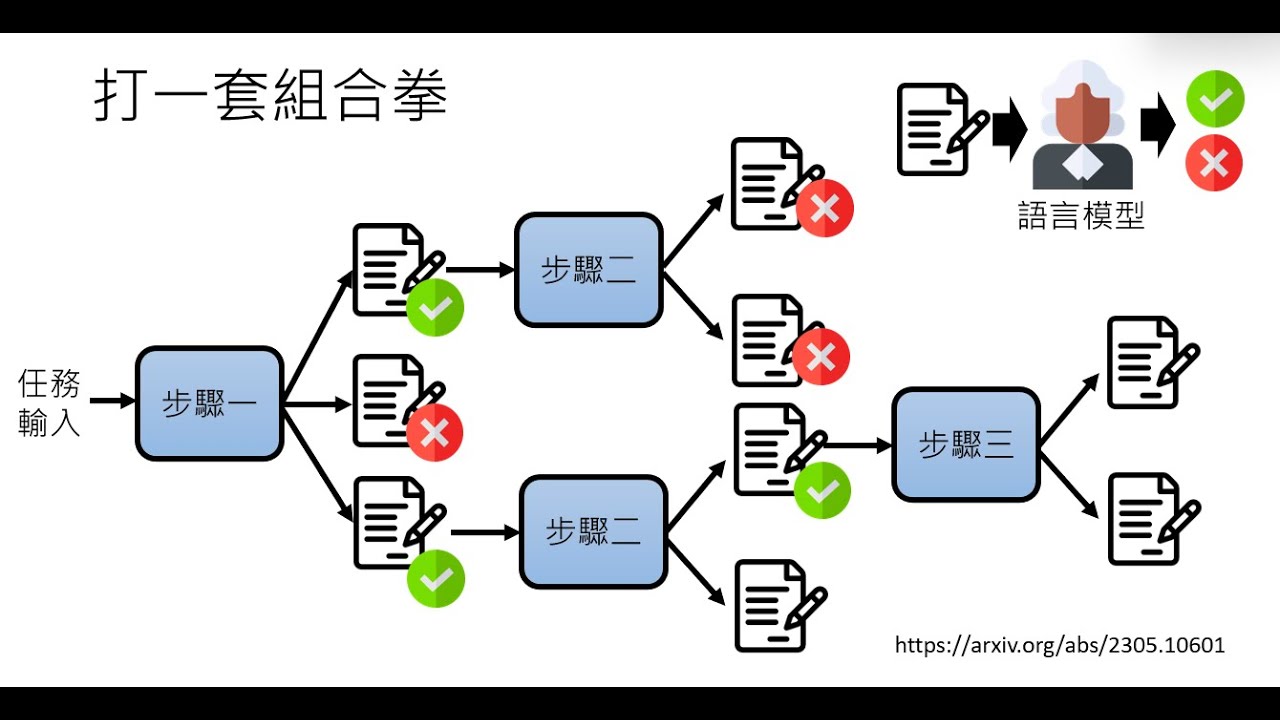

- 📚 大型语言模型的训练分为三个阶段,每个阶段都专注于学习如何更好地进行文字接龙。

- 🔍 语言模型的训练基于大量数据,通过机器学习和深度学习技术来预测文本序列中的下一个Token。

- 🤖 模型的参数是通过训练数据自动找出的,而超参数需要人工设定,这些超参数对训练结果有重要影响。

- 🔄 训练过程中可能遇到的问题包括训练失败或过拟合,需要通过调整超参数或增加数据多样性来解决。

- 🌐 网络是获取训练数据的主要来源,但需要对数据进行清理,包括去除有害内容、HTML符号、低品质数据和重复内容。

- 📈 GPT系列模型的发展显示了模型大小与回答正确率的关系,但即使是大型模型,正确率提升也有限。

- 🔑 Prompt的设计对于语言模型的输出至关重要,尤其是在早期的GPT-3模型中,需要精确的提示来获得有用的回答。

- 🚀 即使模型参数量巨大,如果没有适当的指导,模型可能无法有效地使用其学到的知识,需要人类进一步的引导。

- 🛠️ 训练语言模型不仅是技术问题,还涉及到数据的法律和伦理问题,如数据授权和版权问题。

- 📝 语言模型的训练和应用是一个不断发展的领域,需要不断地技术迭代和创新来提升模型的性能和实用性。

Q & A

什么是大型语言模型的'修煉史'?

-大型语言模型的'修煉史'指的是这些模型从最初的设计到逐渐增强能力的过程。这个过程包括了三个阶段的训练,每个阶段使用不同的训练数据,但核心目标都是学习如何更好地进行'文字接龙'。

为什么大型语言模型的训练可以看作是'文字接龙'?

-大型语言模型的训练可以看作是'文字接龙',因为模型的任务就是基于给定的文本序列预测下一个可能出现的词或字符,即生成文本中的下一个'Token'。

在大型语言模型中,'Token'是什么?

-在大型语言模型中,'Token'是构成文本的基本单位,可以是一个字、一个词或字符等。在本课程中,为了简化说明,假设一个中文字就是一个Token。

为什么需要训练数据来训练语言模型?

-训练数据用于告诉模型在给定一个未完成的句子时,哪个Token是正确的接续。通过大量的训练数据,机器学习算法能够自动找出模型中的数十亿个参数,以完成文字接龙任务。

什么是'超参数'(Hyperparameter),在训练语言模型中扮演什么角色?

-超参数是机器学习中用于设定学习过程的参数,如学习率、批次大小等。在训练语言模型时,超参数决定了优化算法的行为,影响模型训练的结果。选择合适的超参数对于模型性能至关重要。

为什么训练语言模型有时会失败?

-训练语言模型有时会失败,可能是因为选择的超参数不合适,或者训练数据不够多样化,导致模型无法准确学习到数据中的模式。此外,训练过程本身具有随机性,有时可能需要多次尝试不同的超参数组合才能获得满意的结果。

什么是'过拟合'(overfitting),在语言模型训练中如何表现?

-过拟合是指模型在训练数据上表现很好,但在未见过的数据上表现差的现象。在语言模型训练中,过拟合可能表现为模型能够完美地生成训练数据中的句子,但对于新的、不同的文本则生成不合理的续句。

为什么需要从网络爬取大量文本数据来训练语言模型?

-网络提供了几乎无限的文本资源,这些文本数据可以用于生成大量的训练样本,帮助语言模型学习广泛的语言模式和知识。自监督学习(Self-supervised learning)就是利用这些数据,让模型通过自我训练来提高能力。

为什么训练语言模型时需要考虑数据的多样性和质量?

-数据的多样性和质量直接影响模型学习的广度和深度。多样化的数据可以帮助模型学习到更广泛的语言用法和知识,而高质量的数据可以确保模型学习到正确的信息,避免学习到错误或无关的内容。

GPT模型的发展经历了哪些阶段,每个阶段的特点是什么?

-GPT模型从GPT-1开始,经历了GPT-2和GPT-3等阶段。GPT-1参数较少,使用的文本数据量有限,没有引起太大关注。GPT-2参数量大幅增加,但性能提升有限。GPT-3参数量达到1750亿,使用的数据量极大,但仍然存在可控性和准确性的问题。

为什么GPT-3模型即使拥有巨大的参数量,也无法总是准确回答问题?

-GPT-3模型虽然参数量巨大,但它的学习完全基于网络数据,没有针对性地学习如何回答问题。它可能知道很多信息,但缺乏将这些信息有效组织成答案的能力,需要通过精心设计的提示(Prompt)来引导它生成准确的回答。

Outlines

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифMindmap

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифKeywords

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифHighlights

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифTranscripts

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тариф5.0 / 5 (0 votes)