Validate & Standardize LLM Output with Guardrails-AI

Summary

TLDREl video explica cómo validar y corregir la salida de modelos de lenguaje grande (LLM) para garantizar que sigan un formato predefinido. Utilizando herramientas como Guardrails AI, el proceso valida los resultados de los LLM mediante un esquema específico. Si el formato no es correcto, se solicita una nueva generación hasta que cumpla con los requisitos. El tutorial incluye ejemplos de cómo implementar esta técnica en Python, utilizando VS Code y OpenAI, para estandarizar información compleja como las notas de un doctor, asegurando resultados consistentes y válidos.

Takeaways

- 😀 Trupan presenta un tema sobre la validación de salida de modelos de lenguaje grande (LLM).

- 🧑💻 A menudo, los modelos LLM generan salidas con formatos inconsistentes, lo que hace difícil su control.

- 📋 El objetivo es validar la salida del LLM utilizando un esquema predefinido, garantizando consistencia.

- 🛠️ Guardrails AI es una herramienta que ayuda a validar las salidas del LLM de acuerdo a estos esquemas.

- 🔁 Si la salida no cumple con el esquema, Guardrails AI puede solicitar una nueva generación hasta que sea válida.

- 📦 Se hace referencia a dos artículos: uno en Medium y otro en la documentación de Guardrails AI.

- 🐍 Se utiliza el lenguaje Python, junto con OpenAI API y módulos como Pydantic, para definir esquemas de validación.

- 💊 El ejemplo muestra la validación de una nota médica, donde se estructuran datos como síntomas y medicamentos.

- 🎯 Validadores como 'valid choices' y 'valid range' se usan para asegurar que la salida del LLM sea coherente.

- ✅ Al final, se valida correctamente una salida en formato JSON basada en una nota médica, siguiendo las reglas predefinidas.

Q & A

¿Qué problema principal se aborda en este video?

-El problema principal es la inconsistencia en los formatos de salida generados por los modelos de lenguaje grande (LLM). A veces, el formato de salida varía entre ejecuciones, lo que dificulta la conversión automática a un formato específico.

¿Qué solución se presenta para validar las salidas de los LLM?

-La solución presentada es el uso de Guardrails AI, que valida y corrige la salida de los LLM basándose en un esquema predefinido. Si la salida no cumple con el esquema, el modelo se vuelve a ejecutar hasta que cumpla con los requisitos de validación.

¿Cómo implementa Guardrails AI la validación de salidas?

-Guardrails AI hace una llamada al modelo LLM, valida la salida basada en un esquema predefinido, y si no es válida, solicita al LLM que regenere la salida. Este proceso se repite hasta que la salida sea conforme con el esquema.

¿Qué lenguaje de programación y herramientas se utilizan en el tutorial?

-El tutorial utiliza Python, la API de OpenAI para interactuar con el modelo GPT-4, y Guardrails AI para la validación de salidas. Además, se usa Pydantic para definir el esquema y tipos de datos.

¿Qué es Pydantic y cómo se usa en este contexto?

-Pydantic es una biblioteca de Python que permite definir tipos de datos estáticos en un lenguaje dinámico como Python. En este contexto, se usa para definir un esquema que debe seguir la salida del LLM, asegurando que la información esté en un formato predefinido.

¿Qué validadores específicos se mencionan para asegurar la consistencia de los datos?

-Se mencionan los validadores 'valid_range' y 'valid_choices', que aseguran que las variables cumplan con un rango numérico (por ejemplo, para la edad) o que se elijan de una lista de opciones predefinidas.

¿Qué estructura sigue el esquema de datos creado en el tutorial?

-El esquema creado incluye varias clases: una para los síntomas ('Symptoms'), otra para la medicación actual ('CurrentMeds'), y una clase general llamada 'PatientInformation' que agrupa información como el género, la edad, los síntomas y la medicación actual.

¿Qué modelo de lenguaje se utiliza en el tutorial y por qué se selecciona?

-Se utiliza el modelo GPT-4 en lugar de GPT-3.5 Turbo debido a la complejidad de la tarea, ya que el modelo GPT-4 proporciona resultados más precisos al manejar notas médicas complejas.

¿Cómo se asegura que la salida del LLM esté en formato JSON?

-El tutorial usa un decorador para asegurar que la salida del LLM esté en formato JSON, lo que facilita su validación y manipulación posterior.

¿Qué resultados se obtienen al final del tutorial?

-Al final, se obtiene un archivo JSON validado que extrae correctamente información del paciente, como edad, género, síntomas y medicación, mostrando que el esquema y las validaciones implementadas funcionan correctamente.

Outlines

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифMindmap

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифKeywords

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифHighlights

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифTranscripts

Этот раздел доступен только подписчикам платных тарифов. Пожалуйста, перейдите на платный тариф для доступа.

Перейти на платный тарифПосмотреть больше похожих видео

Capítulo 1 Clase 5: Domina y crea con prompts - Parte 1

Patricio López-Pismante - Modelos de Lenguaje Grande (LLM) y Epistemología (2024)

Building a RAG application using open-source models (Asking questions from a PDF using Llama2)

¿Qué son las BASES DE DATOS VECTORIALES? | Grandes Modelos de Lenguaje

Usa tus modelos de Tensorflow en páginas web | Exportación a Tensorflow.js

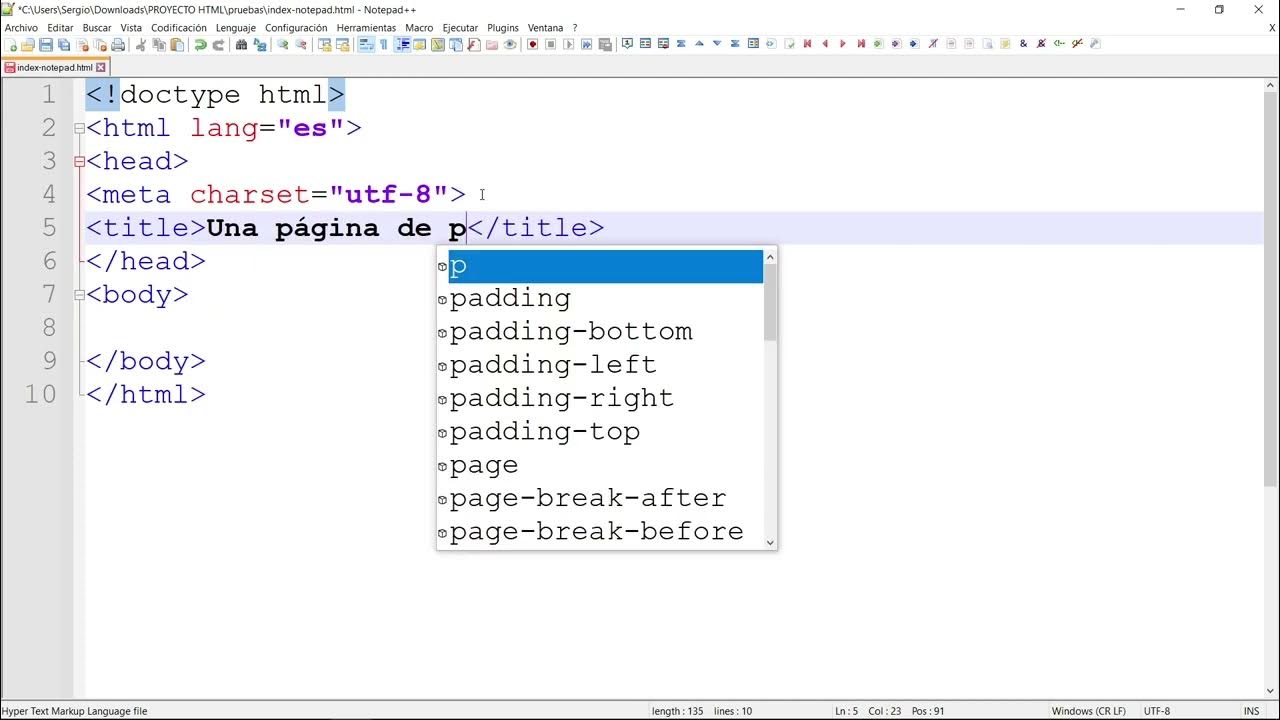

Primeros pasos con Notepad++

5.0 / 5 (0 votes)