【生成式AI導論 2024】第10講:今日的語言模型是如何做文字接龍的 — 淺談Transformer (已經熟悉 Transformer 的同學可略過本講)

Summary

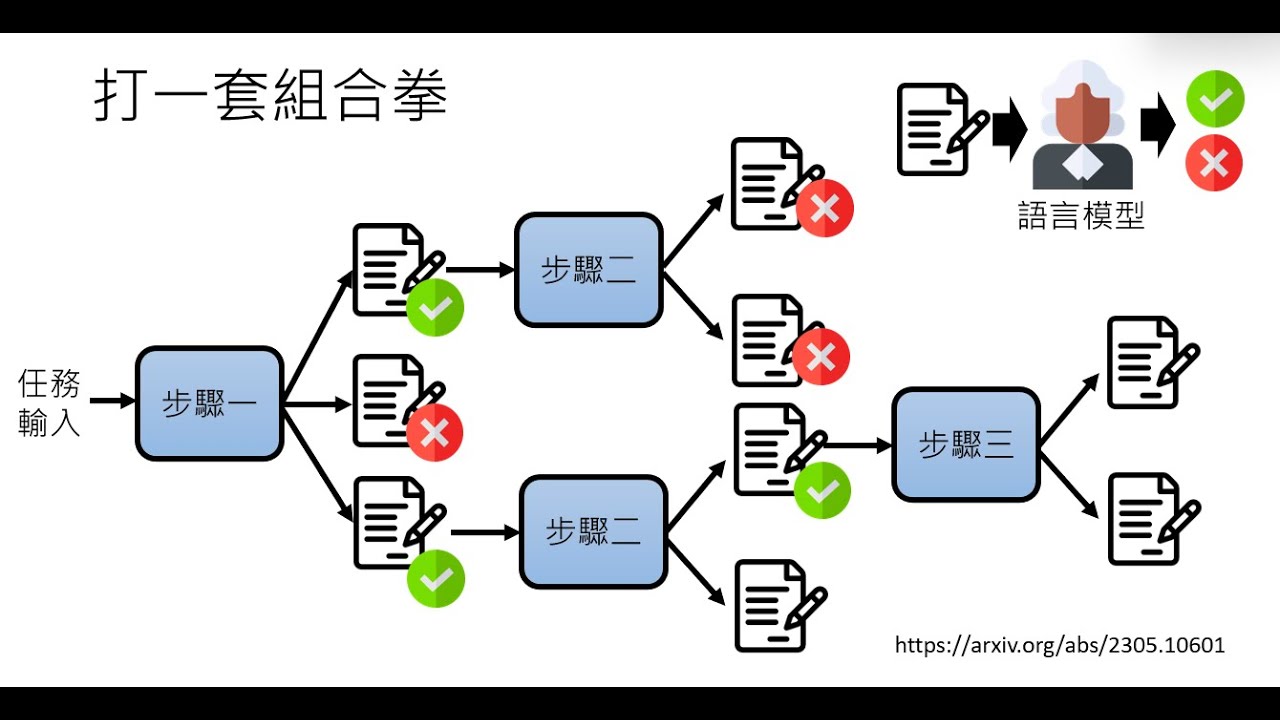

TLDR本课程深入探讨了语言模型的核心——Transformer模型。首先介绍了语言模型的基础,即通过大量训练数据学习文字接龙的能力。然后,详细解释了Transformer模型的运作过程,包括Tokenization、Embedding、Attention机制以及Feedforward Network。特别强调了Attention机制的重要性,它通过计算Token间的相关性来考虑上下文信息,生成Contextualized Embedding。课程还讨论了提高Attention计算效率、处理超长文本的方法,以及未来可能取代Transformer的新模型研究方向,如Memba系列和JAMBAR模型。

Takeaways

- 📚 课程分为两部分,前半部分深入探讨语言模型内部结构,特别是Transformer模型;后半部分讨论大型语言模型的内部机制。

- 🌟 Transformer模型是当前语言模型中最常用的类神经网络结构,对大型语言模型至关重要。

- 🔍 语言模型的核心任务是进行文字接龙,通过大量训练数据学习形成。

- 📈 语言模型的演变经历了从N-Gram模型到Feed Forward Network,再到Recurrent Neural Network的过程。

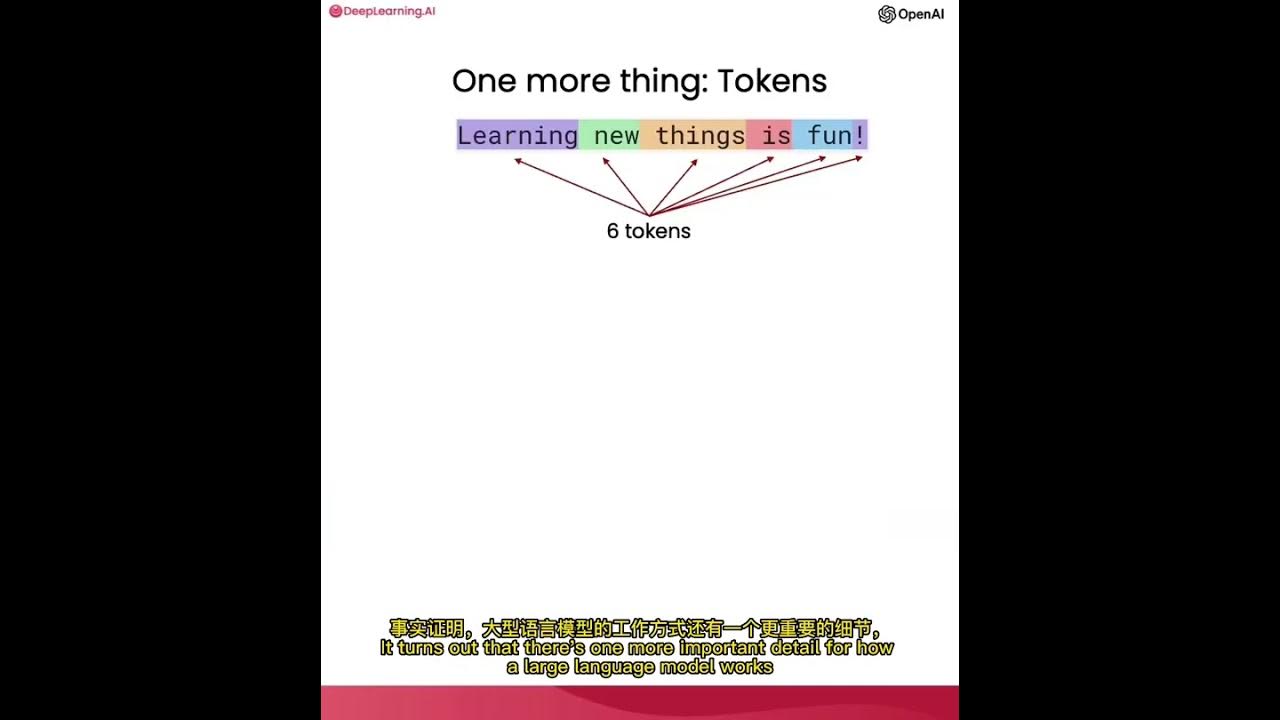

- 🔑 Tokenization是语言模型处理文本的第一步,将文字转换为模型能理解的Token序列。

- 📝 Token是语言模型的基本处理单位,不同语言模型可能有不同的Token列表,可以通过算法如Byte Pair Encoding (BPE) 自动获得。

- 📊 Embedding是将Token转换为向量的过程,使得语义相近的Token在向量空间中距离更近。

- 🔄 Attention模块用于理解Token之间的关系和上下文,通过计算Token间的相关性来调整Embedding。

- 🎯 Multi-Head Attention允许从不同角度考虑Token间的相关性,通过多个头并行处理来丰富模型的理解。

- 🛠️ Transformer Block由Attention和Feed Forward Network组成,是Transformer模型的基本单元,可以多次迭代以深化理解。

- ⏱️ 处理超长文本是语言模型面临的挑战,因为Attention的计算量与文本长度的平方成正比,需要大量算力。

Q & A

什么是Transformer模型?

-Transformer模型是一种类神经网络结构,广泛应用于语言模型中。它通过注意力机制(Attention)和前馈神经网络(Feedforward Network)处理序列数据,能够捕捉长距离依赖关系,是大型语言模型的核心组件。

为什么Transformer模型在语言模型中非常重要?

-Transformer模型之所以重要,是因为它能够高效地处理语言数据,支持并行计算,并且可以很好地捕捉文本中的长距离依赖关系。这使得基于Transformer的语言模型在生成文本、翻译、问答等任务上表现出色。

Tokenization是什么?它在语言模型中扮演什么角色?

-Tokenization是将文本转换为Token的过程。在语言模型中,Token是模型处理的基本单位。Tokenization的目的是将句子分解成模型可以理解和处理的Token序列,为后续的Embedding和模型训练打下基础。

什么是Embedding?它如何帮助语言模型理解Token?

-Embedding是将Token转换为向量表示的过程。通过Embedding,每个Token被转换成一串数字,这些数字能够捕捉Token的语义信息。语义相近的Token会有相似的Embedding,这有助于模型在处理时理解Token之间的关系。

Attention机制在Transformer中的作用是什么?

-Attention机制使Transformer能够关注输入序列中与当前处理的Token最相关的部分。它通过计算Token之间的关系权重,生成Contextualized Embedding,从而让模型能够根据上下文信息调整Token的表示。

为什么在语言模型中,Attention只考虑前面的Token?

-在语言模型中,Attention只考虑前面的Token是因为语言模型在生成文本时是自回归的。这意味着每个新的Token都是基于之前Token序列生成的,因此只需要考虑已生成的Token,而不需要考虑未来的Token。

什么是Multi-Head Attention?它有什么优势?

-Multi-Head Attention是Transformer中的一个概念,它允许模型同时从不同的角度和表征子空间捕捉信息。这种机制可以提供更丰富的上下文信息,帮助模型更好地理解复杂的语言现象。

Transformer Block中的Feedforward Network有什么作用?

-Feedforward Network是Transformer Block中的一个组成部分,它对Attention模块的输出进行进一步的处理。它通过非线性变换整合信息,帮助模型学习更复杂的特征表示。

什么是Positional Embedding?它如何帮助模型理解Token的位置信息?

-Positional Embedding是向量形式的位置信息,它被添加到Token Embedding中,以提供模型关于Token在序列中位置的感知。这有助于模型理解句子结构和语序,因为同一Token在不同位置可能有不同的含义。

为什么处理超长文本对语言模型是一个挑战?

-处理超长文本是一个挑战,因为Attention机制的计算量与输入文本长度的平方成正比。这意味着随着文本长度的增加,所需的计算资源和时间会急剧增加,对硬件性能提出了更高的要求。

什么是'train short test long'?它在语言模型训练中的意义是什么?

-“train short test long”是指在训练语言模型时使用较短的文本,而在测试时使模型能够处理和理解较长的文本。这种方法的意义在于,即使模型只在训练阶段见过短文本,它也能够在测试阶段表现出对长文本的理解能力。

有哪些研究方向旨在改进Transformer模型或探索其替代品?

-改进Transformer模型或探索其替代品的研究方向包括但不限于:加快Attention计算的方法、实现无限长度的Attention、探索'train short test long'的技术,以及Memba系列和JAMBAR模型等新型神经网络架构的研究。

Outlines

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantMindmap

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantKeywords

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantHighlights

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantTranscripts

Cette section est réservée aux utilisateurs payants. Améliorez votre compte pour accéder à cette section.

Améliorer maintenantVoir Plus de Vidéos Connexes

使用ChatGPT API构建系统1——大语言模型、API格式和Token

Stream of Search (SoS): Learning to Search in Language

【生成式AI導論 2024】第4講:訓練不了人工智慧?你可以訓練你自己 (中) — 拆解問題與使用工具

A little guide to building Large Language Models in 2024

Augmentation of Data Governance with ChatGPT and Large LLMs

【生成式AI導論 2024】第6講:大型語言模型修練史 — 第一階段: 自我學習,累積實力 (熟悉機器學習的同學從 15:00 開始看起即可)

5.0 / 5 (0 votes)