Building Production-Ready RAG Applications: Jerry Liu

Summary

TLDRThe speaker discusses building production-ready large language models for tasks like search, QA, automation, and document processing. They overview retrieval-augmented generation, data ingestion and querying. They then detail key challenges with naive RAG like poor response quality, and potential solutions around optimizing data, embeddings, retrieval algorithms and synthesis. The speaker concludes by covering more advanced techniques like small-to-big retrieval, multi-document agents, and fine-tuning.

Takeaways

- 🔍 Es gibt zwei Hauptparadigmen, um Sprachmodelle Daten verstehen zu lassen: Retrieval-Augmentation und Feinabstimmung.

- 🤖 RAG (Retrieval Augmented Generation) ist ein aktuelles Konzept für den Aufbau von QA-Systemen, das Datenbeschaffung und Datenabfrage umfasst.

- 🚀 Für den Einstieg in Llama Index können Entwickler mit etwa fünf Zeilen Code beginnen, aber ein tieferes Verständnis der Komponenten wird empfohlen.

- 🛠 Die Herausforderungen bei der Nutzung von naivem RAG umfassen schlechte Antwortqualität aufgrund von Problemen wie schlechter Datenabruf und veralteter Informationen.

- 💡 Zur Optimierung der Leistung von RAG-Anwendungen kann man an verschiedenen Stellen ansetzen: Datenoptimierung, Verbesserung der Einbettungsrepräsentation und des Abrufalgorithmus.

- 🔬 Die Evaluation von RAG-Systemen ist entscheidend und umfasst die Bewertung sowohl der End-to-End-Lösung als auch spezifischer Komponenten wie Datenabruf.

- 📐 Die Anpassung der Chunk-Größen und die Nutzung von Metadatenfiltern sind grundlegende Techniken zur Verbesserung der RAG-Leistung.

- 📊 Fortgeschrittene Abrufmethoden und die Verwendung von Agents können weiter zur Steigerung der Effizienz und Leistungsfähigkeit von RAG beitragen.

- 🛁 Feinabstimmung und die Entwicklung spezifischer Adapter oder Modelle ermöglichen eine präzisere Anpassung an spezifische Anwendungsfälle.

- 📝 Die Dokumentation und Workshops von Llama Index bieten Ressourcen für Entwickler, um tiefer in die Materie einzusteigen und ihre RAG-Systeme zu optimieren.

Q & A

Was sind die Hauptanwendungen von Sprachmodellen, die Jerry erwähnt?

-Die Hauptanwendungen umfassen Wissenssuche und Frage-Antwort-Systeme, Konversationsagenten, Workflow-Automatisierung und Dokumentenverarbeitung.

Welche zwei Hauptparadigmen zur Integration von Daten in Sprachmodelle werden diskutiert?

-Die zwei Hauptparadigmen sind Retrieval-Augmentation und Fine-Tuning.

Was versteht man unter Retrieval-Augmentation?

-Retrieval-Augmentation bezieht sich auf die Schaffung einer Datenpipeline, um Kontext aus einer Datenquelle in das Eingabeprompt des Sprachmodells einzufügen.

Was bedeutet Fine-Tuning in diesem Kontext?

-Fine-Tuning bezieht sich auf das Aktualisieren der Gewichte des Modells selbst, um Wissen durch einen Trainingsprozess über neue Daten zu integrieren.

Was sind die zwei Hauptkomponenten eines RAG-Stacks für den Aufbau eines QA-Systems?

-Die zwei Hauptkomponenten sind Dateneingabe und Datenabfrage, die Retrieval und Synthese umfasst.

Was sind einige Herausforderungen bei der Nutzung von naiven RAG-Systemen?

-Herausforderungen umfassen schlechte Antwortqualität, Probleme bei der Datenabfrage, geringe Präzision, Halluzinationen und veraltete Informationen.

Wie kann die Leistung einer Retrieval-Augmented-Generation-Anwendung verbessert werden?

-Verbesserungen können durch Optimierung der Datenpipeline, Anpassung der Einbettungsrepräsentationen, Verwendung fortgeschrittener Abfragemethoden und Synthesetechniken erzielt werden.

Was bedeutet die Optimierung der Chunk-Größen und warum ist sie wichtig?

-Die Optimierung der Chunk-Größen kann einen großen Einfluss auf die Leistung haben, da mehr abgerufene Tokens nicht immer eine höhere Leistung bedeuten und die Rangordnung der abgerufenen Tokens nicht unbedingt die Qualität der endgültigen generierten Antwort verbessert.

Was ist der Zweck der Metadatenfilterung und wie funktioniert sie?

-Metadatenfilterung zielt darauf ab, strukturierten Kontext zu den Textchunks hinzuzufügen, um die Präzision der Ergebnisse zu verbessern und lässt sich mit den Metadatenfilterfähigkeiten einer Vektordatenbank integrieren.

Wie können LLMs über die reine Generierung hinaus für das Reasoning verwendet werden?

-LLMs können verwendet werden, um über eine Frage zu räsonieren, indem sie in einfachere Fragen aufgeteilt und an verschiedene Datenquellen weitergeleitet wird, um eine ausgefeiltere Abfragestrategie zu ermöglichen.

Outlines

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenMindmap

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenKeywords

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenHighlights

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenTranscripts

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenWeitere ähnliche Videos ansehen

Mastering Summarization Techniques: A Practical Exploration with LLM - Martin Neznal

🔥 NEW LLama Embedding for Fast NLP💥 Llama-based Lightweight NLP Toolkit 💥

What is LangChain? 101 Beginner's Guide Explained with Animations

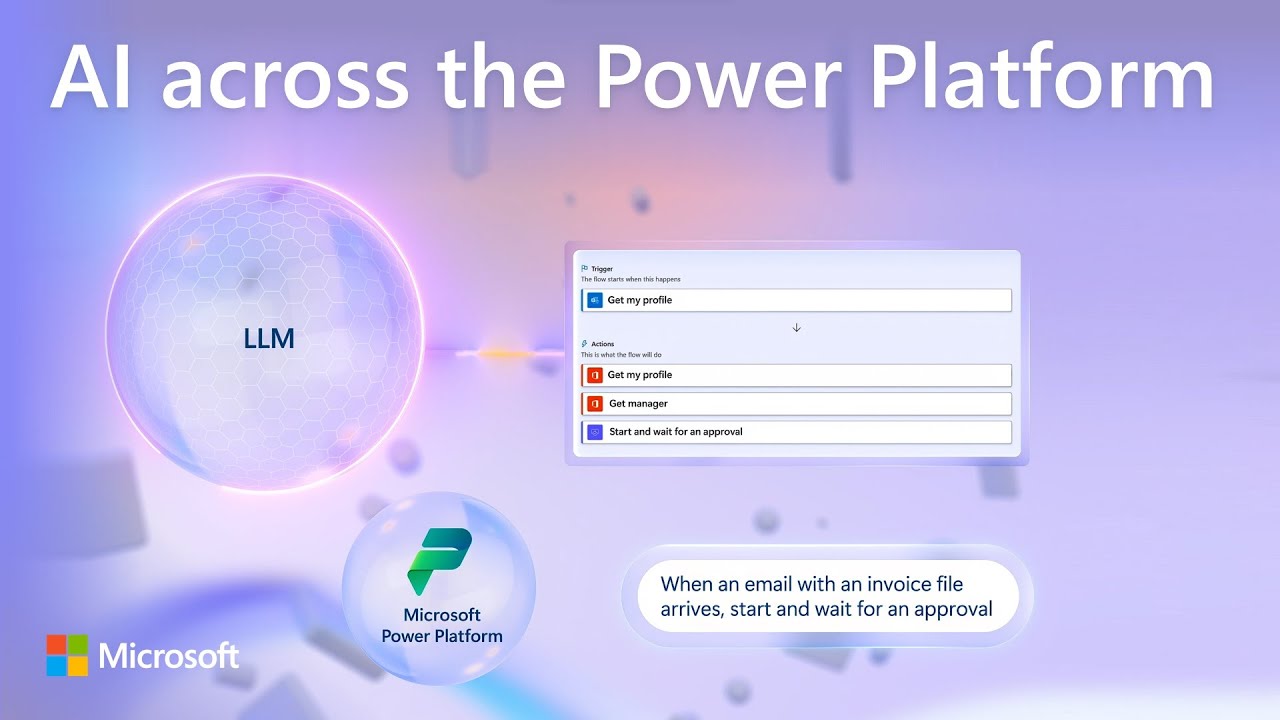

Copilot AI updates across the Power Platform | Automate, apps, pages & virtual agents

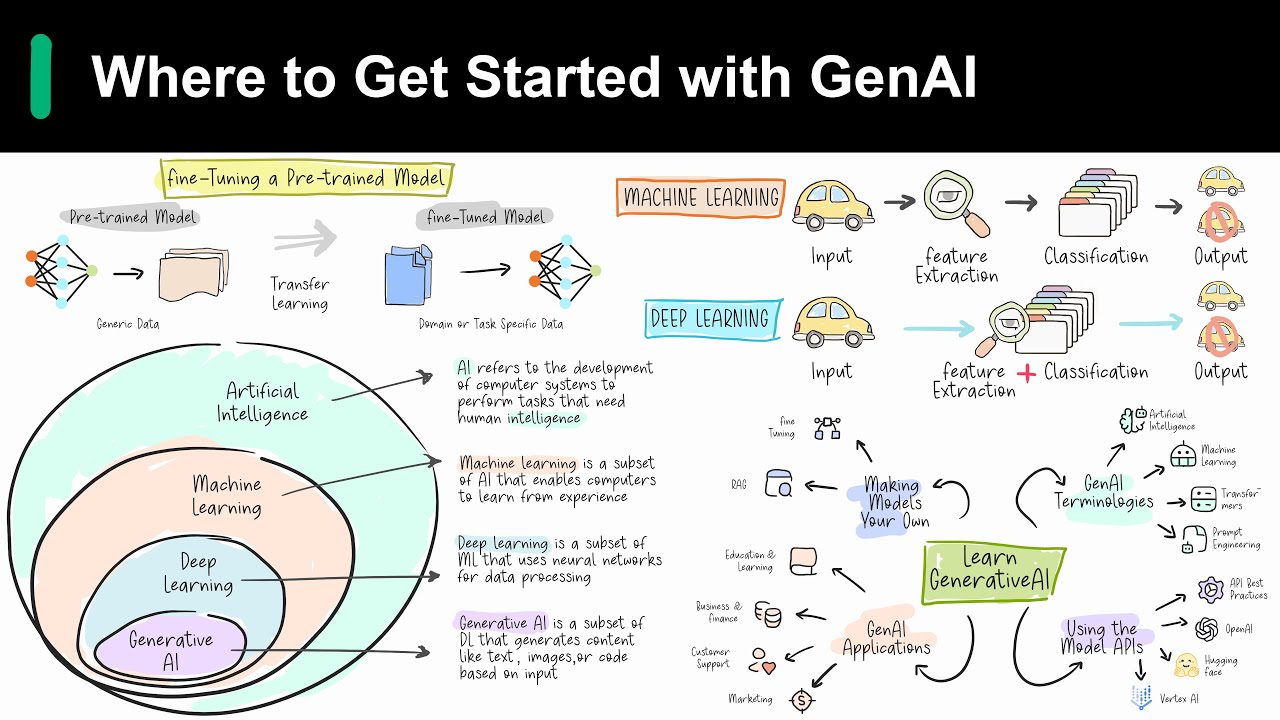

Introduction to Generative AI

Introduction to large language models

5.0 / 5 (0 votes)