Cadenas de Markov 01 Introducción

Summary

TLDREn este video, Enrique introduce el concepto de cadenas de Markov, un tipo de proceso estocástico donde la probabilidad de un evento depende únicamente del evento anterior. A través de ejemplos cotidianos, como la elección de comida y bebida, y la programación de partidos en un complejo deportivo, se explica cómo estos procesos pueden representarse mediante matrices de transición. También se abordan las probabilidades de transición a través de múltiples pasos, mostrando cómo las matrices se elevan a potencias para obtener transiciones a largo plazo. Un concepto fundamental para modelar y entender decisiones en escenarios dinámicos.

Takeaways

- 😀 Una cadena de Markov es un proceso estocástico discreto donde la probabilidad de un evento depende solo del evento anterior.

- 😀 Las cadenas de Markov son útiles para modelar decisiones y comportamientos donde el futuro solo depende del estado actual y no del pasado.

- 😀 Un ejemplo sencillo de una cadena de Markov es la elección entre diferentes bebidas en un restaurante, dependiendo de la comida elegida previamente.

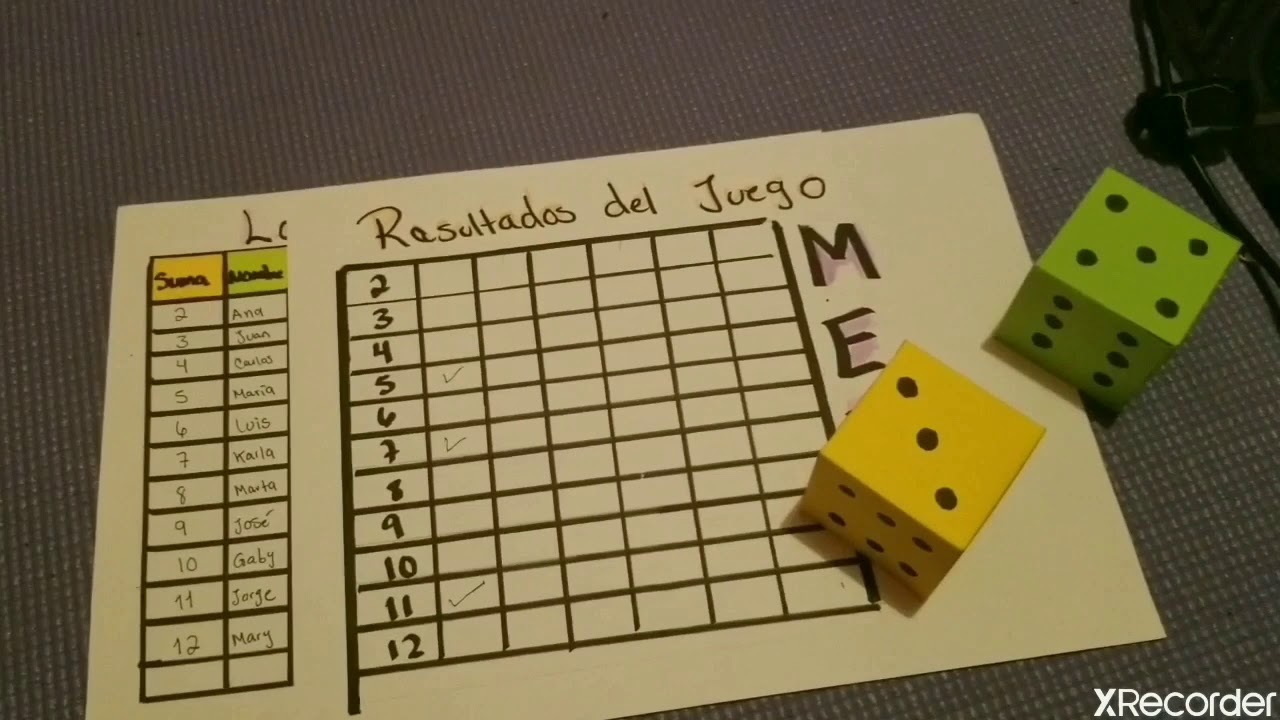

- 😀 En un modelo de Markov, los diferentes posibles estados (como los campos deportivos) representan las diferentes opciones o lugares en los que se puede estar.

- 😀 Las probabilidades de pasar de un estado a otro se llaman probabilidades de transición, y se pueden representar mediante una matriz.

- 😀 La matriz de transición muestra cómo se distribuyen las probabilidades entre los diferentes estados y debe tener la propiedad de que la suma de cada fila es 1.

- 😀 Es posible calcular probabilidades de transiciones después de múltiples pasos utilizando potencias de la matriz de transición.

- 😀 Para calcular la probabilidad de transición después de dos pasos, multiplicamos las probabilidades de las transiciones posibles y las sumamos.

- 😀 Al elevar la matriz de transición a una potencia mayor, podemos calcular las probabilidades de transición después de más de un paso.

- 😀 Las cadenas de Markov tienen aplicaciones prácticas en la predicción de eventos, la programación de recursos y otros procesos que dependen de probabilidades y decisiones previas.

Q & A

¿Qué es una cadena de Markov?

-Una cadena de Markov es un tipo de proceso estocástico discreto donde la probabilidad de que ocurra un evento depende solamente del evento inmediato anterior, sin considerar los eventos previos a ese.

¿Cómo se puede ilustrar el concepto de cadena de Markov con un ejemplo cotidiano?

-Un ejemplo cotidiano es elegir una bebida en un restaurante: si eliges pescado, es más probable que elijas vino blanco que vino tinto, lo que depende directamente de la elección anterior, que es el plato de comida.

¿Qué son los 'estados' en una cadena de Markov?

-Los 'estados' en una cadena de Markov son los diferentes posibles eventos o situaciones que pueden ocurrir en el proceso. En el ejemplo del fútbol, cada campo de fútbol es un estado.

¿Cómo se representan las probabilidades de transición en una cadena de Markov?

-Las probabilidades de transición se representan mediante una matriz de transición, que muestra las probabilidades de moverse de un estado a otro en un solo paso. Las filas representan los estados iniciales y las columnas los estados finales.

¿Qué propiedad tiene la matriz de transición en una cadena de Markov?

-Una propiedad fundamental de la matriz de transición es que la suma de los elementos de cada fila debe ser exactamente 1, ya que representa la probabilidad total de pasar a cualquier estado desde el estado inicial.

¿Cómo se calcula la probabilidad de transición después de varios pasos?

-La probabilidad de transición después de varios pasos se calcula multiplicando las matrices de transición correspondientes. Si queremos saber la probabilidad de pasar de un estado a otro en 'n' pasos, elevamos la matriz de transición a la potencia 'n'.

¿Qué se entiende por una 'matriz de transición de n pasos'?

-La matriz de transición de 'n' pasos es el resultado de multiplicar la matriz de transición de un solo paso repetidamente 'n' veces. Esto nos da la probabilidad de transición después de 'n' movimientos o pasos.

¿Cómo se calcula la probabilidad de pasar del estado 1 al estado 3 en dos pasos?

-Para calcular la probabilidad de pasar del estado 1 al estado 3 en dos pasos, se deben considerar todas las rutas posibles entre esos dos estados, multiplicando las probabilidades de las transiciones intermedias y sumándolas.

¿Qué significa que la matriz de transición de un solo paso sea 'M'?

-La matriz de transición de un solo paso, denotada por 'M', muestra las probabilidades de pasar de un estado a otro en un solo paso. Es la base para calcular las transiciones en pasos posteriores mediante su multiplicación.

¿Cuál es el uso práctico de las cadenas de Markov en el mundo de los negocios?

-En los negocios, las cadenas de Markov pueden utilizarse para modelar procesos de decisión donde las probabilidades de elegir diferentes opciones dependen únicamente de la elección previa, lo que ayuda a predecir comportamientos futuros, como la demanda de productos o la asignación de recursos.

Outlines

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenMindmap

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenKeywords

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenHighlights

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenTranscripts

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführen5.0 / 5 (0 votes)