L8/1 Gradient Exploding and Vanishing

Summary

TLDREn este video, se exploran dos problemas comunes en el entrenamiento de redes neuronales profundas: la explosión y la desaparición de gradientes. Se explica cómo el uso de matrices de pesos grandes puede generar valores de gradientes extremadamente altos (explosión de gradientes), mientras que los valores pequeños pueden hacer que los gradientes se vuelvan insignificantes (desaparición de gradientes). Ambos problemas pueden causar inestabilidad durante el entrenamiento, dificultando el aprendizaje efectivo de las redes profundas. Se analiza cómo estos problemas afectan tanto a las capas superiores como inferiores de la red, y se discuten técnicas para mitigar estos desafíos.

Takeaways

- 😀 La estabilidad numérica en redes neuronales es crucial para el entrenamiento eficiente.

- 😀 Los gradientes pueden verse afectados por dos problemas principales: explosión de gradientes y desvanecimiento de gradientes.

- 😀 La multiplicación de matrices en redes neuronales profundas puede causar problemas, como la explosión de gradientes.

- 😀 La explosión de gradientes ocurre cuando los valores se vuelven extremadamente grandes debido a multiplicaciones repetidas de matrices grandes.

- 😀 Cuando usamos valores demasiado grandes (por ejemplo, 1.5 elevado a la 100), los números pueden volverse infinitos, causando problemas durante el entrenamiento.

- 😀 La desvanecimiento de gradientes ocurre cuando los valores se vuelven demasiado pequeños debido a la multiplicación de matrices con números cercanos a cero.

- 😀 La función sigmoide puede producir gradientes pequeños si el valor de entrada es demasiado grande o pequeño, lo que lleva al desvanecimiento de gradientes.

- 😀 Si los gradientes se vuelven cero, no hay progreso en el entrenamiento, ya que no se pueden actualizar los pesos.

- 😀 Las capas cercanas a la entrada de la red son las que sufren más del desvanecimiento de gradientes, mientras que las capas cercanas a la salida reciben gradientes más grandes.

- 😀 Para redes neuronales profundas, como las que tienen 100 capas, las capas superiores pueden tener gradientes más grandes, mientras que las inferiores casi nulos, lo que dificulta el entrenamiento de redes muy profundas.

Q & A

¿Qué problema de estabilidad numérica se menciona en el script?

-El script menciona dos problemas principales de estabilidad numérica: la explosión de gradientes y la desaparición de gradientes. Ambos son causados por la multiplicación repetida de matrices de gran tamaño durante el cálculo de los gradientes en redes neuronales profundas.

¿Qué es la 'explosión de gradientes'?

-La explosión de gradientes ocurre cuando los valores de los gradientes se vuelven extremadamente grandes debido a multiplicaciones sucesivas de matrices con números grandes. Esto puede hacer que los valores lleguen a ser infinitos, lo que lleva a problemas durante el entrenamiento, como la inestabilidad numérica.

¿Cómo se puede evitar la explosión de gradientes?

-Para evitar la explosión de gradientes, se deben usar valores de activación y funciones de pérdida que no produzcan gradientes demasiado grandes. También se pueden utilizar técnicas como la normalización de lotes o la inicialización adecuada de pesos para mitigar este problema.

¿Qué sucede cuando se usa una tasa de aprendizaje demasiado alta debido a la explosión de gradientes?

-Cuando la tasa de aprendizaje es demasiado alta debido a la explosión de gradientes, los ajustes en los pesos pueden ser tan grandes que los gradientes se vuelven infinitos, lo que da como resultado valores incorrectos durante el entrenamiento y la incapacidad de converger a una solución óptima.

¿Qué es la 'desaparición de gradientes'?

-La desaparición de gradientes ocurre cuando los gradientes se vuelven extremadamente pequeños, lo que hace que los pesos de las capas inferiores de una red neuronal no se actualicen correctamente. Esto es especialmente problemático en redes neuronales profundas y cuando se utilizan funciones de activación como la sigmoide.

¿Cómo afecta la función sigmoide a la desaparición de gradientes?

-La función sigmoide produce gradientes muy pequeños para entradas grandes o pequeñas debido a su forma. Cuando los gradientes son pequeños, la multiplicación de estos gradientes en las capas inferiores de una red neuronal puede hacer que los gradientes desaparezcan por completo, impidiendo que los pesos se actualicen correctamente.

¿Qué problemas puede causar la desaparición de gradientes en redes neuronales profundas?

-En redes neuronales profundas, la desaparición de gradientes puede hacer que las capas cercanas a la entrada (capas inferiores) no aprendan correctamente, ya que sus gradientes se vuelven muy pequeños. Esto puede causar que solo las capas superiores aprendan durante el entrenamiento, haciendo que el modelo no sea eficaz.

¿Qué ocurre si se usan valores de gradientes demasiado pequeños durante el entrenamiento?

-Si los gradientes son demasiado pequeños, el proceso de actualización de los pesos se vuelve muy lento o incluso se detiene por completo. Esto ocurre porque los gradientes pequeños no provocan cambios significativos en los pesos, lo que impide que el modelo aprenda de manera efectiva.

¿Cuál es la relación entre la tasa de aprendizaje y los problemas de estabilidad numérica?

-La tasa de aprendizaje juega un papel crucial en la estabilidad numérica. Una tasa de aprendizaje demasiado alta puede causar la explosión de gradientes, mientras que una tasa demasiado baja puede provocar que el modelo no avance correctamente debido a gradientes muy pequeños. Por lo tanto, es importante ajustar la tasa de aprendizaje de manera adecuada durante el entrenamiento.

¿Por qué es más difícil entrenar redes neuronales profundas?

-Entrenar redes neuronales profundas es más difícil debido a problemas como la explosión y desaparición de gradientes, que se intensifican a medida que aumenta la cantidad de capas. Las capas inferiores, en particular, pueden tener gradientes muy pequeños o incluso nulos, lo que dificulta su aprendizaje y hace que el modelo sea menos eficiente.

Outlines

此内容仅限付费用户访问。 请升级后访问。

立即升级Mindmap

此内容仅限付费用户访问。 请升级后访问。

立即升级Keywords

此内容仅限付费用户访问。 请升级后访问。

立即升级Highlights

此内容仅限付费用户访问。 请升级后访问。

立即升级Transcripts

此内容仅限付费用户访问。 请升级后访问。

立即升级浏览更多相关视频

Tu primer clasificador de imágenes con Python y Tensorflow

Funciones de activación a detalle (Redes neuronales)

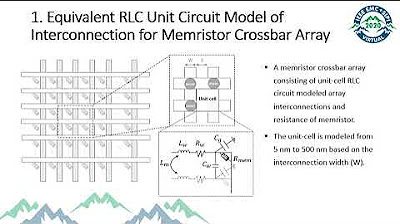

Modeling and Demonstration of Hardware-based Deep Neural Network(DNN) using Memristor Crossbar Array

El Perceptrón a detalle

Funciones de activación en las redes profundas

Del perceptrón a la red neuronal

5.0 / 5 (0 votes)