Data Stores Basics

Summary

TLDRВ этом видео скрипт рассматривается использование хранилищ данных в автоматизированных рабочих процессах. Хранилища данных позволяют сохранять информацию между запусками, что идеально подходит для создания счётчиков, уникальных списков, таких как адреса электронной почты, и отслеживания времени последнего запуска. В видео показан пример создания хранилища для сохранения адресов электронной почты клиентов, чтобы избежать повторных запусков рабочих процессов для тех же клиентов. Также демонстрируется, как проверить наличие адреса в хранилище и обновить его при необходимости, используя предварительно созданные шаги в рабочем процессе.

Takeaways

- 🔄 Каждое выполнение рабочего процесса начинается с чистого состояния, что исключает влияние предыдущих запусков на будущие.

- 🗂 Используя хранилища данных, можно сохранять данные для использования в последующих запусках или даже обмениваться данными между различными рабочими процессами.

- 📊 Хранилища данных подходят для создания счётчиков, массивов уникальной информации, таких как электронные адреса, для предотвращения повторного запуска рабочего процесса для одного и того же клиента.

- ⏰ Можно использовать хранилища данных для быстрого отслеживания последнего времени запуска рабочего процесса.

- 🛠️ В примере рабочего процесса используется триггер HTTP и инструмент hopscotch.pipedream.com для отправки POST-запроса с данными клиента.

- 📥 В рабочем процессе данные клиента, такие как имя, фамилия и адрес электронной почты, включены в теле запроса.

- 📝 Добавление нового шага для хранения адреса электронной почты клиента, чтобы избежать повторного запуска рабочего процесса для этого клиента.

- 🔑 Создание нового хранилища данных для хранения адресов электронной почты клиентов с использованием ключа 'email' и значения из тела запроса.

- 🔍 Тестирование добавления записи в хранилище данных и проверка успешности операции.

- 📋 Просмотр и редактирование данных в хранилище на дашборде, включая возможность редактировать и удалять записи вручную.

- 🚫 Использование шага для извлечения адреса электронной почты из хранилища данных и проверки наличия записи, чтобы предотвратить отправку писем тем, кому уже отправлено.

- 🔢 Рабочие процессы могут хранить данные, сериализуемые в JSON, включая объекты, массивы, строки, целые и десятичные числа.

Q & A

Что такое 'data store' в контексте автоматизированных рабочих процессов?

-Data store - это место хранения данных, которое сохраняется между несколькими запусками рабочих процессов и даже между различными рабочими процессами. Оно используется для хранения данных, таких как счетчики или уникальные списки информации, чтобы избежать повторных запусков рабочих процессов для одних и тех же данных.

Какие данные можно хранить в 'data store'?

-В 'data store' можно хранить данные, которые сериализуются в JSON, включая объекты, массивы, строки, целые и дробные числа.

Какие проблемы решает использование 'data store'?

-Использование 'data store' позволяет решить проблемы с повторными запусками рабочих процессов для одних и тех же данных, а также обеспечивает возможность хранения и использования данных в последующих запусках и между различными рабочими процессами.

Чем отличается 'data store' от 'step exports' в рабочем процессе?

-'Data store' хранит данные на протяжении многих запусков и между различными рабочими процессами, в то время как 'step exports' доступны только во время выполнения текущего рабочего процесса.

Какие действия можно выполнить с 'data store'?

-С 'data store' можно добавлять, получать, редактировать и удалять записи данных.

Как проверить, есть ли уже сохраненная запись в 'data store'?

-Для проверки существующей записи можно использовать функцию 'get record', указав 'data store' и ключ записи.

Какой шаг следует добавить для добавления записи в 'data store'?

-Для добавления записи в 'data store' следует добавить шаг 'add a single record', указав 'data store', ключ и значение записи.

Как настроить новый 'data store' в рабочем процессе?

-Чтобы настроить новый 'data store', нужно выбрать опцию создания нового хранилища, указать название хранилища и ключ-значение для хранимых данных.

Как можно избежать отправки писем тем же людям, для которых уже был запущен рабочий процесс?

-Можно использовать 'data store' для хранения адресов электронной почты, и перед отправкой проверять наличие адреса в 'data store', чтобы избежать повторных отправок.

Что будет показано в 'data store' после добавления записи?

-После добавления записи в 'data store' будет показана информация о ключе и его значении, а также подтверждение успешного добавления записи.

Какие дополнительные функции будут рассмотрены в будущих сериях?

-В будущих сериях будет показано, как использовать 'data store' в рамках шагов на Node.js, а также, возможно, в других языках программирования, таких как Python, Bash или Go.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

Official Guide: How to use Vy AI Agent!

Developers are getting screwed.

Digital Transformation - Digitization, Digitalization and Digital Transformation

Как Нейросети Обобщают Знания? Генерализация в ИИ.

Adding memory to Cursor using MCP and a Knowledge Graph database

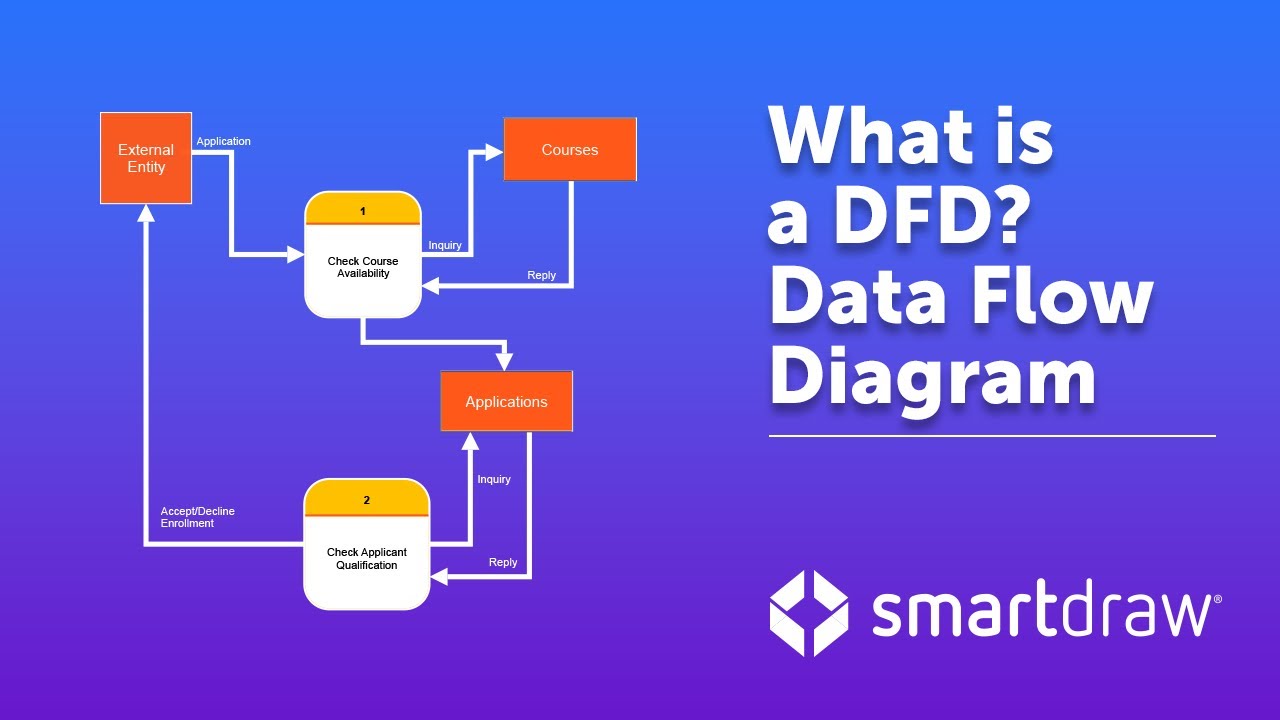

Data Flow Diagrams - What is DFD? Data Flow Diagram Symbols and More

5.0 / 5 (0 votes)