Types of Image Sensors | Image Sensing

Summary

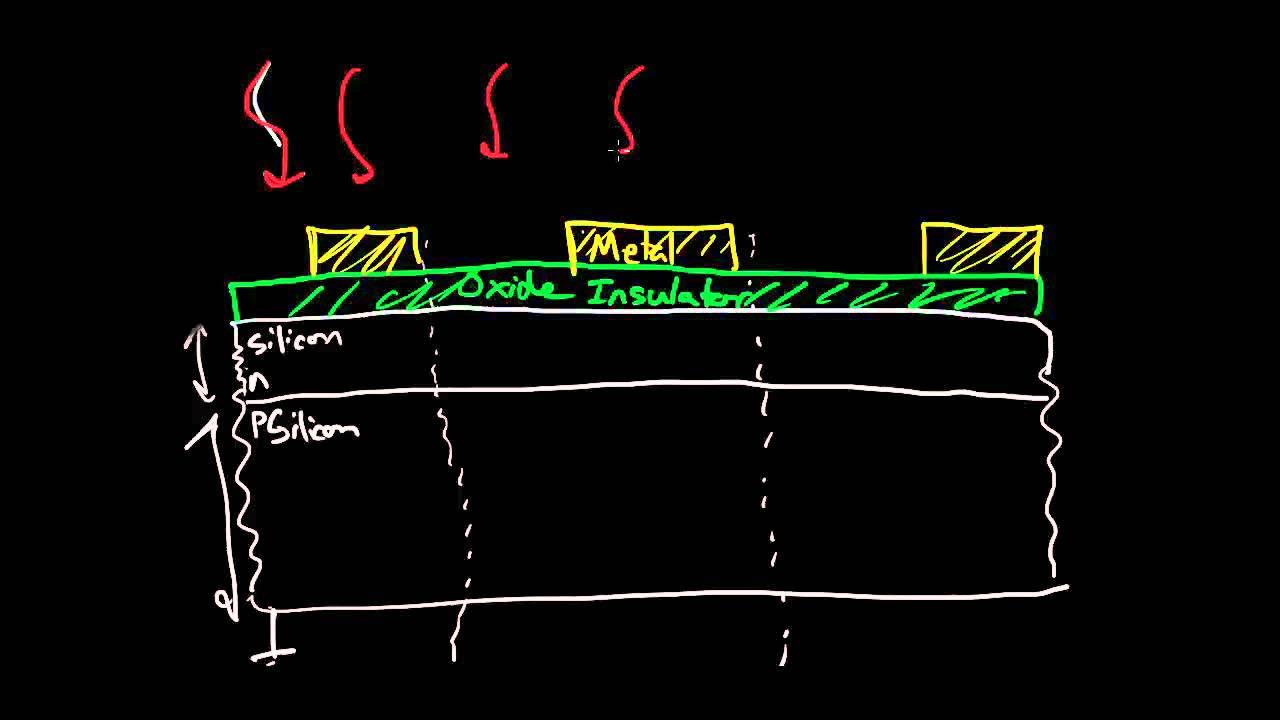

TLDREl guion del video explica cómo los sensores de imagen funcionan utilizando silicio, que al recibir luz libera electrones creando pares electron-agujero. Se describe cómo se crea un equilibrio entre la luz y los electrones, y cómo se leen los electrones para convertirlos en señal de imagen. Se mencionan dos tecnologías principales: CCD y CMOS, con sus ventajas y desventajas. Además, se abordan filtros de color y microlentes para mejorar la calidad de la imagen. El futuro de la tecnología de sensores de imagen implica una integración más estrecha de circuitería y óptica en un solo wafer de silicio.

Takeaways

- 🧬 Los sensores de imagen más comunes están hechos de silicio, un elemento con propiedades excepcionales.

- 💥 Al impactar un fotón con suficiente energía en un átomo de silicio, se libera un electrón, creando un par electrón-agujero.

- 💡 La creación de un cristal de silicio de alta pureza permite que la luz genere flujo de electrones al impactar en él.

- ⚖️ Existe un equilibrio entre el flujo de fotones y el flujo de electrones generados por la luz.

- 🔋 El silicio es esencial en la detección de imágenes, generando electrones al recibir luz.

- 🔍 La dificultad principal es la lectura y conversión de electrones en voltaje para su posterior lectura.

- 🌟 Se pueden empaquetar fácilmente cientos de millones de píxeles en un sensor de imagen moderno.

- 📏 La ley de Moore no se aplica de la misma manera a los sensores de imagen, donde el tamaño del píxel está limitado por la longitud de onda de la luz.

- 🛠 El primer tipo de tecnología utilizada para crear sensores de imagen es el CCD, que implica la transferencia de cargas de un row a otro.

- 🌈 Los sensores de imagen CMOS son una alternativa a los CCD, ofrecen mayor flexibilidad y dominan en la mayoría de las cámaras modernas.

- 🎨 Los filtros de color, conocidos como mosaico de color, son esenciales para medir el color en los píxeles que no pueden diferenciar colores por sí solos.

- 🔬 Cada píxel tiene una lente micro miniatura, llamada microlente, que enfoca la luz desde la lente principal al área activa del píxel.

Q & A

¿Qué material se utiliza comúnmente para los sensores de imagen actuales?

-Los sensores de imagen se hacen comúnmente de silicio, un material con propiedades increíbles para la detección de luz.

¿Qué sucede cuando un fotón de suficiente energía impacta un átomo de silicio?

-Cuando un fotón de suficiente energía impacta un átomo de silicio, se libera un electrón, creando un par electrón-agujero.

¿Cómo se establece el equilibrio entre el flujo de fotones y el flujo de electrones en un cristal de silicio?

-El equilibrio entre el flujo de fotones y el flujo de electrones se establece cuando se ilumina un cristal de silicio de alta pureza con luz.

¿Qué desafío representa leer los electrones generados por la luz en un sensor de imagen de silicio?

-El desafío es convertir los electrones en voltaje y leerlos, especialmente cuando se trata de millones de píxeles que deben leerse individualmente.

¿Cuál es la dimensión típica de un píxel en un sensor de imagen de 18 megapíxeles?

-Cada píxel en un sensor de imagen de 18 megapíxeles tiene aproximadamente un micron en cada una de sus dos dimensiones, siendo 1.25 microns en este caso.

¿Cómo se compara el avance en la resolución de los sensores de imagen con la ley de Moore en computación?

-A diferencia de la ley de Moore, que indica un doble de poder de cómputo cada 18 meses, la resolución de los sensores de imagen no se duplica tan rápidamente debido a los límites de la difracción de la luz.

¿Qué es un CCD y cómo funciona para crear sensores de imagen?

-Un CCD, o dispositivo acoplado de carga, es una tecnología que utiliza 'calderas' o potenciales bienes para convertir fotones en electrones y luego pasar los electrones de fila en fila hasta ser leídos horizontalmente.

¿Qué es un sensor de imagen CMOS y cómo se diferencia de un CCD?

-Un sensor de imagen CMOS, o semiconductor complementario de oxido de metal, tiene un circuito en cada píxel para convertir electrones en voltaje, lo que permite una mayor flexibilidad y velocidad en la lectura de los datos.

¿Qué función cumple el filtro de color en un sensor de imagen y cómo se aplica?

-Los filtros de color, que se sitúan sobre cada píxel, permiten medir el color de la luz, ya que un píxel por sí solo no puede diferenciar colores y solo cuenta fotones.

¿Qué es un microlente y qué propósito tiene en un sensor de imagen?

-Un microlente es una pequeña lente que se sitúa sobre cada píxel y tiene la función de concentrar la luz proveniente de la lente principal en el área activa del píxel sensible a la luz.

¿Qué es la 'ley de la difracción de la luz' y cómo limita la resolución de los sensores de imagen?

-La ley de la difracción de la luz establece que más pequeña que sea la longitud de onda de la luz, menos resolución se puede obtener, limitando así el tamaño mínimo de los píxeles y la resolución de los sensores de imagen.

¿Qué es la 'óptica en wafer' y cómo se relaciona con el futuro de los sensores de imagen?

-La 'óptica en wafer' se refiere a la integración de componentes ópticos, como el microlente y la lente principal, creciendo en una única wafer de silicio, lo que puede llevar a la integración de procesamiento de imagen y visión por computadora en el futuro.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

Image Sensors 5 of 6 - Frontside and Backside Illumination

Paneles Solares Explicados - ¡Descubre los Misterios del Funcionamiento de los Paneles Solares!

Como funciona la camara de fotos digital Discovery

POR QUE LA SELVA Y EL BOSQUE NO TIENEN PLAGAS Y ENFERMEDADES

¿Qué es un agujero negro? | #ESPNShow

1. Absorción y Emisión | Fotoquímica

5.0 / 5 (0 votes)