El Perceptrón a detalle

Summary

TLDREl script proporciona una introducción detallada al perceptrón, una pieza clave en la construcción de redes neuronales. Se destaca la importancia del perceptrón como unidad básica para generar arquitecturas complejas y profundas en el campo de las redes neuronales. El precursor del perceptrón, Frank Rosenblatt, es mencionado por su contribución fundamental. La analogía del perceptrón con las neuronas del cerebro se explora, y se describe cómo el perceptrón utiliza pesos y una función de activación para convertir entradas en una salida binaria. El script también aborda los límites del perceptrón simple, que solo resuelve problemas lineales, y hace alusión a la capacidad de resolver problemas más complejos a través de perceptrones multicapa y redes neuronales, lo que se profundizará en futuras lecciones.

Takeaways

- 🤖 El perceptrón es una piedra angular en la construcción de redes neuronales y actúa como la unidad básica para generar arquitecturas complejas.

- 👨💼 Frank Rosenblatt fue el precursor del perceptrón, inspirado en su conocimiento previo en neurociencias y su trabajo para la Marina de Estados Unidos.

- 🧠 La inspiración del perceptrón viene de la forma en que las neuronas funcionan, recibiendo información a través de las dendritas, procesándola en el núcleo y enviando impulsos a través del axón.

- 📈 El perceptrón realiza una combinación lineal de entradas usando pesos y un sesgo, y luego aplica una función de activación para producir una salida.

- ⚙️ La función de activación del perceptrón es crucial, ya que decide si se ha encontrado un patrón en las entradas, activándose o no.

- 📉 Una función de activación común utilizada en el perceptrón es la función escalón, que produce una salida de 1 o 0 dependiendo del valor de la combinación lineal.

- 🔢 El perceptrón mapea un conjunto de entradas a un valor de salida, que puede ser una aproximación o una predicción del comportamiento deseado.

- 🔴🔵 El perceptrón simple tiene limitaciones y solo puede resolver problemas lineales, lo que lo hace incapaz de manejar tareas como la operación lógica XOR.

- 🚧 A pesar de sus limitaciones, el perceptrón puede ser extendido a través de la creación de redes neuronales multicapas para resolver problemas no lineales.

- 📚 La programación y el entrenamiento inicial del perceptrón eran manuales y complicados, lo que llevó a la búsqueda de métodos más eficientes de aprendizaje automático.

- 🧐 Los pesos y el sesgo del perceptrón son parámetros clave que deben ser determinados para que el modelo funcione correctamente, y aunque existen múltiples combinaciones posibles, algunas son más efectivas que otras.

Q & A

¿Qué es el perceptrón y por qué es importante en las redes neuronales?

-El perceptrón es una unidad básica utilizada en las redes neuronales. Es importante porque actúa como la piedra angular o la base desde la cual se construyen las redes neuronales, pudiendo ser la unidad a partir de la cual se generan las arquitecturas y redes que pueden ser muy profundas y complejas.

¿Quién fue Frank Rosenblatt y qué contribuyó a la inteligencia artificial?

-Frank Rosenblatt fue un precursor en el campo de las redes neuronales y propuso el perceptrón. Aunque no era matemático ni computólogo por formación, su estudio de psicología y posterior posgrado en neurociencias le permitieron replicar lo que ocurre en las neuronas en un modelo matemático.

¿Cómo funciona una neurona y cómo se relaciona con el funcionamiento del perceptrón?

-Una neurona obtiene información a través de las conexiones llamadas dendritas, procesa esta información en su núcleo y transfiere un impulso de salida a través del axón hacia otras neuronas. El perceptrón, inspirado en esto, utiliza circuitos y conexiones que representan resistencias para simular este proceso de activación y transferencia de información.

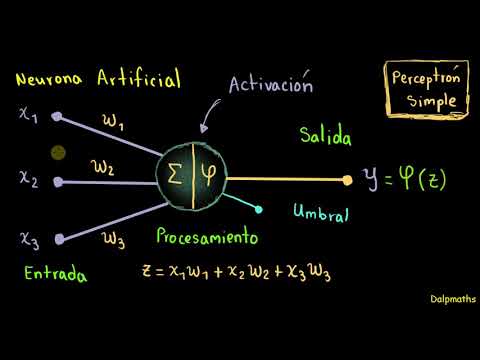

¿Cómo se define matemáticamente un perceptrón?

-Un perceptrón se define como un mapeo que convierte un conjunto de entradas (un vector de características) en un valor de salida. Internamente, realiza una combinación lineal de las entradas con un conjunto de pesos y luego pasa el resultado intermedio por una función de activación para generar la salida.

¿Qué es la función de activación en un perceptrón y cuál es su propósito?

-La función de activación en un perceptrón es una función que determina si se ha encontrado un patrón en las entradas. Su propósito es establecer si se debe o no generar una salida, funcionando como una decisión de 'sí' o 'no', similar a decidir si un perro está presente en una imagen o no.

¿Cómo se representa un perceptrón en términos de entradas, pesos y sesgo?

-Un perceptrón se representa con un vector de entradas (x1, x2, ..., xn), un vector de pesos (W1, W2, ..., Wn) y un sesgo (b). La salida del perceptrón se calcula a partir de la combinación lineal de las entradas y los pesos más el sesgo, y luego se pasa por una función de activación.

¿Por qué un perceptrón simple no puede resolver el problema del XOR?

-Un perceptrón simple no puede resolver el problema del XOR porque este problema no es linealmente separable. El perceptrón solo puede resolver problemas que se pueden separar mediante una combinación lineal de entradas, y el XOR requiere una separación que no sigue una línea recta o hiperplano.

¿Cómo se resuelve el problema de la no resolución de XOR por parte de un perceptrón simple?

-El problema de la no resolución de XOR por parte de un perceptrón simple se resuelve a través del uso de redes neuronales que incluyen múltiples capas de perceptrones, conocidas como perceptrones multicapas o redes neuronales. Estas capas adicionales permiten resolver problemas no lineales.

¿Cómo se puede entrenar un perceptrón para que aprenda los pesos adecuados?

-Un perceptrón se puede entrenar presentando un conjunto de datos de entrenamiento y ajustando los pesos de acuerdo con un algoritmo de aprendizaje, como el método de gradiente descendente. El objetivo es minimizar la diferencia entre la salida esperada y la salida real del perceptrón.

¿Qué es el sesgo en un perceptrón y cómo afecta la línea de decisión?

-El sesgo en un perceptrón es un parámetro adicional que permite desplazar la línea de decisión vertical o horizontalmente. Es útil para ajustar la línea de decisión para que mejor se adapte a los datos de entrenamiento y mejore la capacidad del perceptrón para separarlos.

¿Cómo se puede visualizar la separación que realiza un perceptrón en un problema binario de clasificación?

-La separación que realiza un perceptrón en un problema binario de clasificación se puede visualizar gráficamente mediante un diagrama en el que las entradas se representan en los ejes X e Y. Las regiones donde el perceptrón predice una salida de 1 se separan de las regiones donde predice una salida de 0 por una línea de decisión (o hiperplano en casos multidimensionales).

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade Now5.0 / 5 (0 votes)