OpenAI APIがアップデート!新料金やFunctionCallingなどポイントを解説

Summary

TLDRこの動画では、OpenAIがリリースした新機能「Function Call API」について詳しく説明しています。Function Call APIとは、ユーザーの入力に応じて適切な外部APIを呼び出し、その結果を返すことができる便利な機能です。動画ではこの機能の使い方や料金体系の変更、他の機能アップデートについても触れており、視聴者に分かりやすくFunction Call APIの魅力を伝えています。開発者にとって有益な情報が盛りだくさんの動画なので、ぜひご覧ください。

Takeaways

- 😃 OpenAIがAPIを更新し、新機能「Function Calling」を導入した。

- 🤖 Function Callingでは、ユーザーの入力から必要な外部関数を特定し、関数に必要な入力をJSON形式で出力できる。

- ✨ 上限トークン数が増加し、API利用費用が値下げされた。

- 📝 gpt-3.5-turbo-16kモデルで最大16,000トークンを処理可能になった。

- 💰 Embeddings APIが75%値下げ、入力トークンが25%値下げされた。

- 🔑 Function Callingを使うには、APIキーの設定と関数の定義が必要。

- 🧩 関数の詳細を記述し、その記述を言語モデルに渡す必要がある。

- 🌐 外部APIを簡単に呼び出せるようになり、APIレスポンスを含む回答を生成できる。

- 👩🏫 ビデオではFunction Calling APIの使い方が分かりやすく説明されている。

- 📋 Googleコラボのリンクが共有され、実践的な学習が可能である。

Q & A

OpenAIのAPIの更新で追加された新機能は何ですか?

-新機能として「Function Calling」が追加されました。これは外部APIなどを呼び出して処理を行う機能です。

FunctionCallingの便利な点は何ですか?

-ユーザーの入力から必要な外部関数を判断し、その関数に入力するための情報をJSONフォーマットで出力してくれます。外部APIを使いやすくする機能です。

gpt-3.5-turbo-16kとはどのようなモデルですか?

-gpt-3.5-turbo-16kは、トークン数の上限が16,000までに緩和されたモデルです。従来の4,000トークンから大幅に増えています。

APIの料金体系はどのように変更されましたか?

-Embeddings APIが75%割引、gpt-3.5-Turboの入力トークンが25%割引、出力トークンが20%割引になりました。gpt-3.5-turbo-16Kは従来モデルの2倍の価格ですが、まだ実用的な価格帯です。

FunctionCallingの使い方を簡単に説明してください。

-1. APIキーを設定 2. 利用したい外部関数の定義と説明を記述 3. モデルにユーザー入力と関数の説明を渡す 4. 出力されたJSONから必要な入力情報を取得 5. 外部関数を実行し、結果を次の入力に使う

動画の中で使われた外部APIの例は何ですか?

-getCurrentWeatherという、場所と単位を受け取り天気情報を返す架空の関数が使われていました。

「More Reliable Stability via the System Message」とは何を意味していますか?

-従来のシステムロールの指示がモデルの出力に反映されにくい問題を改善し、システムメッセージの指示を確実に反映できるようになったことを指します。

gpt-4-0613とgpt-3.5-turbo-0613はどのようなモデルですか?

-gpt-4-0613とgpt-3.5-turbo-0613は、Function Callingに対応したモデルです。ユーザー入力からFunctionを呼び出すかどうかを判断します。

FunctionCallingの出力フォーマットはどのようになっていますか?

-必要な入力情報がJSONフォーマットで出力されます。例えば{'function_name': 'getCurrentWeather', 'arguments': {'location': 'Boston', 'units': 'Celsius'}}のようになります。

FunctionCallingを利用するメリットは何ですか?

-外部APIなどの機能をスムーズに呼び出せるため、より高度な処理が可能になります。人工知能の機能を柔軟に拡張できるようになります。

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowBrowse More Related Video

OpenAIの機能を使えばChatGPTのプロンプトの勉強はいりません!

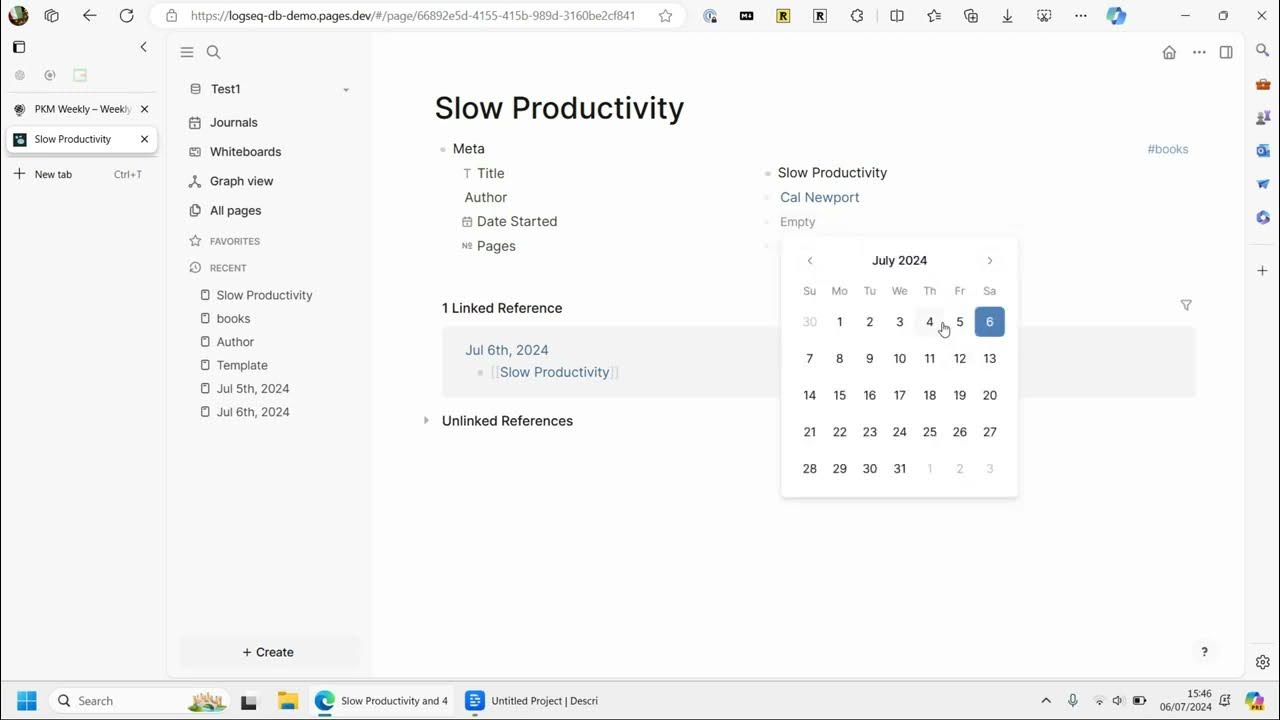

Logseq Database DB Version - Play Around

【速報】1年ぶりのメジャーアップデート!フィモーラ14の使える11の新機能を紹介【Filmora14】

Webinar: Build The Right Thing: A Feature Strategy Guide by Spotify Sr PM, Dejan Krstic

OpenAIのGPTsより凄い!無料で使えるDifyを徹底解説してみた

Mistral Large STUNS OpenAI - Amazing AND Uncensored!? 😈

5.0 / 5 (0 votes)