Como funciona un RAG y alternativas nocode al retrieval de asistentes

Summary

TLDREl video ofrece una visión detallada sobre la creación de asistentes de inteligencia artificial que funcionan con una base de conocimientos específica. Se discute la técnica de 'retrieval' y sus desafíos, como la inconsistencia y el costo elevado,对比 con otras técnicas como 'fine-tuning'. Se explora el uso de GPṬ personalizado y su acceso limitado a usuarios de GPṬ Plus. El video también calcula el costo de las consultas y sugiere alternativas para reducir gastos. Luego, se profundiza en el funcionamiento de un esquema de 'retrieval', desde la división de documentos en 'chunks' hasta la búsqueda semántica y la generación de respuestas finales. Se presentan herramientas no-code como Voiceflow y WordPress para implementar sistemas de 'retrieval' y se analizan sus ventajas y desafíos en términos de eficiencia y coste. El contenido es una guía para aquellos interesados en la construcción de asistentes de IA personalizados, destacando la importancia de la elección de estrategias y herramientas que se ajusten al caso de uso específico.

Takeaways

- 🤖 La creación de asistentes con conocimientos específicos puede no ser consistente cuando se utiliza la opción de retrieval, ya que puede ser costosa o generar alucinaciones.

- 📚 Las bases de conocimiento para los bots generalmente consisten en documentos en formatos como PDF, Word, texto, etc., y se utilizan para otorgar información nueva al asistente.

- 🔄 La técnica de 'fine tune' es una alternativa a retrieval que puede ser utilizada en ciertos casos, pero es más compleja de implementar.

- 🚀 Los 'GPT Custom' son una opción para los asistentes, pero solo disponibles para quienes paguen la suscripción GPT Plus.

- 💰 El uso de GPT para el retrieval puede ser costoso, especialmente cuando se consideran los tokens utilizados por las respuestas a las preguntas.

- 📈 Se puede calcular el costo de usar GPT para el retrieval, y este puede variar dependiendo de la versión de GPT utilizada.

- 📝 La técnica de 'splitter' se utiliza para dividir documentos en fragmentos de texto llamadas 'chunks', que son procesados para su uso en retrieval.

- 🔗 El 'overlap' entre chunks es importante para asegurar que la información relevante para responder una pregunta esté incluida.

- 📐 Los chunks son vectorizados usando modelos de embeddings, los cuales son vectores multidimensionales que representan la semántica de una frase o palabra.

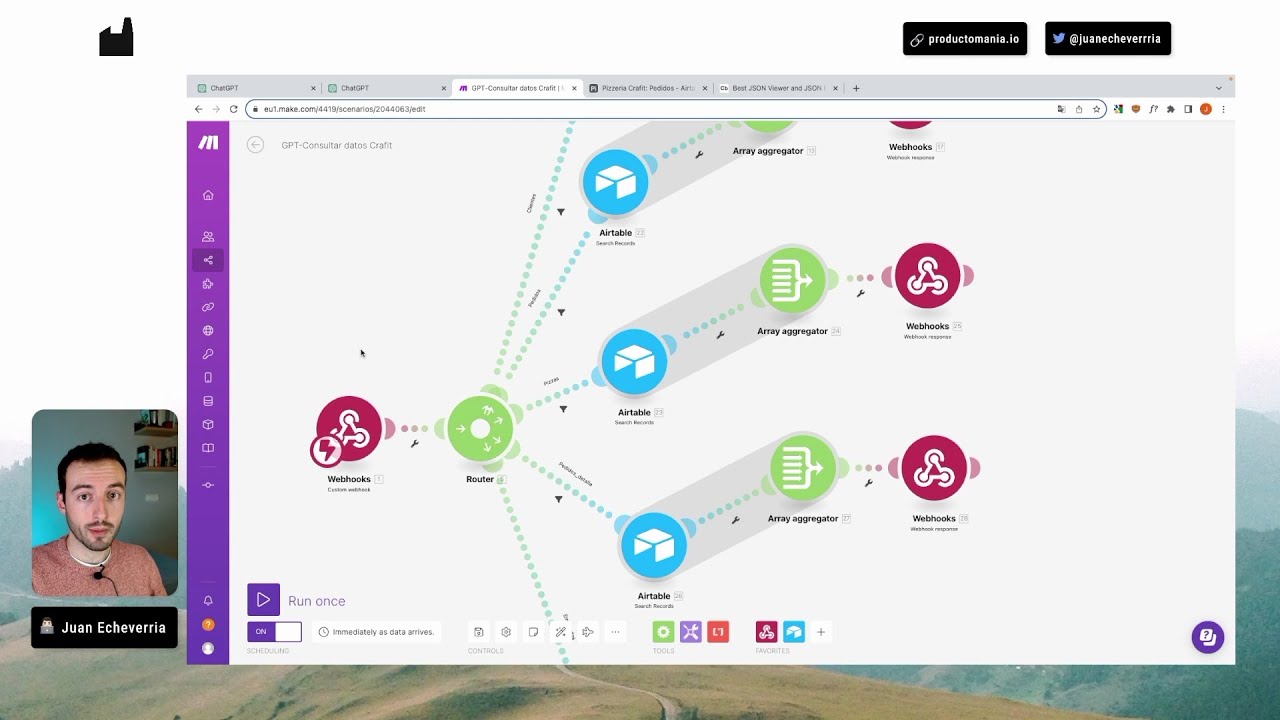

- 🔍 La búsqueda semántica en la base de datos vectorial se realiza para encontrar chunks semánticamente similares a la consulta del usuario.

- 🛠️ Las herramientas no-code como Voiceflow y WordPress ofrecen implementaciones de retrieval y son flexibles en cuanto a la configuración de la base de conocimiento y el modelo de respuesta.

- 🔧 Es posible optimizar el uso de tokens y reducir costos al crear bases de conocimiento separadas para temas específicos y clasificar las preguntas antes de buscar en ellas.

Q & A

¿Qué problemas pueden surgir al utilizar la opción de 'retrieval' en un asistente?

-Los problemas pueden incluir inconsistencia en las respuestas, costos elevados y la posibilidad de errores o 'alucinaciones' en la información proporcionada.

¿Qué alternativa a la técnica de 'retrieval' se menciona en el script?

-Se menciona la técnica de 'fine tune', que puede ser empleada dependiendo del caso de uso, aunque es más compleja de implementar.

¿Qué son los 'chunks' en el contexto de la generación de conocimientos para un asistente?

-Los 'chunks' son fragmentos de texto creados a partir de documentos, que son utilizados para proporcionar información semántica al modelo de lenguaje.

¿Cómo se calcula el costo de una pregunta utilizando el modelo GPT 4?

-Se divide el número total de tokens utilizados por la pregunta entre un millón y se multiplica por el costo por token, lo que da el costo por pregunta.

¿Qué es la función del 'splitter' en el proceso de generación de chunks?

-El 'splitter' es el módulo encargado de descomponer los documentos en chunks, pudiendo tomar estrategias como dividir por cantidad de caracteres, tokens, o mantener oraciones completas.

¿Qué es el 'overlap' y por qué es útil en la generación de chunks?

-El 'overlap' es una parte de texto que se repite en los chunks adyacentes, lo que es útil para asegurar que la información relevante para responder una pregunta abarque varias oraciones o párrafos.

¿Qué son los 'embeddings' y cómo se relacionan con el proceso de búsqueda semántica?

-Los 'embeddings' son vectores que representan palabras o frases en un espacio vectorial multidimensional según su semántica. Se utilizan en búsquedas semánticas para encontrar chunks similares a la consulta del usuario.

¿Cómo se determina la similitud entre dos vectores en una búsqueda semántica?

-Se calcula el coseno del ángulo formado entre los vectores; cuanto más cercano al 1 sea el valor, más similares serán los vectores y, por tanto, los chunks que representan.

¿Qué factores complican el uso de un esquema de 'retrieval' cuando se incorporan cientos de archivos con temas distintos?

-La cantidad de chunks similares que pueden surgir, la elección del modelo de embeddings, el almacenamiento de estos en la base de datos, y la determinación de la relevancia de un chunk son factores que pueden complicar el esquema de 'retrieval'.

¿Qué es la generación aumentada con recuperación correctiva (SERAC) y cómo funciona?

-La SERAC es una técnica que analiza la calidad de los chunks devueltos por la búsqueda. Si son ambiguos, se realiza una búsqueda en internet para mejorar los resultados. Si son incorrectos, se toman solo los datos de internet.

¿Cómo se pueden reducir los costos asociados al uso de un asistente con la función de 'retrieval'?

-Se pueden crear bases de conocimiento separadas para temas específicos, lo que reduce la cantidad de chunks que se consideran para cada pregunta y, por tanto, el número de tokens utilizados.

Outlines

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenMindmap

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenKeywords

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenHighlights

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenTranscripts

Dieser Bereich ist nur für Premium-Benutzer verfügbar. Bitte führen Sie ein Upgrade durch, um auf diesen Abschnitt zuzugreifen.

Upgrade durchführenWeitere ähnliche Videos ansehen

5 herramientas de IA para potenciar tus estudios

cómo CREAR NOTAS en NOTION con SIRI 🤖 (fácil) con Atajos [2024]

Los 10 MEJORES PROMPTS para ChatGPT [ Como usar la INTELIGENCIA ARTIFICIAL ]

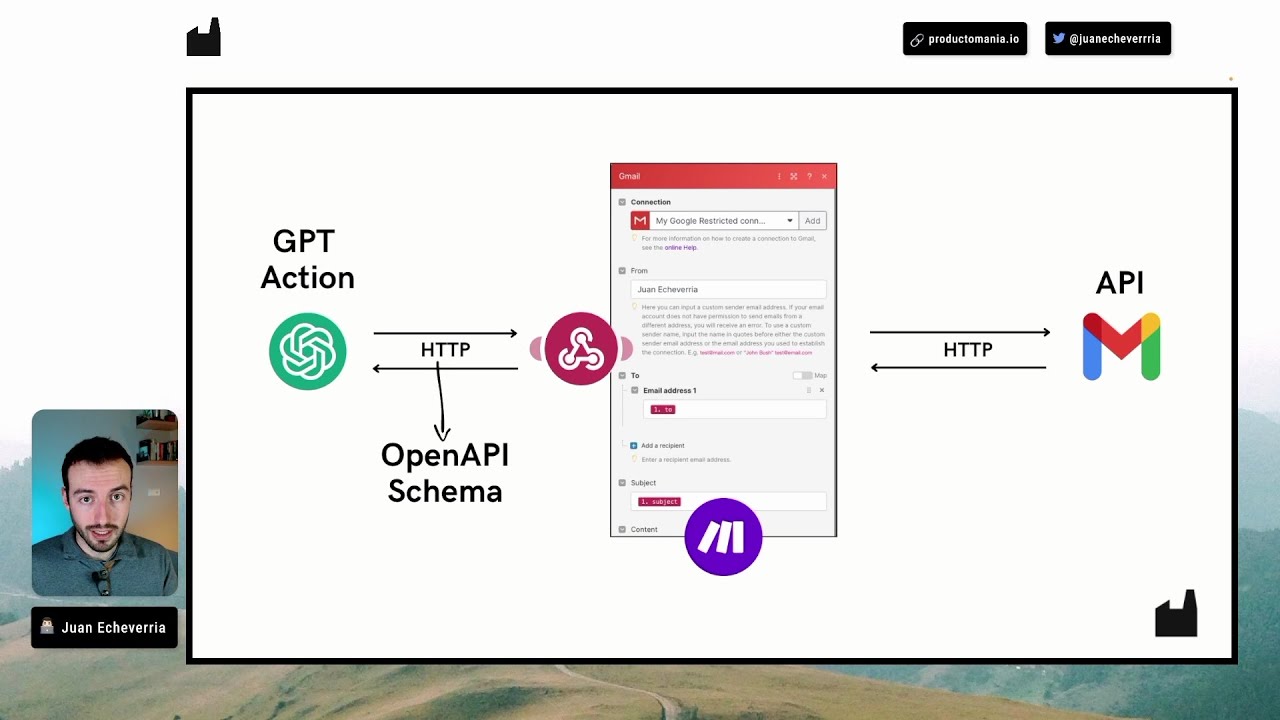

Cómo añadir ACCIONES a un GPT para darle SUPERPODERES 🦸🏻♂️

Como Crear y Escalar una Agencia de IA a +10.000 USD por mes

Aprende lo básico sobre APIs y HTTP para CONECTAR la IA con cualquier aplicación

5.0 / 5 (0 votes)