Mindblowing Research That Will Change The Way You Use LLMs

Summary

TLDRCette vidéo explore une recherche sur les modèles de langage (LLM) et la manière dont leurs performances varient lors de conversations à plusieurs tours. Une étude de Microsoft et Salesforce montre que les modèles ont souvent de meilleures performances dans des conversations à tour unique que dans des interactions plus longues, où ils perdent le fil du contexte, entraînant une dégradation des résultats. L’auteur suggère des stratégies pratiques pour améliorer l'interaction, comme commencer une nouvelle conversation ou consolider les informations pour éviter que le modèle ne se perde. L'étude met en évidence l'importance de repenser la gestion des conversations avec les LLMs.

Takeaways

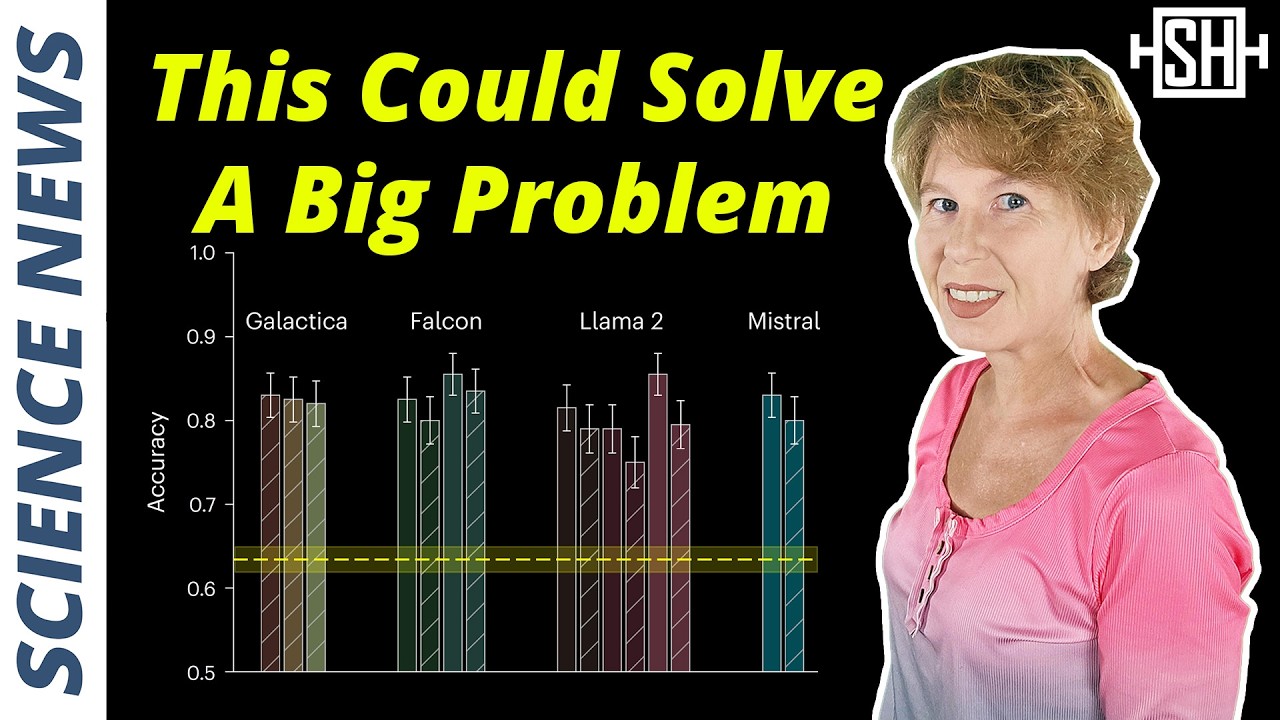

- 😀 Les modèles de langage (LLM) sont principalement évalués sur des instructions à un seul tour, mais leur performance peut varier lors de conversations multi-tours.

- 😀 L'étude a comparé l'impact des instructions 'shardées' (coupées en plusieurs morceaux) sur la performance des LLMs par rapport aux instructions complètes données en une seule fois.

- 😀 Les instructions shardées permettent une conversation plus fluide, où l'information est donnée au fur et à mesure, mais leur performance diminue par rapport aux instructions complètes.

- 😀 Un phénomène appelé 'perte dans la conversation' a été observé, où les modèles ont montré une baisse de performance de 39% en raison de leur incapacité à maintenir le contexte sur plusieurs tours.

- 😀 Les petites tailles de modèles sont particulièrement affectées par cette perte de performance par rapport aux modèles plus grands.

- 😀 Les simulations ont montré que les modèles réagissent mieux à une conversation concaténée (toutes les informations regroupées dans un seul tour) qu'à des instructions shardées.

- 😀 Le 'Snowball Effect' dans les simulations, où chaque tour répète l'information précédente et ajoute une nouvelle partie, a montré une amélioration modérée des performances.

- 😀 Les chercheurs ont recommandé que les utilisateurs redémarrent les conversations lorsque le modèle commence à perdre du contexte pour éviter la dégradation des réponses.

- 😀 Consolidation des informations dans une seule instruction peut améliorer considérablement la performance des modèles, en particulier dans des scénarios multi-tours.

- 😀 Il est suggéré que les cadres d'agents (comme AG2 ou Autogen) puissent traiter les instructions de manière plus fluide que de simplement s'appuyer sur des interactions multi-tours natives avec les LLMs.

Q & A

Quelle est la principale idée de l'étude présentée dans la vidéo ?

-L'étude analyse comment la performance des modèles de langage (LLM) varie lors des conversations en plusieurs tours comparé à des interactions en un seul tour. Elle montre que les LLMs perdent souvent en performance lorsqu'ils gèrent des informations dans des conversations multi-tours sous-spécifiées.

Quelles sont les différentes simulations utilisées pour évaluer les performances des LLMs ?

-Les simulations incluent : les instructions complètes (full), les instructions éclatées (sharded), les instructions concaténées (concat), les simulations avec récapitulation (recap) et les simulations snowball, qui ajoutent un récapitulatif à chaque tour pour tester la rétention de contexte.

Pourquoi les modèles plus petits ont-ils des performances plus faibles dans les configurations de conversation multi-tours ?

-Les modèles plus petits ont plus de difficulté à généraliser, ce qui les rend plus susceptibles de subir une dégradation de performance lorsqu'ils doivent maintenir un contexte à travers plusieurs tours de conversation.

Qu'est-ce que le phénomène 'lost in conversation' observé dans l'étude ?

-Le phénomène 'lost in conversation' désigne la perte de fiabilité et de contexte des modèles de langage lorsqu'ils interagissent dans des conversations multi-tours, ce qui entraîne des réponses incorrectes ou incohérentes à cause de la mauvaise gestion du contexte.

Quelles sont les principales recommandations pour améliorer l'efficacité des LLMs dans des conversations multi-tours ?

-Les recommandations incluent : recommencer une nouvelle conversation lorsque le modèle semble perdu et consolider les informations dans un seul prompt pour améliorer la précision et la fiabilité des réponses.

Que suggère l'étude à propos de l'importance du cadre d'agent pour la gestion des conversations multi-tours ?

-L'étude suggère que bien que les cadres d'agents (comme AG2 ou Autogen) puissent gérer des conversations multi-tours, il serait préférable que les LLMs natifs prennent en charge cette fonctionnalité pour éviter les limitations de performance observées dans les réglages actuels.

Quel impact l'ajout d'un récapitulatif à la fin des conversations a-t-il sur la performance des LLMs ?

-L'ajout d'un récapitulatif (comme dans les simulations 'recap') peut améliorer la performance en réintroduisant tout le contexte à la fin, mais cela reste une solution peu réaliste pour les utilisateurs en raison de la nature dynamique des conversations réelles.

Comment les utilisateurs peuvent-ils minimiser les erreurs des LLMs dans des conversations complexes ?

-Les utilisateurs peuvent minimiser les erreurs en réintroduisant les informations clés au début de chaque nouvelle conversation et en consolidant les exigences dans un prompt unique pour s'assurer que le modèle n'oublie pas de détails importants.

Pourquoi le fait de commencer une nouvelle conversation peut-il améliorer les résultats des LLMs ?

-Commencer une nouvelle conversation permet d'éviter que le modèle ne soit 'perdu' en raison d'assumptions incorrectes ou d'erreurs accumulées au cours de l'interaction précédente, ce qui améliore la qualité des réponses.

Quels types de tâches ont été utilisés pour tester les performances des LLMs dans cette étude ?

-Les tâches testées comprenaient la génération de code, la génération de schémas SQL, les requêtes API, les tâches mathématiques, la conversion de données en texte et la summarisation.

Outlines

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنMindmap

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنKeywords

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنHighlights

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنTranscripts

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنتصفح المزيد من مقاطع الفيديو ذات الصلة

5.0 / 5 (0 votes)