🥇 DIFERENCIA entre PRECISION y EXACTITUD | TODO lo que debes SABER | Curso de MEDICIONES ELECTRICAS

Summary

TLDREste video explica los conceptos de exactitud, precisión, cifras significativas y errores en mediciones científicas. La **exactitud** se refiere a cuán cerca está una medición del valor real, mientras que la **precisión** mide la consistencia de las mediciones. También se destacan las **cifras significativas** y cómo su cantidad influye en la precisión de las mediciones. El video sugiere buenas prácticas como realizar varias mediciones y usar instrumentos calibrados para mejorar la precisión y reducir los errores. Además, se aborda la importancia de la notación científica y el rango de error para mayor claridad y exactitud en los resultados.

Takeaways

- 😀 La **exactitud** se refiere a qué tan cerca está una medición del valor real de la variable medida, y depende de la calibración del instrumento.

- 😀 La **precisión** es la consistencia de las mediciones repetidas, independientemente de si están cerca del valor real o no.

- 😀 El **concepto de sensibilidad** se refiere a la capacidad de un instrumento para responder rápidamente a los cambios en la variable medida.

- 😀 La **resolución** de un instrumento es el cambio más pequeño que puede detectar en la medición, como por ejemplo, una resolución de 4 dígitos decimales.

- 😀 El **error de medición** es la desviación del valor real, y puede reducirse haciendo varias mediciones y usando diferentes métodos de medición o instrumentos.

- 😀 La **conformidad** se refiere a qué tan cerca está la medición del valor real de acuerdo con las limitaciones del instrumento utilizado.

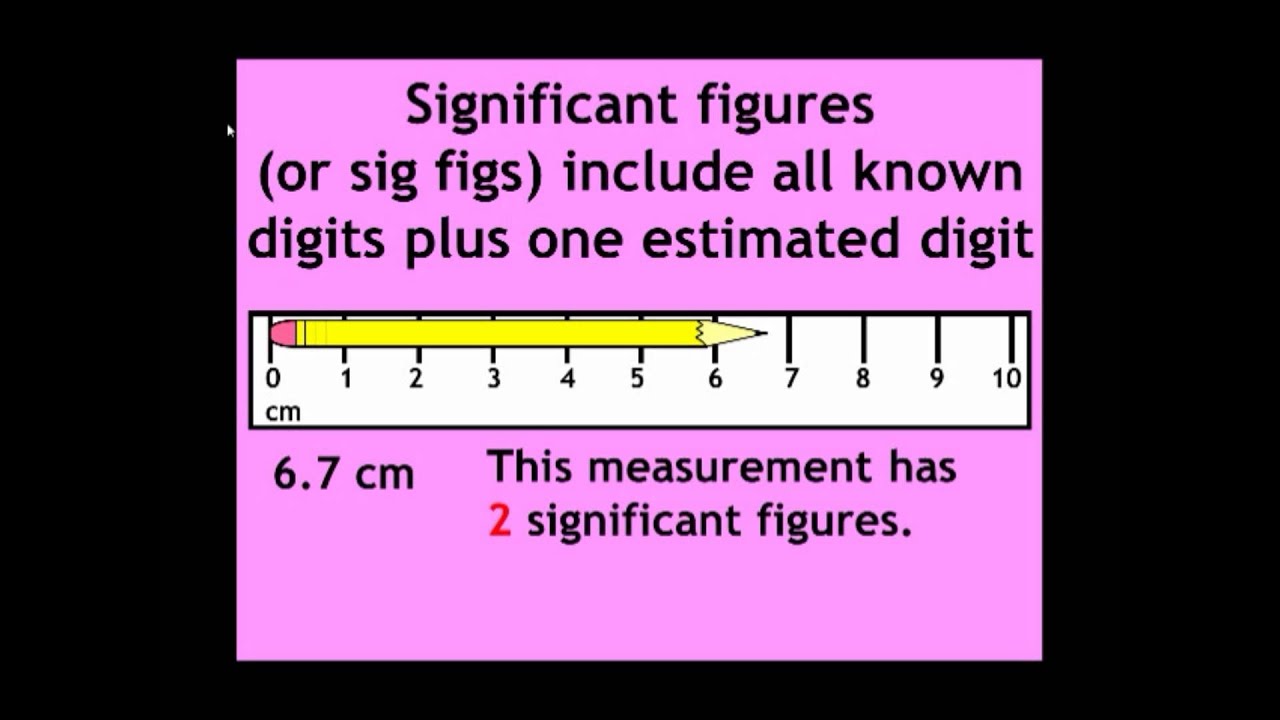

- 😀 Las **cifras significativas** indican el nivel de precisión de una medición y aumentarlas mejora la precisión del instrumento.

- 😀 El número de cifras significativas en una medición afecta su precisión, con más cifras significativas indicando una medición más precisa.

- 😀 Es importante **realizar varias mediciones** y usar **instrumentos calibrados** para obtener resultados más precisos y exactos, especialmente cuando se requieren medidas muy precisas.

- 😀 Al utilizar **notación científica**, se pueden evitar confusiones y representar de manera más clara las mediciones con muchos ceros antes del punto decimal.

Q & A

¿Cuál es la diferencia entre exactitud y precisión en la medición?

-La exactitud se refiere a cuán cerca está la medición del valor real de la variable medida, mientras que la precisión indica la consistencia o reproducibilidad de las mediciones repetidas para una misma variable.

¿Cómo se puede mejorar la precisión de una medición?

-La precisión se puede mejorar realizando varias mediciones y promediando los resultados. Además, utilizar diferentes instrumentos de medición y métodos alternativos también contribuye a mejorar la precisión.

¿Qué es la sensibilidad en un instrumento de medición?

-La sensibilidad de un instrumento es la relación entre la señal de salida y el cambio en la entrada o variable medida. Se refiere a qué tan rápidamente cambia la lectura del instrumento al modificar la variable que se está midiendo.

¿Qué es la resolución de un instrumento?

-La resolución de un instrumento es el cambio más pequeño en el valor medido que el instrumento puede detectar. Se expresa comúnmente en el número de cifras significativas después del punto decimal.

¿Qué se entiende por error en una medición?

-El error es la desviación de la medición respecto al valor real de la variable medida. Este error puede reducirse al realizar múltiples mediciones y utilizando diferentes métodos y equipos de medición.

¿Qué son las cifras significativas en una medición?

-Las cifras significativas son todos los dígitos de una medición, tanto antes como después del punto decimal, excluyendo los ceros a la derecha del último dígito significativo. Estas cifras indican la precisión de la medición.

¿Por qué es importante la notación científica en las mediciones?

-La notación científica es útil para expresar números con muchos ceros de manera más clara y precisa. Esto ayuda a evitar confusiones y facilita la lectura, especialmente cuando se trata de medidas extremadamente grandes o pequeñas.

¿Cómo afecta el número de cifras significativas a la precisión de una medición?

-A medida que aumentan las cifras significativas en una medición, la precisión del instrumento mejora. Más cifras significativas reflejan una mayor exactitud y menor rango de error en la medición.

¿Qué es el rango de error en una medición?

-El rango de error es el margen dentro del cual se espera que esté el valor real de la variable medida, considerando la precisión y el límite de error del instrumento. Se expresa comúnmente como un valor adicional o sustraído del valor medido.

¿Por qué es importante realizar varias mediciones y utilizar equipos calibrados?

-Realizar varias mediciones y utilizar equipos calibrados permite obtener una medición más precisa y confiable. Esto es especialmente importante cuando se requieren niveles de precisión o exactitud altos, como en aplicaciones científicas o técnicas específicas.

Outlines

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowMindmap

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowKeywords

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowHighlights

This section is available to paid users only. Please upgrade to access this part.

Upgrade NowTranscripts

This section is available to paid users only. Please upgrade to access this part.

Upgrade Now5.0 / 5 (0 votes)