MISTRAL AI : Comment installer GRATUITEMENT le Chat GPT Français en local ? (WebUI)

Summary

TLDRCette vidéo présente l'interface web open source Text Generation UI qui permet d'interagir localement avec des modèles d'intelligence artificielle comme Mistral. On explique comment installer et configurer cet outil, choisir un modèle IA parmi ceux proposés sur Hugging Face, et discuter avec lui via l'interface de chat. On montre aussi comment personnaliser les paramètres et créer différents avatars pour avoir des conversations adaptées au contexte.

Takeaways

- 😀 Présentation de l'interface text generation web UI pour interagir avec le modèle d'IA Mistral

- 👩💻 Installation facile via des scripts préconfigurés pour Windows, Linux ou WSL

- 🤖 Choix du modèle de langage à utiliser (Mistral, Lama, etc) et chargement dans l'interface

- ⚙️ Accès à de nombreux paramètres pour personnaliser et spécialiser l'IA selon vos besoins

- 🗣️ Possibilité de créer différents avatars/personnalités pour l'IA avec des contextes dédiés

- 🔁 Fonctionnement 100% en local, aucune donnée partagée en ligne

- ⏱️ Génération de réponses plus lente qu'avec des IA en ligne comme Google Bard

- 💡 Construire de bons « prompts » est essentiel pour obtenir de bonnes réponses de l'IA

- 📝 De nombreux cas d'usage : rédaction de contenu, développement, résumés, traduction...

- ✅ Solution adaptée pour traiter des données sensibles localement avec une IA privée

Q & A

Quel est le nom du projet open source présenté dans la vidéo ?

-Le projet open source présenté est Text Generation Web UI. Il s'agit d'une interface web permettant d'utiliser localement différents modèles de langage comme Mistral.

Quelle est la particularité du modèle Mistral par rapport aux autres modèles d'IA ?

-La particularité de Mistral est qu'il s'agit de 8 modèles en un. Mistral est capable de sélectionner les 2 meilleurs experts parmi les 8 pour répondre à chaque question.

Quelle est la différence entre le modèle Mistral 7B et Mistral Mix ?

-Mistral 7B est un modèle plus léger (5-6 Go) permettant de rivaliser avec des modèles beaucoup plus lourds. Mistral Mix est la version avec les 8 experts fusionnés, plus gourmande en ressources (30 Go).

Quels sont les avantages d'utiliser une IA conversationnelle en local ?

-Les avantages sont : pas besoin de connexion internet, confidentialité des données, possibilité d'installer plusieurs modèles et de les personnaliser sans limite, rapidité une fois configuré.

Comment personnaliser le comportement d'une IA conversationnelle ?

-On peut personnaliser le comportement de l'IA via les paramètres disponibles dans l'interface, mais aussi en rédigeant un pré-prompt, c'est-à-dire des instructions sur le rôle attendu de l'IA dans la conversation.

Qu'est-ce que le "prompt engineering" ?

-Le "prompt engineering" désigne l'art de formuler de bons prompts, c'est-à-dire les questions et les instructions données à l'IA, pour obtenir les meilleures réponses possibles.

Quelle est la différence entre cette interface et L.M. Studio présenté précédemment ?

-Cette interface est plus technique et offre plus de paramètres pour personnaliser finement les modèles d'IA. Elle est destinée aux développeurs contrairement à L.M. Studio qui vise le grand public.

Quels sont les inconvénients d'une IA conversationnelle en local ?

-Les inconvénients sont : nécessite une config PC puissante, temps de génération des réponses plus lent, prise en main plus complexe que des solutions clé en main.

Peut-on créer plusieurs avatars d'IA avec des personnalités différentes ?

-Oui, on peut créer plusieurs avatars d'IA conversationnelle, chacun avec sa propre personnalité et son propre contexte métier par exemple.

Quels sont les modèles alternatifs à Mistral?

-Les principaux modèles alternatifs sont Anthropic, Alphabet, Google Bard. On peut aussi citer Vikuna, Guanako ou L.M.A.

Outlines

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنMindmap

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنKeywords

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنHighlights

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنTranscripts

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنتصفح المزيد من مقاطع الفيديو ذات الصلة

Mistral.ai : l'IA à la Française se rapproche du GEANT AMERICAIN Microsoft

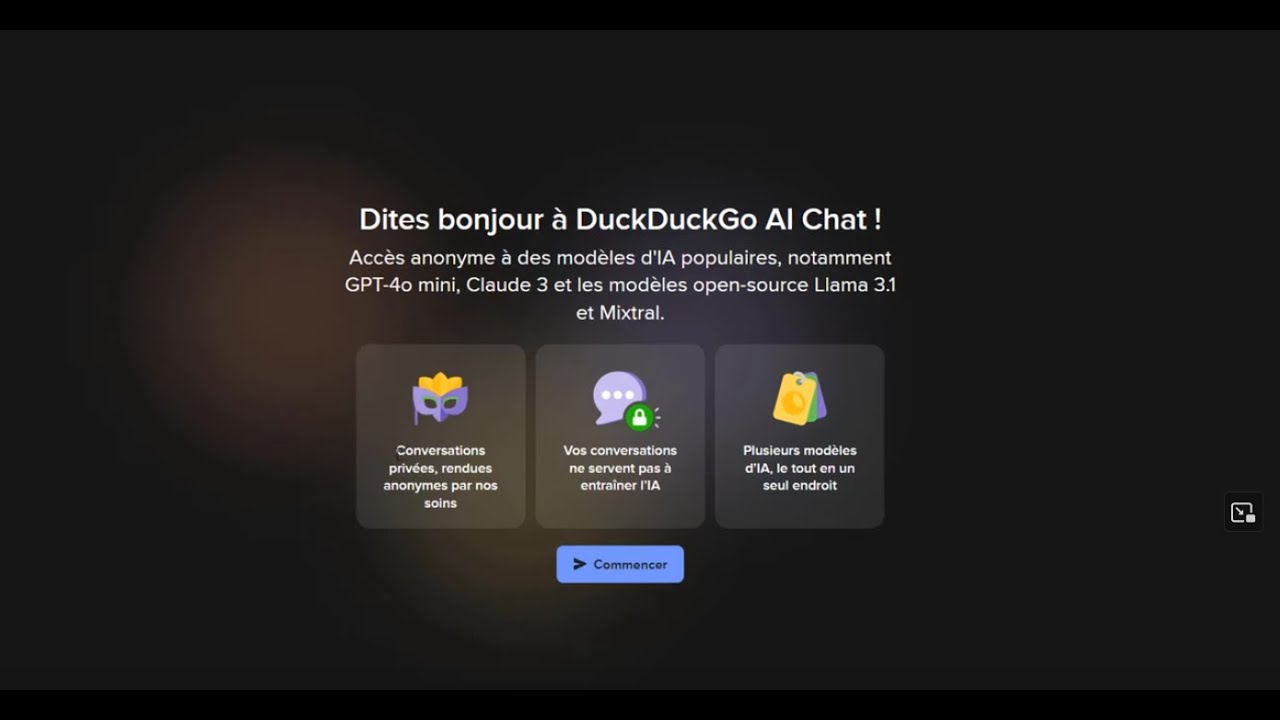

Duck Duck Go AI Chat

DuckduckGo : 4 modèles IA (dont ChatGPT) en accès libre et sans pistage !

Microsoft Copilot Studio, créer son propre Copilot !

Qu'est-ce que Microsoft Power Platform ?

11 Applications IA GRATUITES à Absolument Connaître en 2025

5.0 / 5 (0 votes)