🤖 I created an AI that TRANSLATES 🤟 SIGN LANGUAGE to TEXT 🗒️ and SPEAKS

Summary

TLDREn este video, aprenderás a crear una red neuronal capaz de traducir la Lengua de Señas Peruana (LSP) a texto, utilizando la biblioteca MediaPipe para capturar los puntos clave del cuerpo, las manos y la cara. Se explica el proceso desde la grabación de las muestras hasta la conversión de los datos a secuencias de imágenes, seguido por el entrenamiento del modelo con TensorFlow y Keras. Finalmente, se muestra cómo utilizar el modelo entrenado para predecir las palabras en tiempo real y traducirlas a texto, con la opción de hacer que el sistema también hable mediante texto a voz.

Takeaways

- 😀 El tutorial enseña cómo crear una red neuronal que traduzca Lengua de Señas Peruana (LSP) a texto, y también haga que este texto sea hablado mediante TTS (Text-To-Speech).

- 😀 El primer paso es grabar muestras de cada palabra en lengua de señas y convertir esos fragmentos de video en secuencias de imágenes, lo cual facilita la extracción de puntos clave de la cara, manos y cuerpo.

- 😀 Se utiliza el modelo Holistic de MediaPipe para detectar las manos, rostro y cuerpo de las personas en los videos, lo que permite obtener los puntos clave necesarios para entrenar la red neuronal.

- 😀 Las imágenes grabadas se procesan y se guardan como secuencias de puntos clave, que son almacenadas en un archivo `.h5` para su posterior uso en el entrenamiento de la red neuronal.

- 😀 Durante el proceso de entrenamiento, la red neuronal se alimenta con las secuencias de puntos clave y las etiquetas correspondientes, que representan las palabras en lengua de señas.

- 😀 La red neuronal se entrena usando TensorFlow y Keras, y una vez entrenada, puede traducir palabras en lengua de señas a texto con alta precisión.

- 😀 El proceso de entrenamiento involucra la preparación de entradas (puntos clave) y salidas (palabras) y asegura que todos los datos tengan el mismo formato para ser procesados adecuadamente.

- 😀 Una vez entrenado el modelo, se evalúa utilizando un programa que detecta las señas realizadas en tiempo real y las traduce a texto utilizando el modelo previamente entrenado.

- 😀 El modelo tiene un umbral de precisión del 70%, y si la predicción supera este umbral, se traduce la seña detectada a la palabra correspondiente.

- 😀 El script también incluye la implementación de un sistema de texto a voz (TTS) que pronuncia la palabra traducida, utilizando Google TTS y Pygame para la reproducción de audio.

- 😀 El tutorial finaliza invitando a los usuarios a comentar sobre dudas o ideas adicionales, y anima a explorar más contenido relacionado con inteligencia artificial en el canal.

Q & A

¿Cómo se graban las muestras de lenguaje de señas para entrenar la red neuronal?

-Se graban las muestras usando una cámara, y el programa comienza a grabar cuando las manos entran en la toma y deja de grabar cuando las manos salen. Esto permite obtener las secuencias de video necesarias para cada palabra en lenguaje de señas.

¿Por qué se convierten los fragmentos de video en secuencias de imágenes?

-Se convierten en secuencias de imágenes porque necesitamos analizar cada imagen de manera separada para extraer los puntos clave de las manos, la cara y el cuerpo, lo cual es esencial para entrenar la red neuronal.

¿Qué es el modelo Holistic de MediaPipe y cómo se utiliza en este proyecto?

-El modelo Holistic de MediaPipe es una herramienta desarrollada por Google que permite hacer seguimiento de objetos, manos, y el rostro en imágenes y videos. En este proyecto, se usa para detectar y extraer los puntos clave de las manos, la cara y el cuerpo durante la grabación de las muestras de lenguaje de señas.

¿Cuál es el propósito de los archivos `.h5` en este proyecto?

-El archivo `.h5` se utiliza para almacenar las secuencias de puntos clave extraídos de las muestras de lenguaje de señas. Este archivo es necesario para entrenar la red neuronal y posteriormente evaluar el modelo.

¿Qué tecnologías se utilizan para entrenar la red neuronal en este proyecto?

-Se utiliza TensorFlow y Keras. TensorFlow es una biblioteca de código abierto para el aprendizaje automático, y Keras es una interfaz de alto nivel que simplifica la construcción y entrenamiento de modelos sobre TensorFlow.

¿Cómo se preparan los datos para entrenar la red neuronal?

-Los datos se preparan extrayendo las secuencias de puntos clave de las muestras de lenguaje de señas y luego se organizan en un formato adecuado para el entrenamiento. Se asegura que todas las secuencias tengan la misma longitud, por ejemplo, 15 cuadros, y se construye una matriz de identidad para las etiquetas de salida.

¿Por qué es importante que todas las secuencias de entrada tengan la misma longitud?

-Es importante porque las redes neuronales requieren que todas las entradas tengan un tamaño uniforme para procesarlas correctamente. En este caso, se utiliza un número fijo de 15 cuadros por secuencia para garantizar la consistencia en la entrada de datos.

¿Cómo se evalúa el rendimiento de la red neuronal entrenada?

-El rendimiento de la red neuronal se evalúa utilizando un programa que captura las señales de lenguaje de señas a través de la cámara. El modelo predice la palabra correspondiente a la secuencia de puntos clave detectados y se compara con la señal original para verificar la precisión.

¿Qué pasa cuando el modelo realiza una predicción sobre una señal de lenguaje de señas?

-El modelo devuelve una lista con porcentajes de similitud entre la señal detectada y las palabras posibles. Si alguno de los valores supera un umbral (por ejemplo, 70%), se selecciona esa palabra como la predicción y se muestra en la pantalla o se lee en voz alta mediante un sistema de texto a voz.

¿Cómo se implementa la función de texto a voz (TTS) en este proyecto?

-Se utiliza Google Text-to-Speech (TTS) junto con Pygame para reproducir el texto traducido como audio. Cuando el modelo predice una palabra, esta se inserta en una lista que luego se lee en voz alta para que el usuario escuche la traducción de la señal.

Outlines

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنMindmap

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنKeywords

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنHighlights

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنTranscripts

هذا القسم متوفر فقط للمشتركين. يرجى الترقية للوصول إلى هذه الميزة.

قم بالترقية الآنتصفح المزيد من مقاطع الفيديو ذات الصلة

Clase 1 nivel básico LENGUA DE SEÑAS MEXICANA

Componentes de la Lengua de Señas Mexicana

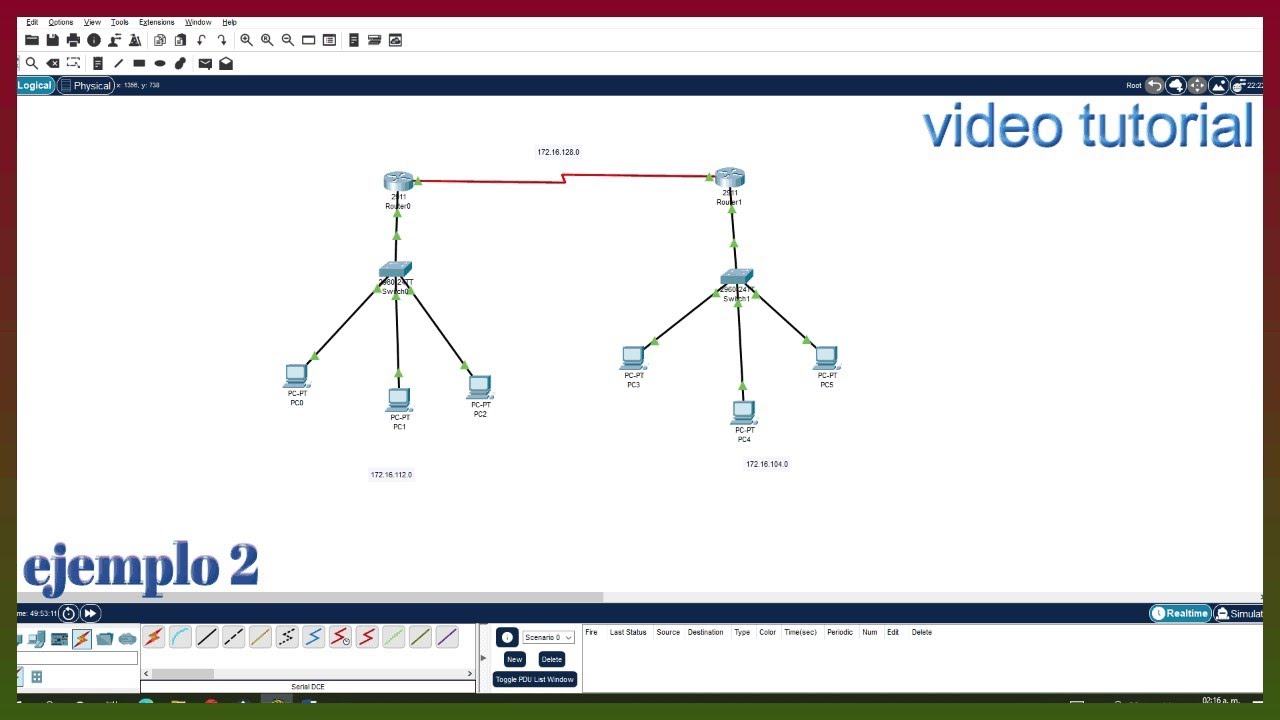

Cisco Packet Tracer – video 2: Como crear una red, utilizando 2 Routers de forma rápida y sencilla.

Crea tu propia red neuronal que puede leer

Conociendo la importancia de la lengua de señas

Estructura artículo informativo

5.0 / 5 (0 votes)